mirror of

https://github.com/didi/KnowStreaming.git

synced 2026-01-02 02:02:13 +08:00

[Init]官网文档Init

This commit is contained in:

36

product/1-brief-introduction.md

Normal file

36

product/1-brief-introduction.md

Normal file

@@ -0,0 +1,36 @@

|

||||

---

|

||||

order: 1

|

||||

title: '1.产品简介'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

## 1.1、产品简介

|

||||

|

||||

`Know Streaming` 是一套云原生的 Kafka 管控平台,脱胎于众多互联网内部多年的 Kafka 运营实践经验,专注于 Kafka 运维管控、监控告警、资源治理、多活容灾等核心场景,在用户体验、监控、运维管控上进行了平台化、可视化、智能化的建设,提供一系列特色的功能,极大地方便了用户和运维人员的日常使用,让普通运维人员都能成为 Kafka 专家。

|

||||

|

||||

---

|

||||

|

||||

## 1.2、产品特点

|

||||

|

||||

**👀 0 侵入、全覆盖**

|

||||

不会对 Apache Kafka 做侵入性改造,就能一键纳管 0.10.x-3.x.x 众多版本 Kafka(包含 ZK 或 Raft 运行模式的版本),在兼容架构上具备良好的扩展性,帮助您提升集群管理水平

|

||||

|

||||

**👏 0 成本、界面化**

|

||||

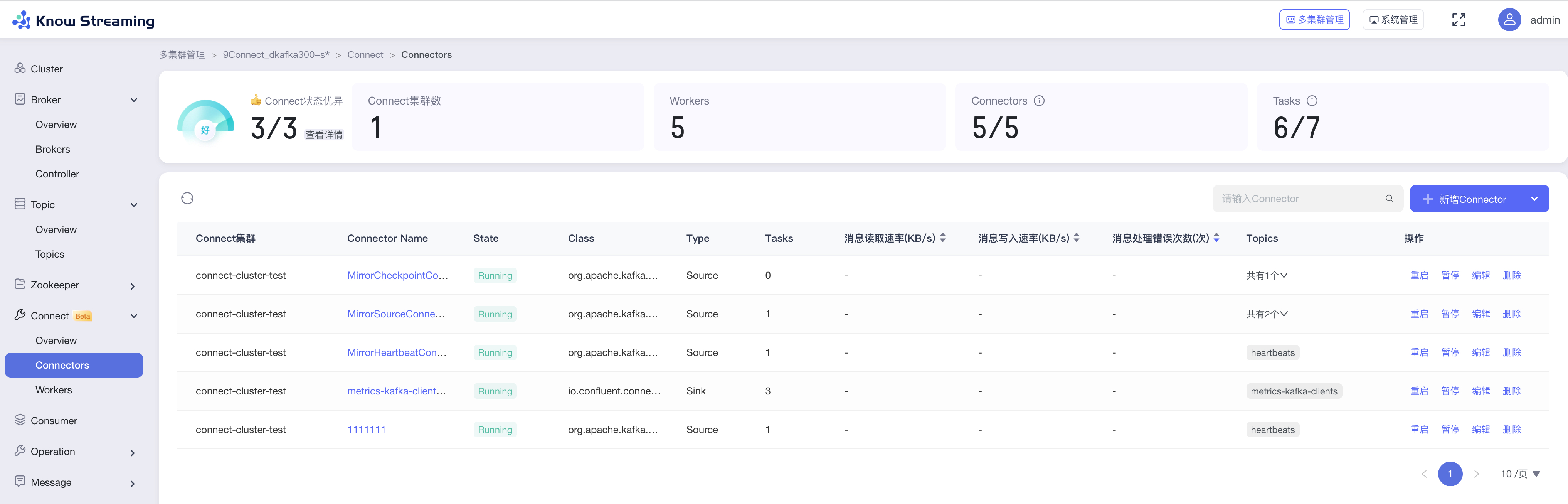

通过提炼高频的 CLI 能力,设计合理的产品使用路径,提供清新美观的 GUI 界面,支持 Cluster、Broker、Topic、Message、Consumer、ALC 等组件 GUI 管理,普通用户 5 分钟即可上手

|

||||

|

||||

**⚡️ 云原生、插件化**

|

||||

基于云原生构建的 Kafka 管控平台,具备水平扩展能力,只需要增加节点即可获取更强的采集及对外服务能力,提供众多可热插拔的企业级特性,覆盖可观测性生态整合、资源治理、多活容灾等核心场景

|

||||

|

||||

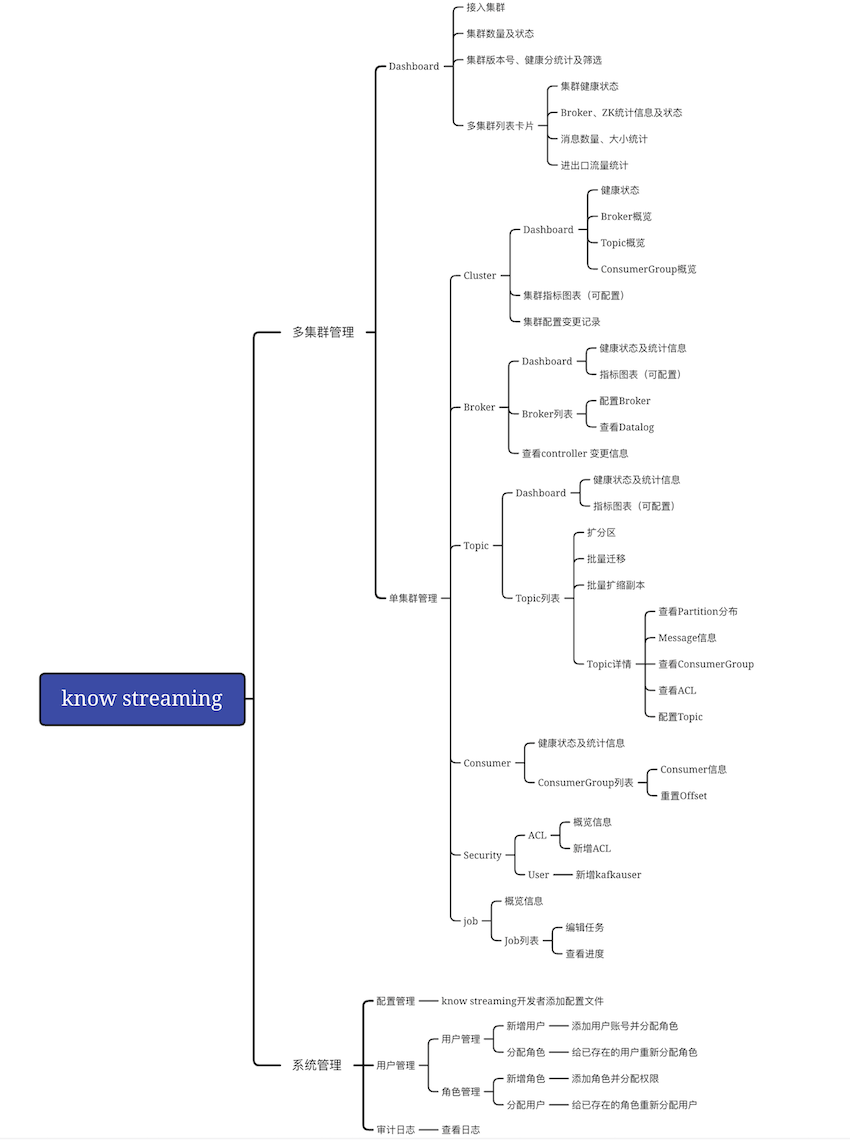

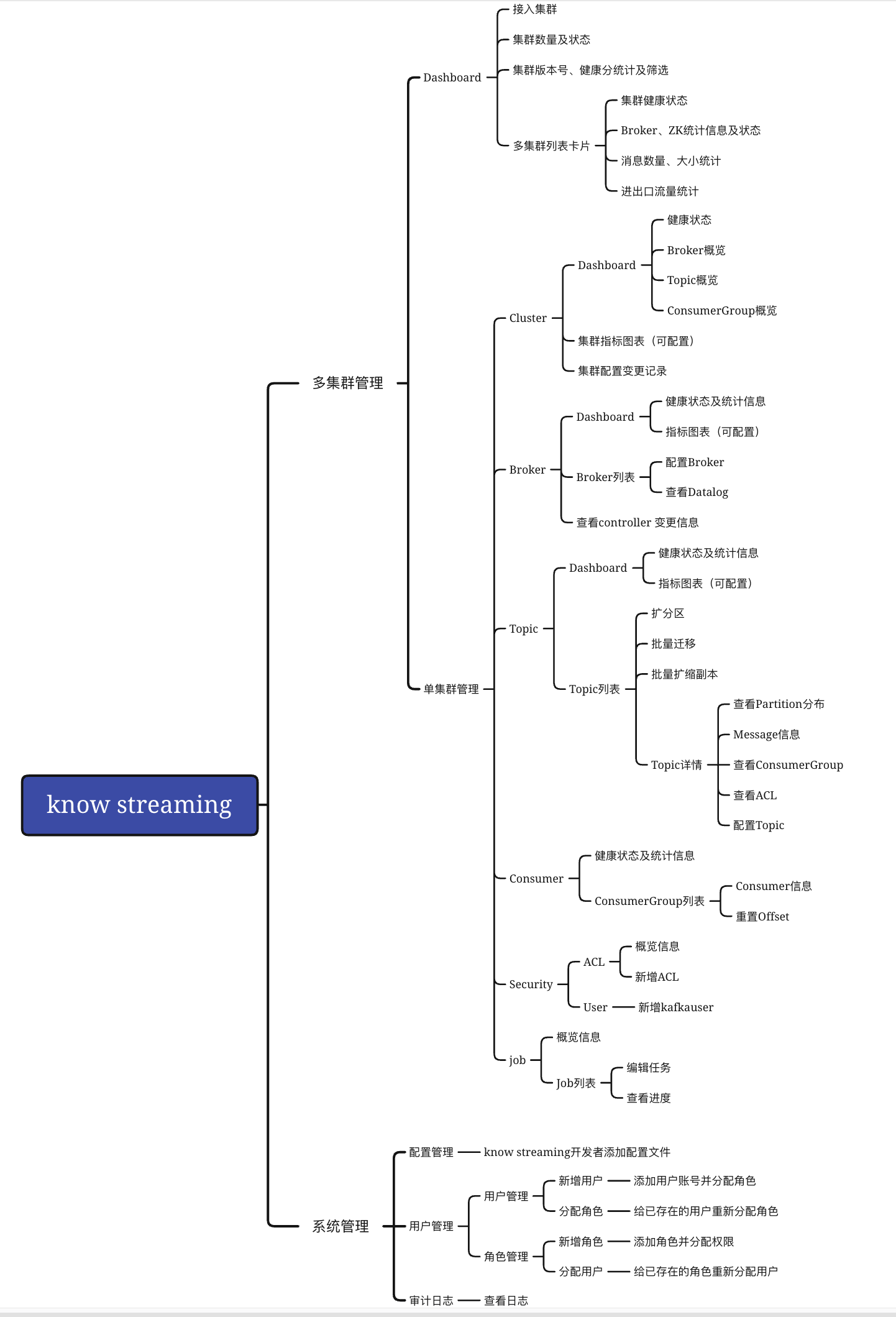

**🌪️ 功能丰富**

|

||||

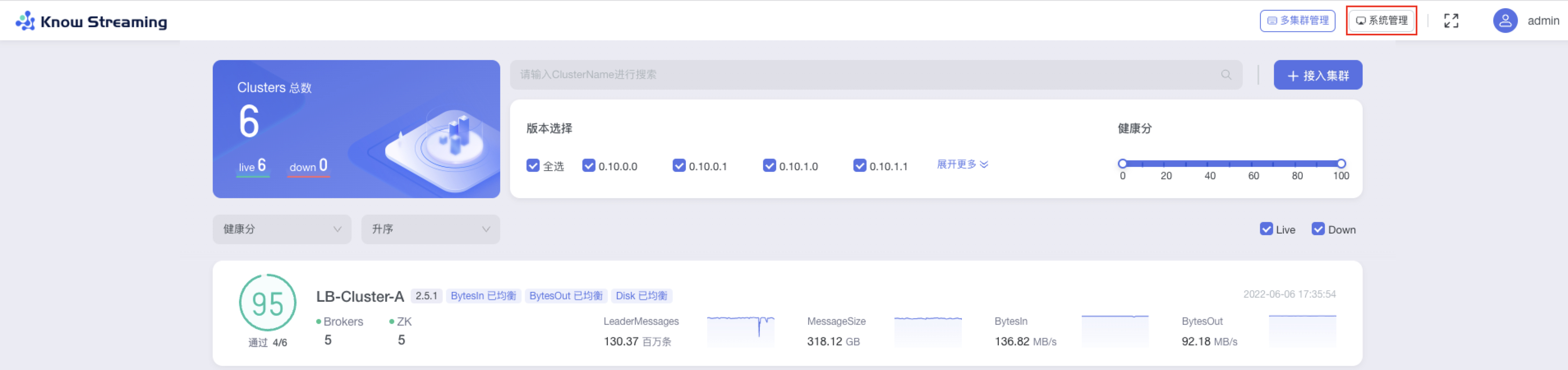

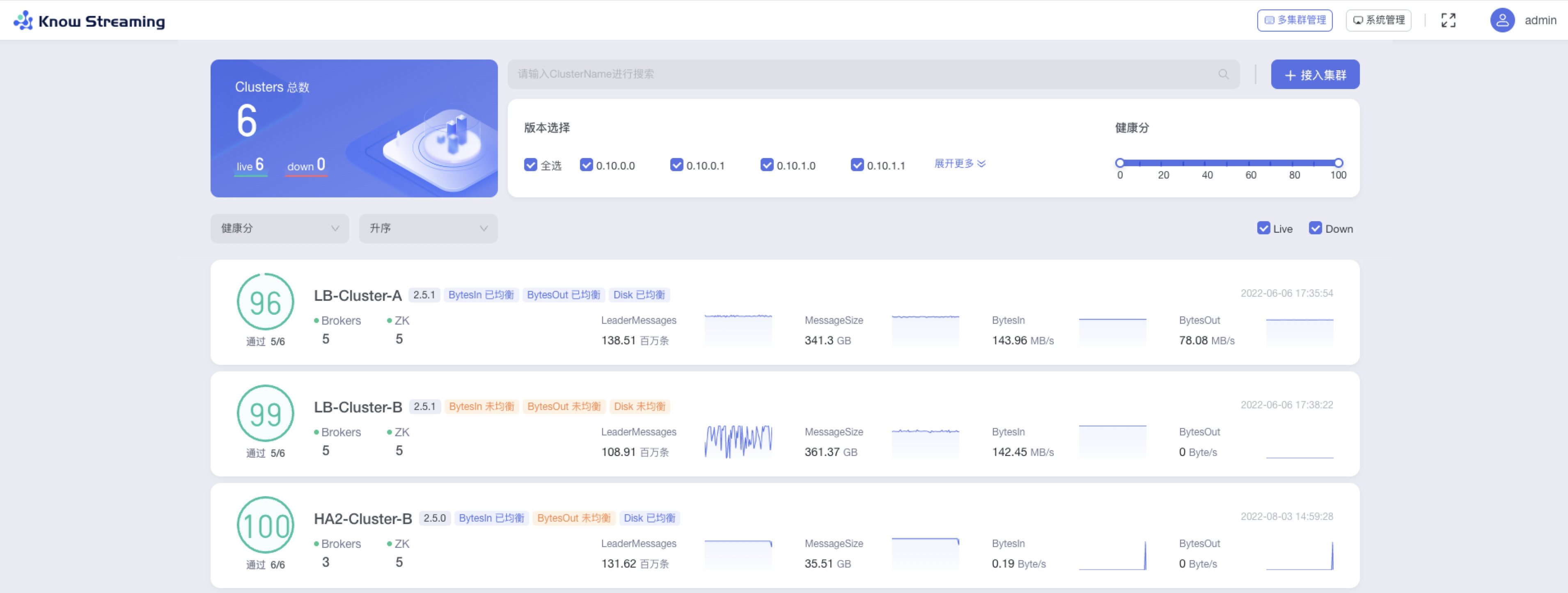

主要包含多集群管理和系统管理两大块,具体包含:

|

||||

|

||||

- 多集群管理:包括 Cluster 管理、Broker 管理、Topic 管理、Group 管理、Message 测试、Security 管理、Jobs 管理等 7 大功能模块,几乎涵盖 CLI 的所有高频能力

|

||||

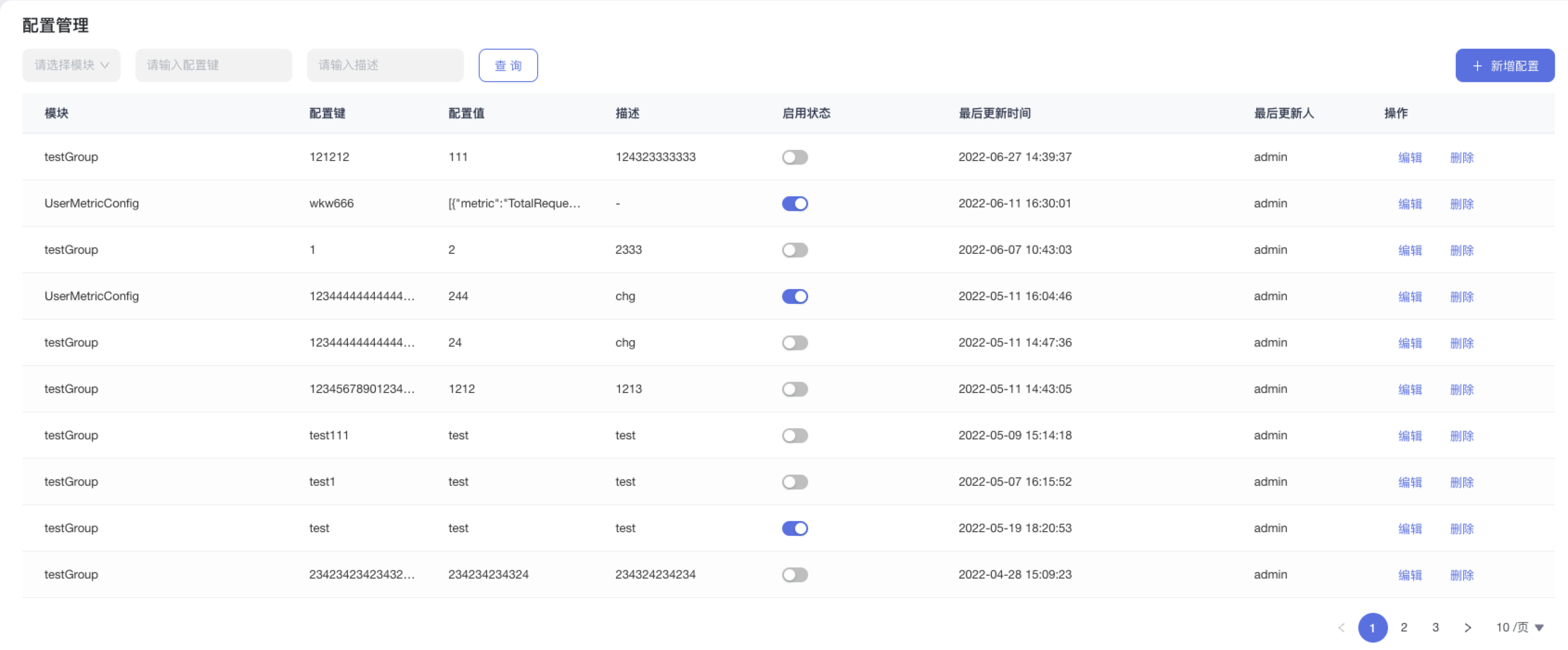

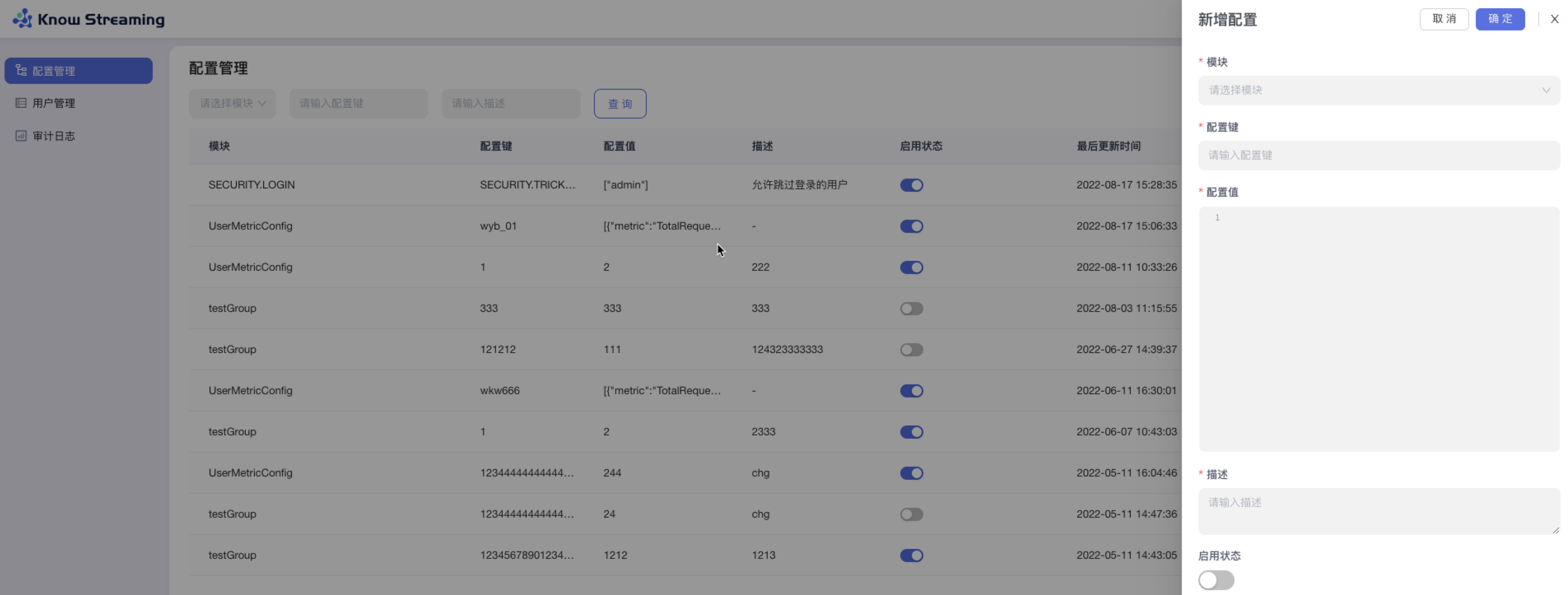

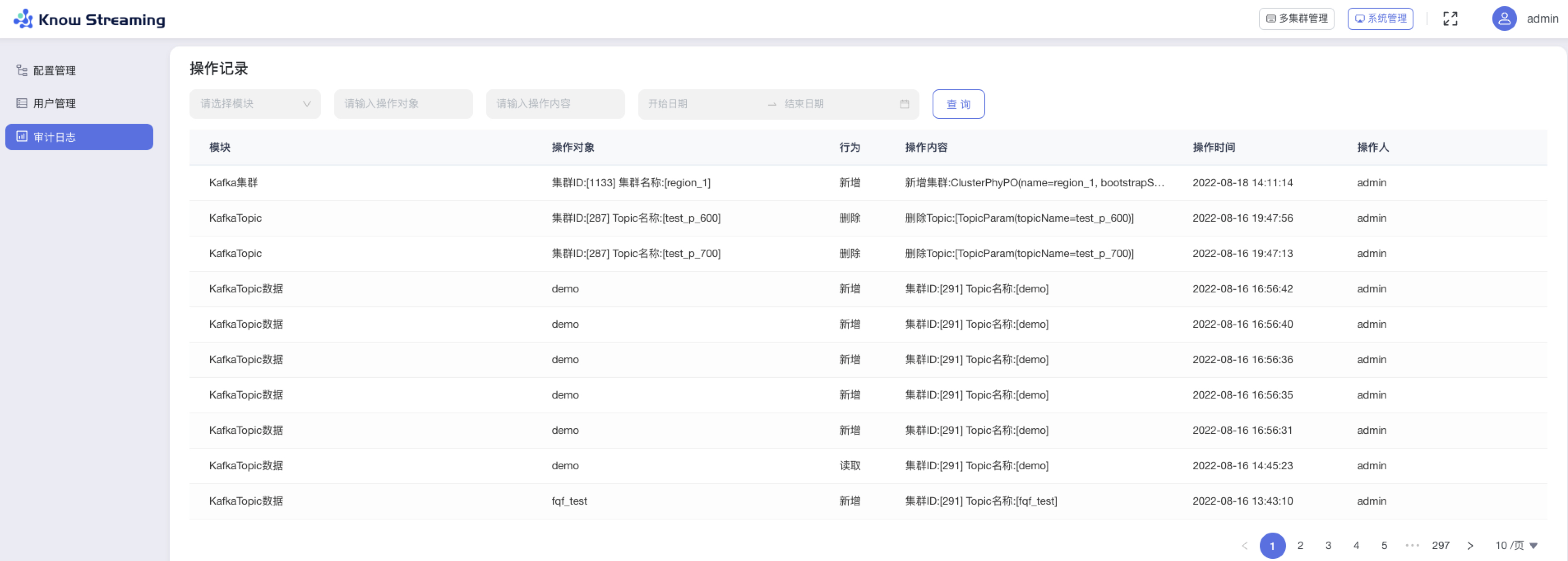

- 系统管理:包括配置管理、用户管理、审计日志等 3 大功能模块,基本满足开源用户的使用需要

|

||||

|

||||

**🚀 专业能力**

|

||||

不仅是 CLI 到 GUI 的优秀翻译,更是涵盖一系列专业能力的产品,包括但不限于:

|

||||

|

||||

- 集群管理:支持集群一键纳管,健康分析、核心组件观测 等功能

|

||||

- 观测提升:多维度指标观测大盘、观测指标最佳实践 等功能

|

||||

- 异常巡检:集群多维度健康巡检、集群多维度健康分 等功能

|

||||

- 能力增强:Topic 扩分区、Topic 扩缩副本、Topic 副本迁移 等功能

|

||||

427

product/10-contribution.md

Normal file

427

product/10-contribution.md

Normal file

@@ -0,0 +1,427 @@

|

||||

---

|

||||

order: 10

|

||||

title: '10.开源共建'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

## 10.1 贡献源码

|

||||

|

||||

欢迎 👏🏻 来到 KnowStreaming!本文档是关于如何为 KnowStreaming 做出贡献的指南。

|

||||

|

||||

如果您发现不正确或遗漏的内容, 请留下意见/建议。

|

||||

|

||||

#### 行为守则

|

||||

|

||||

请务必阅读并遵守我们的 [行为准则](https://github.com/didi/KnowStreaming/blob/master/CODE_OF_CONDUCT.md).

|

||||

|

||||

#### 贡献

|

||||

|

||||

**KnowStreaming** 欢迎任何角色的新参与者,包括 **User** 、**Contributor**、**Committer**、**PMC** 。

|

||||

|

||||

我们鼓励新人积极加入 **KnowStreaming** 项目,从 User 到 Contributor、Committer ,甚至是 PMC 角色。

|

||||

|

||||

为了做到这一点,新人需要积极地为 **KnowStreaming** 项目做出贡献。以下介绍如何对 **KnowStreaming** 进行贡献。

|

||||

|

||||

##### 创建/打开 Issue

|

||||

|

||||

如果您在文档中发现拼写错误、在代码中**发现错误**或想要**新功能**或想要**提供建议**,您可以在 GitHub 上[创建一个 Issue](https://github.com/didi/KnowStreaming/issues/new/choose) 进行报告。

|

||||

|

||||

如果您想直接贡献, 您可以选择下面标签的问题。

|

||||

|

||||

- [contribution welcome](https://github.com/didi/KnowStreaming/labels/contribution%20welcome) : 非常需要解决/新增 的 Issues

|

||||

- [good first issue](https://github.com/didi/KnowStreaming/labels/good%20first%20issue): 对新人比较友好, 新人可以拿这个 Issue 来练练手热热身。

|

||||

|

||||

<font color=red ><b> 请注意,任何 PR 都必须与有效 issue 相关联。否则,PR 将被拒绝。</b></font>

|

||||

|

||||

##### 开始你的贡献

|

||||

|

||||

**分支介绍**

|

||||

|

||||

我们将 `master`分支作为开发分支, 说明这是一个不稳定的分支。

|

||||

|

||||

此外,我们的分支模型符合 [https://nvie.com/posts/a-successful-git-branching-model/](https://nvie.com/posts/a-successful-git-branching-model/). 我们强烈建议新人在创建 PR 之前先阅读上述文章。

|

||||

|

||||

**贡献流程**

|

||||

|

||||

为方便描述,我们这里定义一下 2 个名词:

|

||||

|

||||

自己 Fork 出来的仓库是私人仓库, 我们这里称之为 :**分叉仓库**

|

||||

Fork 的源项目,我们称之为:**源仓库**

|

||||

|

||||

现在,如果您准备好创建 PR, 以下是贡献者的工作流程:

|

||||

|

||||

1. Fork [KnowStreaming](https://github.com/didi/KnowStreaming) 项目到自己的仓库

|

||||

|

||||

2. 从源仓库的`master`拉取并创建自己的本地分支,例如: `master`

|

||||

3. 在本地分支上对代码进行修改

|

||||

4. Rebase 开发分支, 并解决冲突

|

||||

5. commit 并 push 您的更改到您自己的**分叉仓库**

|

||||

6. 创建一个 Pull Request 到**源仓库**的`master`分支中。

|

||||

7. 等待回复。如果回复的慢,请无情的催促。

|

||||

|

||||

更为详细的贡献流程请看下面的:[10.2 贡献流程]()

|

||||

|

||||

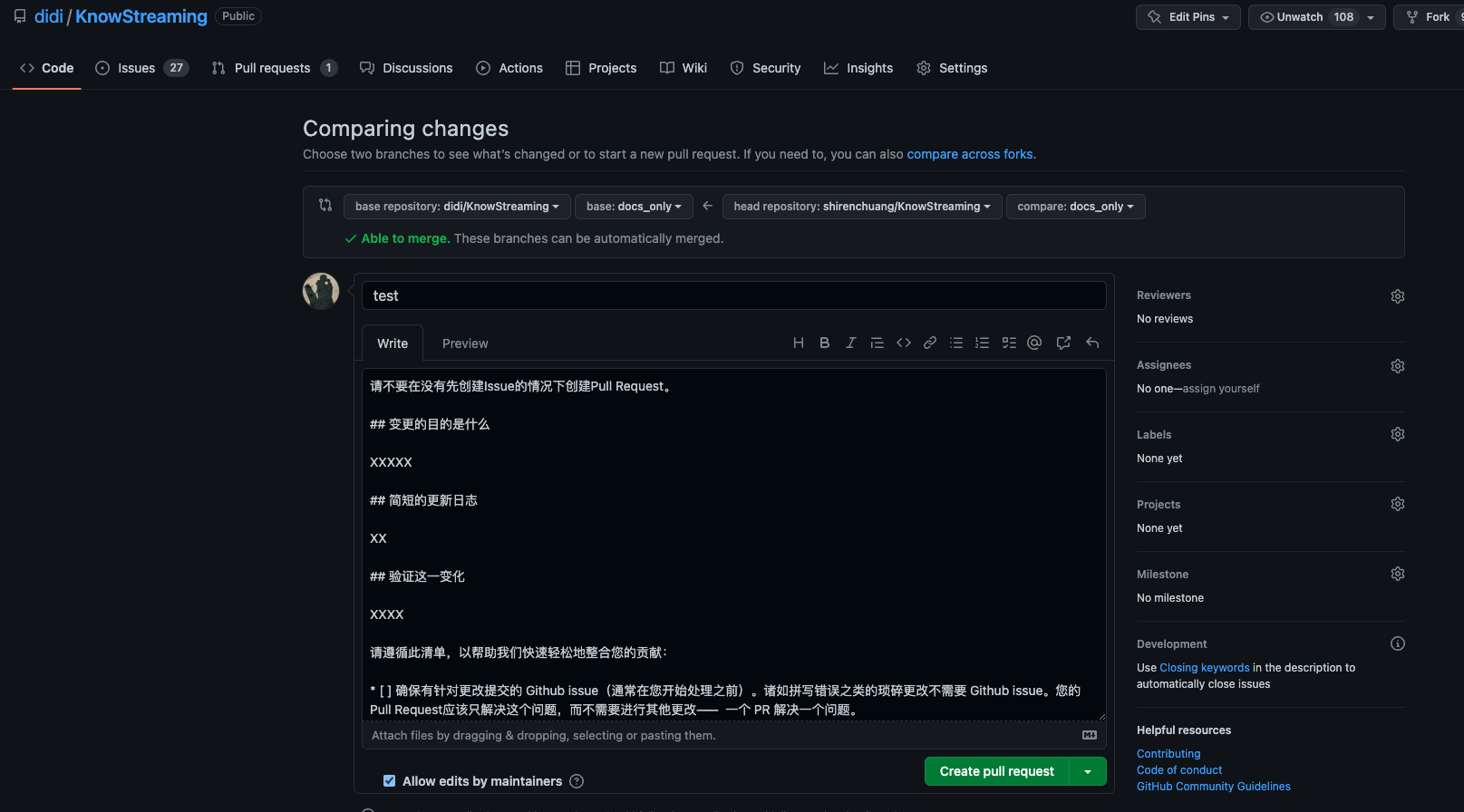

创建 Pull Request 时:

|

||||

|

||||

1. 请遵循 PR 的 [模板](https://github.com/didi/KnowStreaming/blob/master/.github/PULL_REQUEST_TEMPLATE.md)

|

||||

2. 请确保 PR 有相应的 issue。

|

||||

3. 如果您的 PR 包含较大的更改,例如组件重构或新组件,请编写有关其设计和使用的详细文档(在对应的 issue 中)。

|

||||

4. 注意单个 PR 不能太大。如果需要进行大量更改,最好将更改分成几个单独的 PR。

|

||||

5. 在合并 PR 之前,尽量的将最终的提交信息清晰简洁, 将多次修改的提交尽可能的合并为一次提交。

|

||||

6. 创建 PR 后,将为 PR 分配一个或多个 reviewers。

|

||||

|

||||

<font color=red><b>如果您的 PR 包含较大的更改,例如组件重构或新组件,请编写有关其设计和使用的详细文档。</b></font>

|

||||

|

||||

#### 代码审查指南

|

||||

|

||||

Commiter 将轮流 review 代码,以确保在合并前至少有一名 Commiter

|

||||

|

||||

一些原则:

|

||||

|

||||

- 可读性——重要的代码应该有详细的文档。API 应该有 Javadoc。代码风格应与现有风格保持一致。

|

||||

- 优雅:新的函数、类或组件应该设计得很好。

|

||||

- 可测试性——单元测试用例应该覆盖 80% 的新代码。

|

||||

- 可维护性 - 遵守我们的编码规范。

|

||||

|

||||

#### 开发者

|

||||

|

||||

##### 成为 Contributor

|

||||

|

||||

只要成功提交并合并 PR , 则为 Contributor

|

||||

|

||||

贡献者名单请看:[贡献者名单]()

|

||||

|

||||

##### 尝试成为 Commiter

|

||||

|

||||

一般来说, 贡献 8 个重要的补丁并至少让三个不同的人来 Review 他们(您需要 3 个 Commiter 的支持)。

|

||||

然后请人给你提名, 您需要展示您的

|

||||

|

||||

1. 至少 8 个重要的 PR 和项目的相关问题

|

||||

2. 与团队合作的能力

|

||||

3. 了解项目的代码库和编码风格

|

||||

4. 编写好代码的能力

|

||||

|

||||

当前的 Commiter 可以通过在 KnowStreaming 中的 Issue 标签 `nomination`(提名)来提名您

|

||||

|

||||

1. 你的名字和姓氏

|

||||

2. 指向您的 Git 个人资料的链接

|

||||

3. 解释为什么你应该成为 Commiter

|

||||

4. 详细说明提名人与您合作的 3 个 PR 以及相关问题,这些问题可以证明您的能力。

|

||||

|

||||

另外 2 个 Commiter 需要支持您的**提名**,如果 5 个工作日内没有人反对,您就是提交者,如果有人反对或者想要更多的信息,Commiter 会讨论并通常达成共识(5 个工作日内) 。

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

<hr>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

## 10.2 贡献流程

|

||||

|

||||

#### 贡献流程

|

||||

|

||||

[贡献源码细则](./././CONTRIBUTING.md)

|

||||

|

||||

##### 1. fork didi/KnowStreaming 项目到您的 github 库

|

||||

|

||||

找到你要 Fork 的项目,例如 [KnowStreaming](https://github.com/didi/KnowStreaming) ,点击 Fork 按钮。

|

||||

|

||||

|

||||

|

||||

##### 2. 克隆或下载您 fork 的 Know Streaming 代码仓库到您本地

|

||||

|

||||

```sh

|

||||

|

||||

git clone { your fork knowstreaming repo address }

|

||||

|

||||

cd KnowStreaming

|

||||

|

||||

```

|

||||

|

||||

##### 3. 添加 didi/KnowStreaming 仓库为 upstream 仓库

|

||||

|

||||

```sh

|

||||

|

||||

### 添加源仓库

|

||||

git remote add upstream https://github.com/didi/KnowStreaming

|

||||

|

||||

### 查看是否添加成功

|

||||

git remote -v

|

||||

|

||||

origin ${your fork KnowStreaming repo address} (fetch)

|

||||

origin ${your fork KnowStreaming repo address} (push)

|

||||

upstream https://github.com/didi/KnowStreaming(fetch)

|

||||

upstream https://github.com/didi/KnowStreaming (push)

|

||||

|

||||

### 获取源仓库的基本信息

|

||||

git fetch origin

|

||||

git fetch upstream

|

||||

|

||||

```

|

||||

|

||||

上面是将 didi/KnowStreaming 添加为远程仓库, 当前就会有 2 个远程仓库

|

||||

|

||||

1. origin : 你 Fork 出来的分叉仓库

|

||||

2. upstream : 源仓库

|

||||

|

||||

git fetch 获取远程仓库的基本信息, 比如 **源仓库**的所有分支就获取到了

|

||||

|

||||

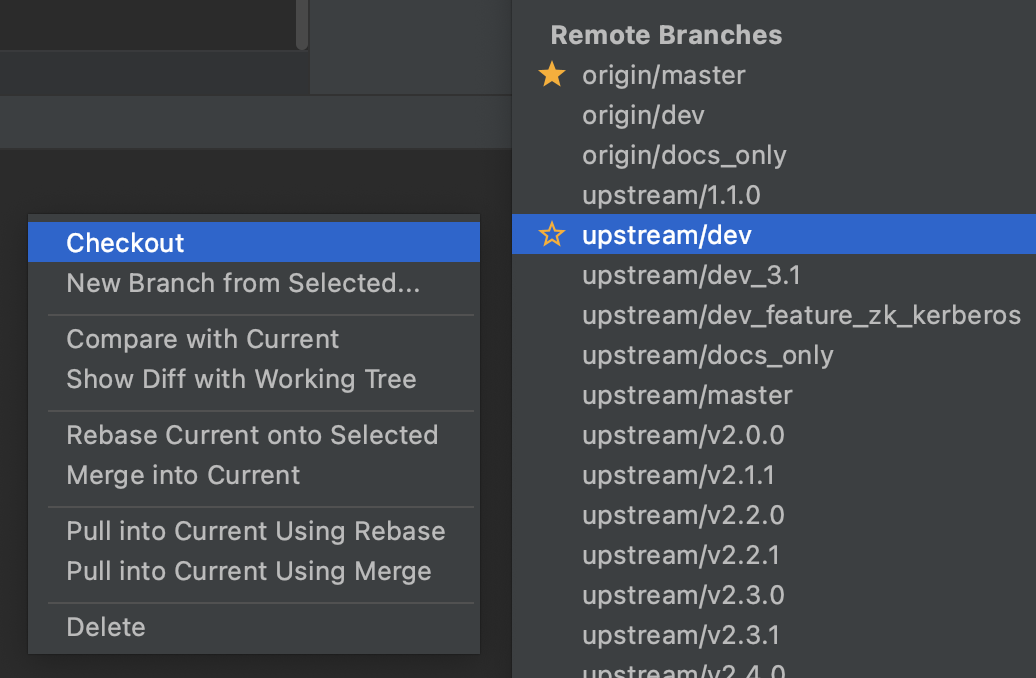

##### 4. 同步源仓库开发分支到本地分叉仓库中

|

||||

|

||||

一般开源项目都会有一个给贡献者提交代码的分支,例如 KnowStreaming 的分支是 `master`;

|

||||

|

||||

首先我们要将 **源仓库**的开发分支(`master`) 拉取到本地仓库中

|

||||

|

||||

```sh

|

||||

|

||||

git checkout -b master upstream/master

|

||||

```

|

||||

|

||||

**或者 IDEA 的形式创建**

|

||||

|

||||

|

||||

|

||||

##### 5. 在本地新建的开发分支上进行修改

|

||||

|

||||

首先请保证您阅读并正确设置 KnowStreaming code style, 相关内容请阅读[KnowStreaming 代码规约 ]()。

|

||||

|

||||

修改时请保证该分支上的修改仅和 issue 相关,并尽量细化,做到

|

||||

|

||||

<font color=red><b>一个分支只修改一件事,一个 PR 只修改一件事</b></font>。

|

||||

|

||||

同时,您的提交记录请尽量描述清楚,主要以谓 + 宾进行描述,如:Fix xxx problem/bug。少量简单的提交可以使用 For xxx 来描述,如:For codestyle。 如果该提交和某个 ISSUE 相关,可以添加 ISSUE 号作为前缀,如:For #10000, Fix xxx problem/bug。

|

||||

|

||||

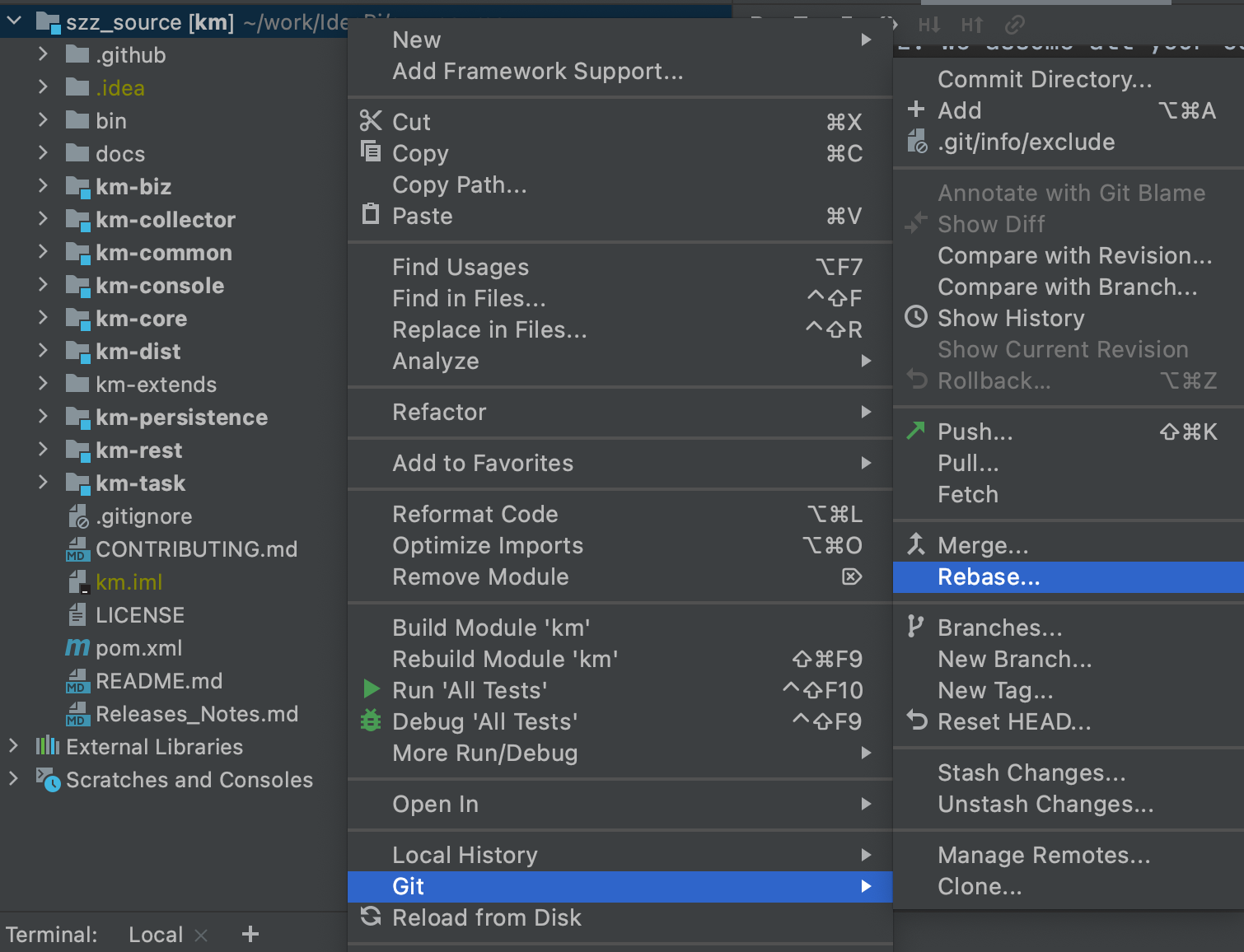

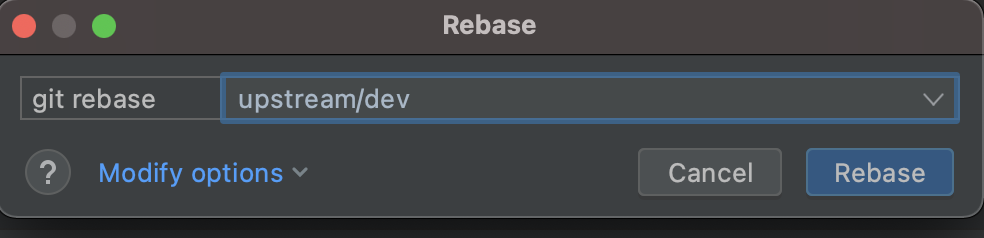

##### 6. Rebase 基础分支和开发分支

|

||||

|

||||

您修改的时候,可能别人的修改已经提交并被合并,此时可能会有冲突,这里请使用 rebase 命令进行合并解决,主要有 2 个好处:

|

||||

|

||||

1. 您的提交记录将会非常优雅,不会出现 Merge xxxx branch 等字样

|

||||

2. rebase 后您分支的提交日志也是一条单链,基本不会出现各种分支交错的情况,回查时更轻松

|

||||

|

||||

```sh

|

||||

git fetch upstream

|

||||

|

||||

git rebase -i upstream/master

|

||||

|

||||

```

|

||||

|

||||

**或者在 IDEA 的操作如下**

|

||||

|

||||

|

||||

|

||||

选择 源仓库的开发分支

|

||||

|

||||

|

||||

|

||||

推荐使用 IDEA 的方式, 有冲突的时候更容易解决冲突问题。

|

||||

|

||||

##### 7. 将您开发完成 rebase 后的分支,上传到您 fork 的仓库

|

||||

|

||||

```sh

|

||||

git push origin master

|

||||

```

|

||||

|

||||

特别要注意的是:在 push 之前 尽量将您的多次 commit 信息 合并成一次 commit 信息,这样会非常的简洁

|

||||

|

||||

##### 8. 按照 PR 模板中的清单创建 Pull Request

|

||||

|

||||

|

||||

|

||||

选择自己的分支合并到模板分支。

|

||||

|

||||

##### 9. 等待合并代码

|

||||

|

||||

提交了 PR 之后,需要等待 PMC、Commiter 来 Review 代码,如果有问题需要配合修改重新提交。

|

||||

|

||||

如果没有问题会直接合并到开发分支`master`中。

|

||||

|

||||

注: 如果长时间没有 review, 则可以多催促社区来 Review 代码!

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

<hr>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

## 10.3 Pull Request 模板

|

||||

|

||||

请不要在没有先创建 Issue 的情况下创建 Pull Request。

|

||||

|

||||

#### 变更的目的是什么

|

||||

|

||||

XXXXX

|

||||

|

||||

#### 简短的更新日志

|

||||

|

||||

XX

|

||||

|

||||

#### 验证这一变化

|

||||

|

||||

XXXX

|

||||

|

||||

请遵循此清单,以帮助我们快速轻松地整合您的贡献:

|

||||

|

||||

- [ ] 确保有针对更改提交的 Github issue(通常在您开始处理之前)。诸如拼写错误之类的琐碎更改不需要 Github issue。您的 Pull Request 应该只解决这个问题,而不需要进行其他更改—— 一个 PR 解决一个问题。

|

||||

- [ ] 格式化 Pull Request 标题,如[ISSUE #123] support Confluent Schema Registry。 Pull Request 中的每个提交都应该有一个有意义的主题行和正文。

|

||||

- [ ] 编写足够详细的 Pull Request 描述,以了解 Pull Request 的作用、方式和原因。

|

||||

- [ ] 编写必要的单元测试来验证您的逻辑更正。如果提交了新功能或重大更改,请记住在 test 模块中添加 integration-test

|

||||

- [ ] 确保编译通过,集成测试通过

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

<hr>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

## 10.4 如果提交问题报告

|

||||

|

||||

在[提交问题](https://github.com/didi/KnowStreaming/issues/new/choose)的时候,请选择合适的模板来创建。

|

||||

|

||||

按照每个类型的问题模板描述清楚!

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

<hr>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

## 10.5 开源激励计划

|

||||

|

||||

我们非常欢迎开发者们为 KnowStreaming 开源项目贡献一份力量,相应也将给予贡献者激励以表认可与感谢。

|

||||

|

||||

#### 参与贡献

|

||||

|

||||

1. 积极参与 Issue 的讨论,如答疑解惑、提供想法或报告无法解决的错误(Issue)

|

||||

2. 撰写和改进项目的文档(Wiki)

|

||||

3. 提交补丁优化代码(Coding)

|

||||

|

||||

#### 你将获得

|

||||

|

||||

1. 加入 KnowStreaming 开源项目贡献者名单并展示

|

||||

2. KnowStreaming 开源贡献者证书(纸质&电子版)

|

||||

3. KnowStreaming 贡献者精美大礼包(KnowStreamin/滴滴 周边)

|

||||

|

||||

#### 相关规则

|

||||

|

||||

- Contributer 和 Commiter 都会有对应的证书和对应的礼包

|

||||

- 每季度有 KnowStreaming 项目团队评选出杰出贡献者,颁发相应证书。

|

||||

- 年末进行年度评选

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

<hr>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

## 10.6 贡献者名单

|

||||

|

||||

#### KnowStreaming 开发者角色

|

||||

|

||||

KnowStreaming 开发者包含 Maintainer、Committer、Contributor 三种角色,每种角色的标准定义如下。

|

||||

|

||||

##### Maintainer

|

||||

|

||||

Maintainer 是对 KnowStreaming 项目的演进和发展做出显著贡献的个人。具体包含以下的标准:

|

||||

|

||||

- 完成多个关键模块或者工程的设计与开发,是项目的核心开发人员;

|

||||

- 持续的投入和激情,能够积极参与社区、官网、issue、PR 等项目相关事项的维护;

|

||||

- 在社区中具有有目共睹的影响力,能够代表 KnowStreaming 参加重要的社区会议和活动;

|

||||

- 具有培养 Committer 和 Contributor 的意识和能力;

|

||||

|

||||

##### Committer

|

||||

|

||||

Committer 是具有 KnowStreaming 仓库写权限的个人,包含以下的标准:

|

||||

|

||||

- 能够在长时间内做持续贡献 issue、PR 的个人;

|

||||

- 参与 issue 列表的维护及重要 feature 的讨论;

|

||||

- 参与 code review;

|

||||

|

||||

##### Contributor

|

||||

|

||||

Contributor 是对 KnowStreaming 项目有贡献的个人,标准为:

|

||||

|

||||

- 提交过 PR 并被合并;

|

||||

|

||||

开源贡献者名单(定期更新)

|

||||

|

||||

在名单内,但是没有收到贡献者礼品的同学,可以联系:szzdzhp001

|

||||

|

||||

| 姓名 | Github | 角色 | 公司 |

|

||||

| ------------------- | ---------------------------------------------------------- | ----------- | -------- |

|

||||

| 张亮 | [@zhangliangboy](https://github.com/zhangliangboy) | Maintainer | 滴滴出行 |

|

||||

| 谢鹏 | [@PenceXie](https://github.com/PenceXie) | Maintainer | 滴滴出行 |

|

||||

| 赵情融 | [@zqrferrari](https://github.com/zqrferrari) | Maintainer | 滴滴出行 |

|

||||

| 石臻臻 | [@shirenchuang](https://github.com/shirenchuang) | Maintainer | 滴滴出行 |

|

||||

| 曾巧 | [@ZQKC](https://github.com/ZQKC) | Maintainer | 滴滴出行 |

|

||||

| 孙超 | [@lucasun](https://github.com/lucasun) | Maintainer | 滴滴出行 |

|

||||

| 洪华驰 | [@brodiehong](https://github.com/brodiehong) | Maintainer | 滴滴出行 |

|

||||

| 许喆 | [@potaaaaaato](https://github.com/potaaaaaato) | Committer | 滴滴出行 |

|

||||

| 郭宇航 | [@GraceWalk](https://github.com/GraceWalk) | Committer | 滴滴出行 |

|

||||

| 李伟 | [@velee](https://github.com/velee) | Committer | 滴滴出行 |

|

||||

| 张占昌 | [@zzccctv](https://github.com/zzccctv) | Committer | 滴滴出行 |

|

||||

| 王东方 | [@wangdongfang-aden](https://github.com/wangdongfang-aden) | Committer | 滴滴出行 |

|

||||

| 王耀波 | [@WYAOBO](https://github.com/WYAOBO) | Committer | 滴滴出行 |

|

||||

| 赵寅锐 | [@ZHAOYINRUI](https://github.com/ZHAOYINRUI) | Maintainer | 字节跳动 |

|

||||

| haoqi123 | [@haoqi123](https://github.com/haoqi123) | Contributor | 前程无忧 |

|

||||

| chaixiaoxue | [@chaixiaoxue](https://github.com/chaixiaoxue) | Contributor | SYNNEX |

|

||||

| 陆晗 | [@luhea](https://github.com/luhea) | Contributor | 竞技世界 |

|

||||

| Mengqi777 | [@Mengqi777](https://github.com/Mengqi777) | Contributor | 腾讯 |

|

||||

| ruanliang-hualun | [@ruanliang-hualun](https://github.com/ruanliang-hualun) | Contributor | 网易 |

|

||||

| 17hao | [@17hao](https://github.com/17hao) | Contributor | |

|

||||

| Huyueeer | [@Huyueeer](https://github.com/Huyueeer) | Contributor | INVENTEC |

|

||||

| lomodays207 | [@lomodays207](https://github.com/lomodays207) | Contributor | 建信金科 |

|

||||

| Super .Wein(星痕) | [@superspeedone](https://github.com/superspeedone) | Contributor | 韵达 |

|

||||

| Hongten | [@Hongten](https://github.com/Hongten) | Contributor | Shopee |

|

||||

| 徐正熙 | [@hyper-xx)](https://github.com/hyper-xx) | Contributor | 滴滴出行 |

|

||||

| RichardZhengkay | [@RichardZhengkay](https://github.com/RichardZhengkay) | Contributor | 趣街 |

|

||||

| 罐子里的茶 | [@gzldc](https://github.com/gzldc) | Contributor | 道富 |

|

||||

| 陈忠玉 | [@paula](https://github.com/chenzhongyu11) | Contributor | 平安产险 |

|

||||

| 杨光 | [@yaangvipguang](https://github.com/yangvipguang) | Contributor |

|

||||

| 王亚聪 | [@wangyacongi](https://github.com/wangyacongi) | Contributor |

|

||||

| Yang Jing | [@yangbajing](https://github.com/yangbajing) | Contributor | |

|

||||

| 刘新元 Liu XinYuan | [@Liu-XinYuan](https://github.com/Liu-XinYuan) | Contributor | |

|

||||

| Joker | [@LiubeyJokerQueue](https://github.com/JokerQueue) | Contributor | 丰巢 |

|

||||

| Eason Lau | [@Liubey](https://github.com/Liubey) | Contributor | |

|

||||

| hailanxin | [@hailanxin](https://github.com/hailanxin) | Contributor | |

|

||||

| Qi Zhang | [@zzzhangqi](https://github.com/zzzhangqi) | Contributor | 好雨科技 |

|

||||

| fengxsong | [@fengxsong](https://github.com/fengxsong) | Contributor | |

|

||||

| 谢晓东 | [@Strangevy](https://github.com/Strangevy) | Contributor | 花生日记 |

|

||||

| ZhaoXinlong | [@ZhaoXinlong](https://github.com/ZhaoXinlong) | Contributor | |

|

||||

| xuehaipeng | [@xuehaipeng](https://github.com/xuehaipeng) | Contributor | |

|

||||

| 孔令续 | [@mrazkong](https://github.com/mrazkong) | Contributor | |

|

||||

| pierre xiong | [@pierre94](https://github.com/pierre94) | Contributor | |

|

||||

| PengShuaixin | [@PengShuaixin](https://github.com/PengShuaixin) | Contributor | |

|

||||

| 梁壮 | [@lz](https://github.com/silent-night-no-trace) | Contributor | |

|

||||

| 张晓寅 | [@ahu0605](https://github.com/ahu0605) | Contributor | 电信数智 |

|

||||

| 黄海婷 | [@Huanghaiting](https://github.com/Huanghaiting) | Contributor | 云徙科技 |

|

||||

| 任祥德 | [@RenChauncy](https://github.com/RenChauncy) | Contributor | 探马企服 |

|

||||

625

product/2-quick-start.md

Normal file

625

product/2-quick-start.md

Normal file

@@ -0,0 +1,625 @@

|

||||

---

|

||||

order: 2

|

||||

title: '2.快速开始'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

## 2.1、单机部署

|

||||

|

||||

**风险提示**

|

||||

|

||||

⚠️ 脚本全自动安装,会将所部署机器上的 MySQL、JDK、ES 等进行删除重装,请注意原有服务丢失风险。

|

||||

|

||||

### 2.1.1、产品下载

|

||||

|

||||

| KnowStreaming Version | Offline installer | Helm Chart | Docker Image |

|

||||

| :-------------------: | :------------------------------------------------------------------------------------------------------------------------------------: | :---------------------------------------------------------------------------------------------------------: | :---------------------------------------------: |

|

||||

| 3.0.0-beta.1 | [KnowStreaming-3.0.0-beta.1-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-beta.1-offline.tar.gz) | [knowstreaming-manager-0.1.3.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.3.tgz) | [0.1.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.0.0-beta.2 | [KnowStreaming-3.0.0-beta.2-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-beta.2-offline.tar.gz) | [knowstreaming-manager-0.1.4.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.4.tgz) | [0.2.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.0.0-beta.3 | [KnowStreaming-3.0.0-beta.3-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-beta.3-offline.tar.gz) | [knowstreaming-manager-0.1.5.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.5.tgz) | [0.3.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.0.0 | [KnowStreaming-3.0.0-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-offline.tar.gz) | [knowstreaming-manager-0.1.6.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.6.tgz) | [0.4.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.0.1 | [KnowStreaming-3.0.1-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.1-offline.tar.gz) | [knowstreaming-manager-0.1.7.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.7.tgz) | [0.5.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.1.0 | [KnowStreaming-3.1.0-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.1.0-offline.tar.gz) | [knowstreaming-manager-0.1.8.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.8.tgz) | [0.6.0](https://hub.docker.com/u/knowstreaming) |

|

||||

| 3.2.0 | [KnowStreaming-3.2.0-offline.tar.gz](http://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.1.0-offline.tar.gz) | [knowstreaming-manager-0.1.9.tgz](http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.8.tgz) | [0.7.0](https://hub.docker.com/u/knowstreaming) |

|

||||

|

||||

### 2.1.2、安装说明

|

||||

|

||||

- 以 `v3.0.0-beta.1` 版本为例进行部署;

|

||||

- 以 CentOS-7 为例,系统基础配置要求 4C-8G;

|

||||

- 部署完成后,可通过浏览器:`IP:PORT` 进行访问,默认端口是 `8080`,系统默认账号密码: `admin` / `admin2022_`;(注意!`v3.0.0-beta.2` 及以后版本默认账号和密码为:`admin` / `admin`)

|

||||

- 本文为单机部署,如需分布式部署,[请联系我们](https://knowstreaming.com/support-center)

|

||||

|

||||

**软件依赖**

|

||||

|

||||

| 软件名 | 版本要求 | 默认端口 |

|

||||

| ------------- | ------------ | -------- |

|

||||

| MySQL | v5.7 或 v8.0 | 3306 |

|

||||

| ElasticSearch | v7.6+ | 8060 |

|

||||

| JDK | v8+ | - |

|

||||

| CentOS | v6+ | - |

|

||||

| Ubuntu | v16+ | - |

|

||||

|

||||

|

||||

|

||||

### 2.1.3、脚本部署

|

||||

|

||||

**在线安装**

|

||||

|

||||

```bash

|

||||

# 在服务器中下载安装脚本, 该脚本中会在当前目录下,重新安装MySQL。重装后的mysql密码存放在当前目录的mysql.password文件中。

|

||||

wget https://s3-gzpu.didistatic.com/pub/knowstreaming/deploy_KnowStreaming.sh

|

||||

|

||||

# 执行脚本(会提示选择安装的版本)

|

||||

sh deploy_KnowStreaming.sh

|

||||

|

||||

# 访问地址(根据实际IP地址更换)

|

||||

127.0.0.1:8080

|

||||

```

|

||||

|

||||

**离线安装**

|

||||

|

||||

```bash

|

||||

# 将安装包下载到本地且传输到目标服务器

|

||||

wget https://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-beta.3-offline.tar.gz

|

||||

|

||||

# 解压安装包

|

||||

tar -zxf KnowStreaming-3.0.0-beta.1-offline.tar.gz

|

||||

|

||||

# 执行安装脚本

|

||||

sh deploy_KnowStreaming-offline.sh

|

||||

|

||||

# 访问地址(根据实际IP地址更换)

|

||||

127.0.0.1:8080

|

||||

```

|

||||

|

||||

|

||||

|

||||

### 2.1.4、容器化部署

|

||||

|

||||

#### 2.1.4.1、Helm

|

||||

|

||||

**环境依赖**

|

||||

|

||||

- Kubernetes >= 1.14 ,Helm >= 2.17.0

|

||||

- 系统基础配置要求 14C-26G,可根据需要调整应用副本数。

|

||||

- 默认依赖全部安装,ElasticSearch(3 节点集群模式) + MySQL(单机) + KnowStreaming-manager(2 副本) + KnowStreaming-ui(2 副本)

|

||||

- 请配置持久化存储卷

|

||||

- 使用已有的 ElasticSearch(7.6.x) 和 MySQL(5.7) 只需调整 values.yaml 部分参数即可

|

||||

|

||||

**安装命令**

|

||||

|

||||

```bash

|

||||

# 相关镜像在Docker Hub都可以下载

|

||||

# 快速安装(NAMESPACE需要更改为已存在的,安装启动需要几分钟初始化请稍等~)

|

||||

helm install -n [NAMESPACE] [NAME] http://download.knowstreaming.com/charts/knowstreaming-manager-0.1.9.tgz

|

||||

|

||||

# 获取KnowStreaming前端ui的service. 默认nodeport方式.

|

||||

# (http://nodeIP:nodeport,默认用户名密码:admin/admin2022_)

|

||||

# `v3.0.0-beta.2`版本开始(helm chart包版本0.1.4开始),默认账号密码为`admin` / `admin`;

|

||||

|

||||

# 添加仓库

|

||||

helm repo add knowstreaming http://download.knowstreaming.com/charts

|

||||

|

||||

# 拉取最新版本

|

||||

helm pull knowstreaming/knowstreaming-manager

|

||||

```

|

||||

|

||||

|

||||

|

||||

#### 2.1.4.2、Docker Compose

|

||||

|

||||

**环境依赖**

|

||||

|

||||

- [Docker](https://docs.docker.com/engine/install/)

|

||||

- [Docker Compose](https://docs.docker.com/compose/install/)

|

||||

|

||||

**安装命令**

|

||||

|

||||

```bash

|

||||

# `v3.0.0-beta.2`版本开始(docker镜像为0.2.0版本开始),默认账号密码为`admin` / `admin`;

|

||||

# https://hub.docker.com/u/knowstreaming 在此处寻找最新镜像版本

|

||||

# mysql与es可以使用自己搭建的服务,调整对应配置即可

|

||||

|

||||

# 复制docker-compose.yml到指定位置后执行下方命令即可启动

|

||||

docker-compose up -d

|

||||

```

|

||||

|

||||

**验证安装**

|

||||

|

||||

```shell

|

||||

docker-compose ps

|

||||

# 验证启动 - 状态为 UP 则表示成功

|

||||

Name Command State Ports

|

||||

----------------------------------------------------------------------------------------------------

|

||||

elasticsearch-single /usr/local/bin/docker-entr ... Up 9200/tcp, 9300/tcp

|

||||

knowstreaming-init /bin/bash /es_template_cre ... Up

|

||||

knowstreaming-manager /bin/sh /ks-start.sh Up 80/tcp

|

||||

knowstreaming-mysql /entrypoint.sh mysqld Up (health: starting) 3306/tcp, 33060/tcp

|

||||

knowstreaming-ui /docker-entrypoint.sh ngin ... Up 0.0.0.0:80->80/tcp

|

||||

|

||||

# 稍等一分钟左右 knowstreaming-init 会退出,表示es初始化完成,可以访问页面

|

||||

Name Command State Ports

|

||||

-------------------------------------------------------------------------------------------

|

||||

knowstreaming-init /bin/bash /es_template_cre ... Exit 0

|

||||

knowstreaming-mysql /entrypoint.sh mysqld Up (healthy) 3306/tcp, 33060/tcp

|

||||

```

|

||||

|

||||

**访问**

|

||||

|

||||

```http request

|

||||

http://127.0.0.1:80/

|

||||

```

|

||||

|

||||

**docker-compose.yml**

|

||||

|

||||

```yml

|

||||

version: '2'

|

||||

services:

|

||||

# *不要调整knowstreaming-manager服务名称,ui中会用到

|

||||

knowstreaming-manager:

|

||||

image: knowstreaming/knowstreaming-manager:0.7.0

|

||||

container_name: knowstreaming-manager

|

||||

privileged: true

|

||||

restart: always

|

||||

depends_on:

|

||||

- elasticsearch-single

|

||||

- knowstreaming-mysql

|

||||

expose:

|

||||

- 80

|

||||

command:

|

||||

- /bin/sh

|

||||

- /ks-start.sh

|

||||

environment:

|

||||

TZ: Asia/Shanghai

|

||||

# mysql服务地址

|

||||

SERVER_MYSQL_ADDRESS: knowstreaming-mysql:3306

|

||||

# mysql数据库名

|

||||

SERVER_MYSQL_DB: know_streaming

|

||||

# mysql用户名

|

||||

SERVER_MYSQL_USER: root

|

||||

# mysql用户密码

|

||||

SERVER_MYSQL_PASSWORD: admin2022_

|

||||

# es服务地址

|

||||

SERVER_ES_ADDRESS: elasticsearch-single:9200

|

||||

# 服务JVM参数

|

||||

JAVA_OPTS: -Xmx1g -Xms1g

|

||||

# 对于kafka中ADVERTISED_LISTENERS填写的hostname可以通过该方式完成

|

||||

# extra_hosts:

|

||||

# - "hostname:x.x.x.x"

|

||||

# 服务日志路径

|

||||

# volumes:

|

||||

# - /ks/manage/log:/logs

|

||||

knowstreaming-ui:

|

||||

image: knowstreaming/knowstreaming-ui:0.7.0

|

||||

container_name: knowstreaming-ui

|

||||

restart: always

|

||||

ports:

|

||||

- '80:80'

|

||||

environment:

|

||||

TZ: Asia/Shanghai

|

||||

depends_on:

|

||||

- knowstreaming-manager

|

||||

# extra_hosts:

|

||||

# - "hostname:x.x.x.x"

|

||||

elasticsearch-single:

|

||||

image: docker.io/library/elasticsearch:7.6.2

|

||||

container_name: elasticsearch-single

|

||||

restart: always

|

||||

expose:

|

||||

- 9200

|

||||

- 9300

|

||||

# ports:

|

||||

# - '9200:9200'

|

||||

# - '9300:9300'

|

||||

environment:

|

||||

TZ: Asia/Shanghai

|

||||

# es的JVM参数

|

||||

ES_JAVA_OPTS: -Xms512m -Xmx512m

|

||||

# 单节点配置,多节点集群参考 https://www.elastic.co/guide/en/elasticsearch/reference/7.6/docker.html#docker-compose-file

|

||||

discovery.type: single-node

|

||||

# 数据持久化路径

|

||||

# volumes:

|

||||

# - /ks/es/data:/usr/share/elasticsearch/data

|

||||

|

||||

# es初始化服务,与manager使用同一镜像

|

||||

# 首次启动es需初始化模版和索引,后续会自动创建

|

||||

knowstreaming-init:

|

||||

image: knowstreaming/knowstreaming-manager:0.7.0

|

||||

container_name: knowstreaming-init

|

||||

depends_on:

|

||||

- elasticsearch-single

|

||||

command:

|

||||

- /bin/bash

|

||||

- /es_template_create.sh

|

||||

environment:

|

||||

TZ: Asia/Shanghai

|

||||

# es服务地址

|

||||

SERVER_ES_ADDRESS: elasticsearch-single:9200

|

||||

|

||||

knowstreaming-mysql:

|

||||

image: knowstreaming/knowstreaming-mysql:0.7.0

|

||||

container_name: knowstreaming-mysql

|

||||

restart: always

|

||||

environment:

|

||||

TZ: Asia/Shanghai

|

||||

# root 用户密码

|

||||

MYSQL_ROOT_PASSWORD: admin2022_

|

||||

# 初始化时创建的数据库名称

|

||||

MYSQL_DATABASE: know_streaming

|

||||

# 通配所有host,可以访问远程

|

||||

MYSQL_ROOT_HOST: '%'

|

||||

expose:

|

||||

- 3306

|

||||

# ports:

|

||||

# - '3306:3306'

|

||||

# 数据持久化路径

|

||||

# volumes:

|

||||

# - /ks/mysql/data:/data/mysql

|

||||

```

|

||||

|

||||

|

||||

|

||||

### 2.1.5、手动部署

|

||||

|

||||

**部署流程**

|

||||

|

||||

1. 安装 `JDK-11`、`MySQL`、`ElasticSearch` 等依赖服务

|

||||

2. 安装 KnowStreaming

|

||||

|

||||

|

||||

|

||||

#### 2.1.5.1、安装 MySQL 服务

|

||||

|

||||

**yum 方式安装**

|

||||

|

||||

```bash

|

||||

# 配置yum源

|

||||

wget https://dev.mysql.com/get/mysql57-community-release-el7-9.noarch.rpm

|

||||

rpm -ivh mysql57-community-release-el7-9.noarch.rpm

|

||||

|

||||

# 执行安装

|

||||

yum -y install mysql-server mysql-client

|

||||

|

||||

# 服务启动

|

||||

systemctl start mysqld

|

||||

|

||||

# 获取初始密码并修改

|

||||

old_pass=`grep 'temporary password' /var/log/mysqld.log | awk '{print $NF}' | tail -n 1`

|

||||

|

||||

mysql -NBe "alter user USER() identified by 'Didi_km_678';" --connect-expired-password -uroot -p$old_pass

|

||||

```

|

||||

|

||||

**rpm 方式安装**

|

||||

|

||||

```bash

|

||||

# 下载安装包

|

||||

wget https://s3-gzpu.didistatic.com/knowsearch/mysql5.7.tar.gz

|

||||

|

||||

# 解压到指定目录

|

||||

tar -zxf mysql5.7.tar.gz -C /tmp/

|

||||

|

||||

# 执行安装

|

||||

yum -y localinstall /tmp/libaio-*.rpm /tmp/mysql-*.rpm

|

||||

|

||||

# 服务启动

|

||||

systemctl start mysqld

|

||||

|

||||

|

||||

# 获取初始密码并修改

|

||||

old_pass=`grep 'temporary password' /var/log/mysqld.log | awk '{print $NF}' | tail -n 1`

|

||||

|

||||

mysql -NBe "alter user USER() identified by 'Didi_km_678';" --connect-expired-password -uroot -p$old_pass

|

||||

|

||||

```

|

||||

|

||||

|

||||

|

||||

#### 2.1.5.2、配置 JDK 环境

|

||||

|

||||

```bash

|

||||

# 下载安装包

|

||||

wget https://s3-gzpu.didistatic.com/pub/jdk11.tar.gz

|

||||

|

||||

# 解压到指定目录

|

||||

tar -zxf jdk11.tar.gz -C /usr/local/

|

||||

|

||||

# 更改目录名

|

||||

mv /usr/local/jdk-11.0.2 /usr/local/java11

|

||||

|

||||

# 添加到环境变量

|

||||

echo "export JAVA_HOME=/usr/local/java11" >> ~/.bashrc

|

||||

echo "export CLASSPATH=/usr/java/java11/lib" >> ~/.bashrc

|

||||

echo "export PATH=$JAVA_HOME/bin:$PATH:$HOME/bin" >> ~/.bashrc

|

||||

|

||||

source ~/.bashrc

|

||||

|

||||

```

|

||||

|

||||

|

||||

|

||||

#### 2.1.5.3、ElasticSearch 实例搭建

|

||||

|

||||

- ElasticSearch 用于存储平台采集的 Kafka 指标;

|

||||

- 以下安装示例为单节点模式,如需集群部署可以参考:[Elasticsearch 官方文档](https://www.elastic.co/guide/en/elasticsearch/reference/7.6/elasticsearch-intro.html)

|

||||

|

||||

```bash

|

||||

# 下载安装包

|

||||

wget https://s3-gzpu.didistatic.com/pub/elasticsearch.tar.gz

|

||||

|

||||

# 创建ES数据存储目录

|

||||

mkdir -p /data/es_data

|

||||

|

||||

# 创建ES所属用户

|

||||

useradd arius

|

||||

|

||||

# 配置用户的打开文件数

|

||||

echo "arius soft nofile 655350" >> /etc/security/limits.conf

|

||||

echo "arius hard nofile 655350" >> /etc/security/limits.conf

|

||||

echo "vm.max_map_count = 655360" >> /etc/sysctl.conf

|

||||

sysctl -p

|

||||

|

||||

# 解压安装包

|

||||

tar -zxf elasticsearch.tar.gz -C /data/

|

||||

|

||||

# 更改目录所属组

|

||||

chown -R arius:arius /data/

|

||||

|

||||

# 修改配置文件(参考以下配置)

|

||||

vim /data/elasticsearch/config/elasticsearch.yml

|

||||

cluster.name: km_es

|

||||

node.name: es-node1

|

||||

node.master: true

|

||||

node.data: true

|

||||

path.data: /data/es_data

|

||||

http.port: 8060

|

||||

discovery.seed_hosts: ["127.0.0.1:9300"]

|

||||

|

||||

# 修改内存配置

|

||||

vim /data/elasticsearch/config/jvm.options

|

||||

-Xms2g

|

||||

-Xmx2g

|

||||

|

||||

# 启动服务

|

||||

su - arius

|

||||

export JAVA_HOME=/usr/local/java11

|

||||

sh /data/elasticsearch/control.sh start

|

||||

|

||||

# 确认状态

|

||||

sh /data/elasticsearch/control.sh status

|

||||

```

|

||||

|

||||

|

||||

|

||||

#### 2.1.5.4、KnowStreaming 实例搭建

|

||||

|

||||

```bash

|

||||

# 下载安装包

|

||||

wget https://s3-gzpu.didistatic.com/pub/knowstreaming/KnowStreaming-3.0.0-beta.1.tar.gz

|

||||

|

||||

# 解压安装包到指定目录

|

||||

tar -zxf KnowStreaming-3.0.0-beta.1.tar.gz -C /data/

|

||||

|

||||

# 修改启动脚本并加入systemd管理

|

||||

cd /data/KnowStreaming/

|

||||

|

||||

# 创建相应的库和导入初始化数据

|

||||

mysql -uroot -pDidi_km_678 -e "create database know_streaming;"

|

||||

mysql -uroot -pDidi_km_678 know_streaming < ./init/sql/ddl-ks-km.sql

|

||||

mysql -uroot -pDidi_km_678 know_streaming < ./init/sql/ddl-logi-job.sql

|

||||

mysql -uroot -pDidi_km_678 know_streaming < ./init/sql/ddl-logi-security.sql

|

||||

mysql -uroot -pDidi_km_678 know_streaming < ./init/sql/dml-ks-km.sql

|

||||

mysql -uroot -pDidi_km_678 know_streaming < ./init/sql/dml-logi.sql

|

||||

|

||||

# 创建elasticsearch初始化数据

|

||||

sh ./bin/init_es_template.sh

|

||||

|

||||

# 修改配置文件

|

||||

vim ./conf/application.yml

|

||||

|

||||

# 监听端口

|

||||

server:

|

||||

port: 8080 # web 服务端口

|

||||

tomcat:

|

||||

accept-count: 1000

|

||||

max-connections: 10000

|

||||

|

||||

# ES地址

|

||||

es.client.address: 127.0.0.1:8060

|

||||

|

||||

# 数据库配置(一共三处地方,修改正确的mysql地址和数据库名称以及用户名密码)

|

||||

jdbc-url: jdbc:mariadb://127.0.0.1:3306/know_streaming?.....

|

||||

username: root

|

||||

password: Didi_km_678

|

||||

|

||||

# 启动服务

|

||||

cd /data/KnowStreaming/bin/

|

||||

sh startup.sh

|

||||

```

|

||||

|

||||

### 2.1.6、Rainbond 部署

|

||||

|

||||

#### 2.1.6.1、根据快速安装文档部署 [Rainbond](/docs/quick-start/quick-install/)

|

||||

|

||||

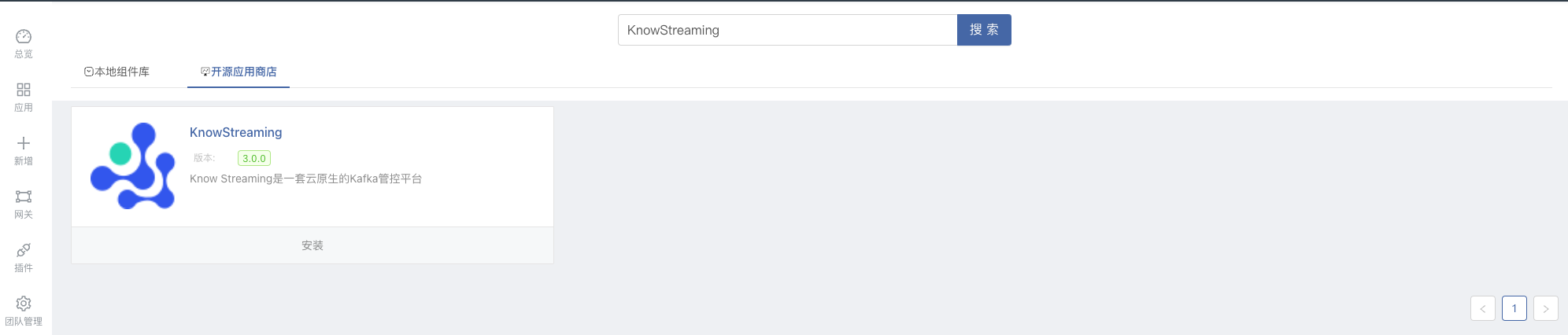

KnowStreaming 已发布至 `开源应用商店` ,用户可搜索 `KnowStreaming`,一键安装 KnowStreaming

|

||||

|

||||

|

||||

|

||||

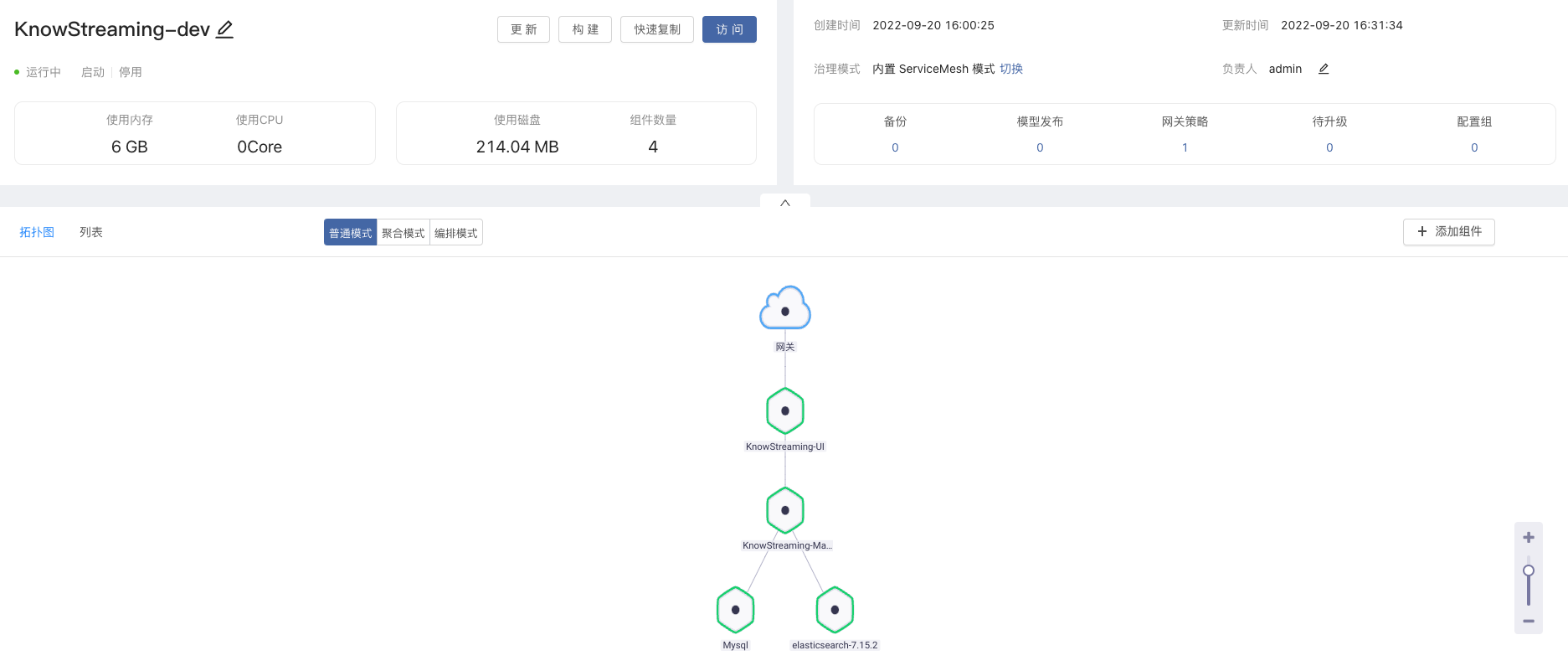

安装后,访问 `KnowStreaming-UI` 进入控制台,默认密码:admin / admin

|

||||

|

||||

|

||||

|

||||

#### 2.1.6.2、快速部署 Kafka 集群

|

||||

|

||||

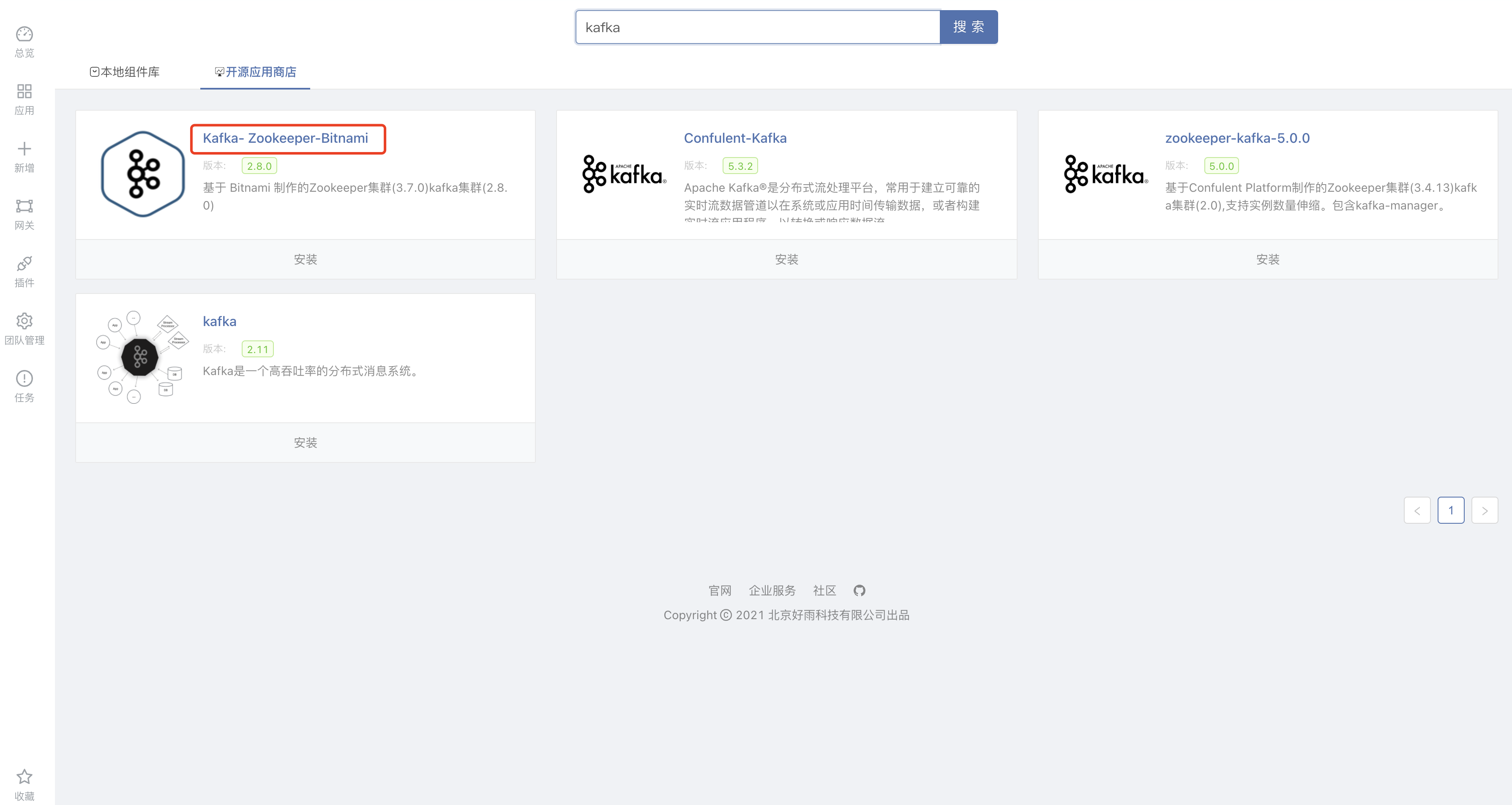

上面我们已经部署了 `KnowStreaming`,接下来我们也可通过 `开源应用商店` 安装 Kafka 集群并进行对接。

|

||||

|

||||

Kafka 已发布至 `开源应用商店` ,用户可搜索 `kafka`,一键安装 Kafka-Zookeeper-Bitnami

|

||||

|

||||

|

||||

|

||||

安装完成后,我们进入 `kafka1` 和 `kafka2` 的组件 -> 环境变量

|

||||

|

||||

修改 `KAFKA_CFG_ADVERTISED_LISTENERS` 环境变量为组件`9092`端口的对外 IP + 端口,例如:`PLAINTEXT://192.168.3.162:10000`

|

||||

|

||||

修改 `JMX_PORT` 环境变量为 TCP 对外端口地址供 `Logikm` 获取指标。例如:`JMX_PORT`为 9999,组件对应的端口也要为 9999,同时 tcp 对外端口也是 9999

|

||||

|

||||

#### 2.1.6.3、使用 KnowStreaming 对接并管理 Kafka 集群

|

||||

|

||||

接下来我们通过 `KnowStreaming` 对接刚刚安装的 `kafka`集群。

|

||||

|

||||

访问 `KnowStreaming`,接入集群,根据页面提示填写对应信息。

|

||||

|

||||

对接完成后,我们就可通过 `KnowStreaming` 管理 `kafka` 集群啦。

|

||||

|

||||

---

|

||||

|

||||

## 2.2、登录系统

|

||||

|

||||

部署完成后,打开浏览器输入 IP 地址 + 端口(默认端口 8080) 即可访问 `Know Streaming`。

|

||||

|

||||

默认账号和密码为:`admin` / `admin`。(注意!v3.0 beta1 版本默认账号和密码为:`admin` / `admin2022_`)

|

||||

|

||||

---

|

||||

|

||||

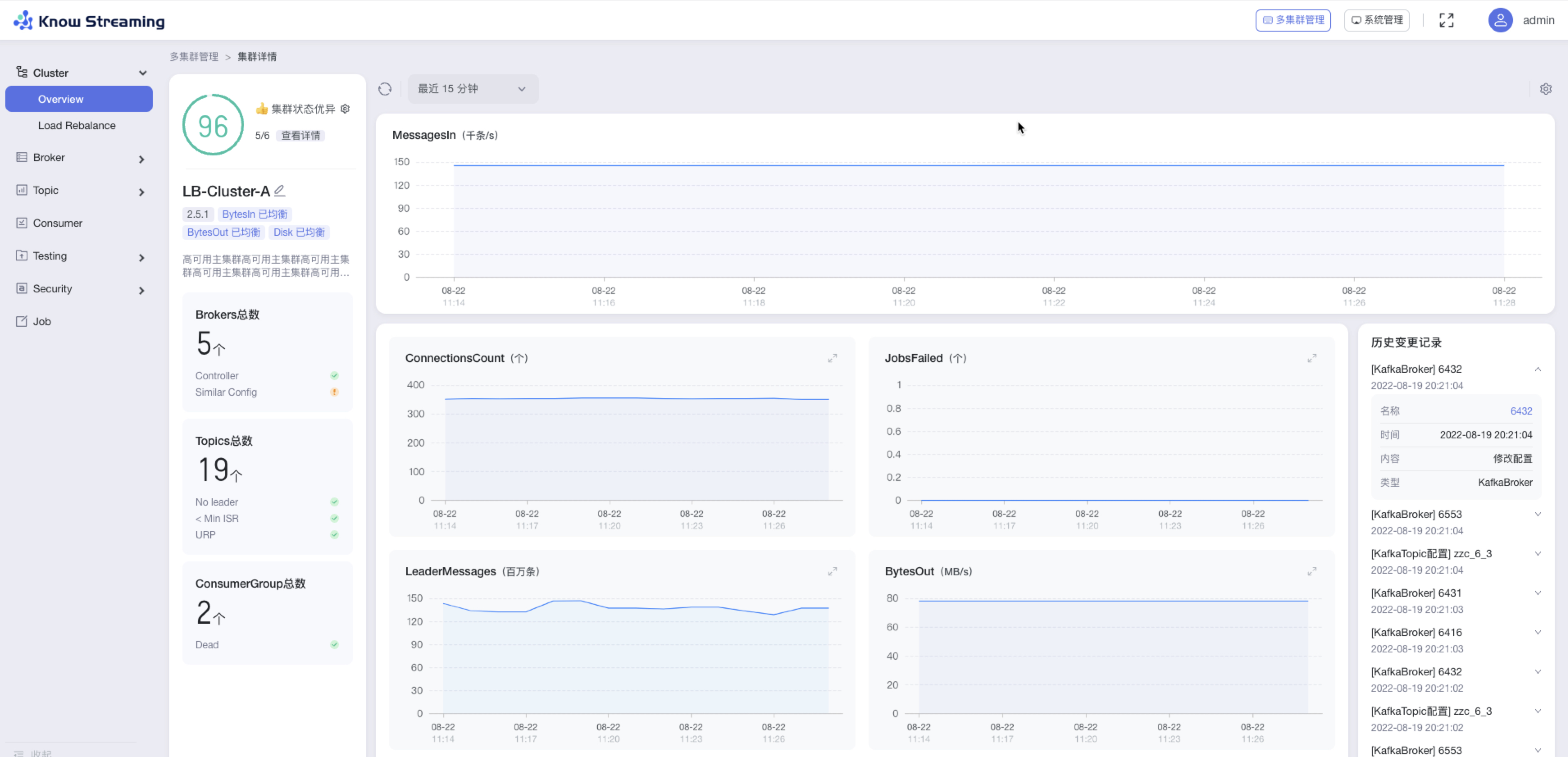

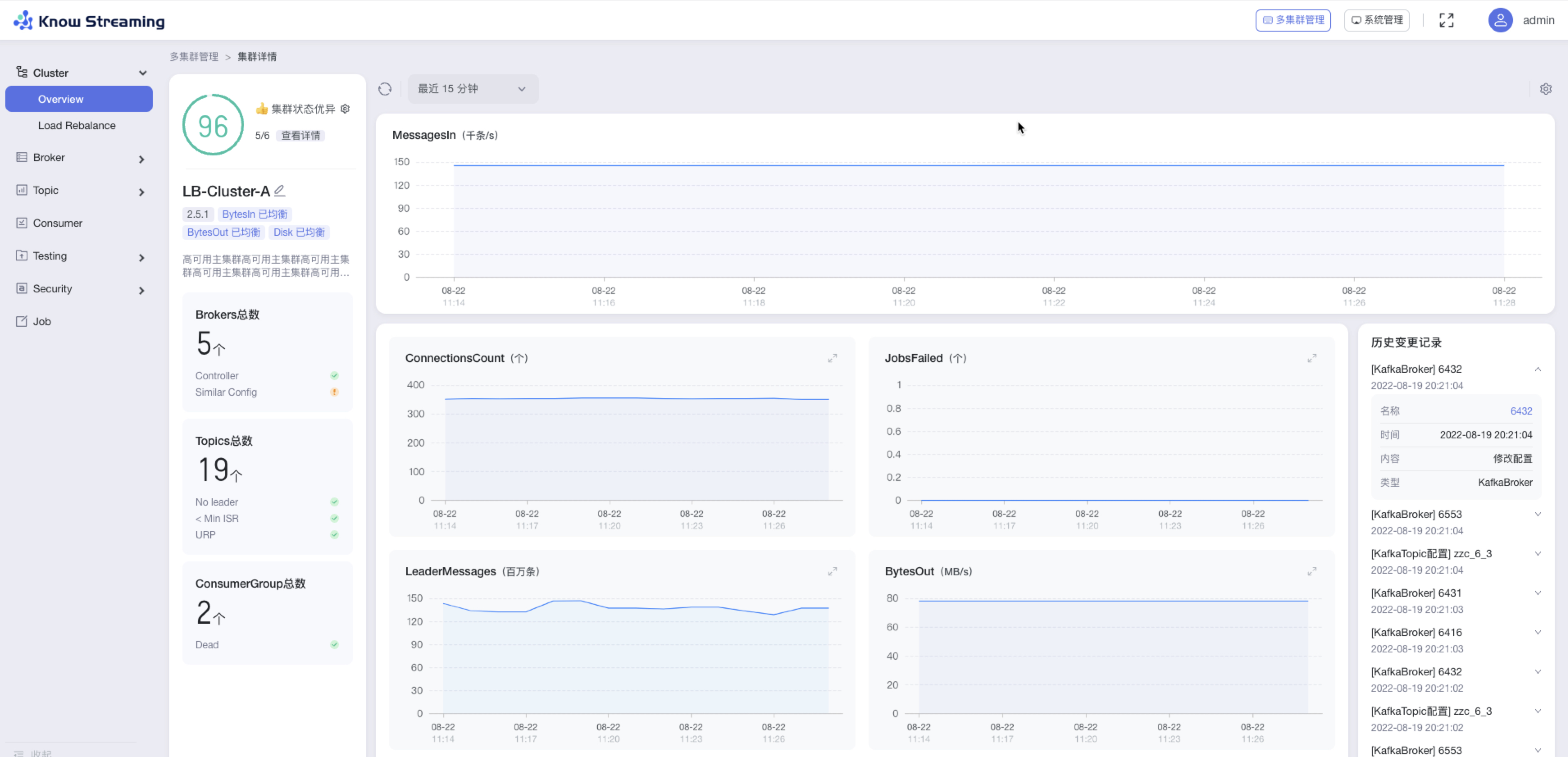

## 2.3、开始使用

|

||||

|

||||

登录完成后,可根据以下场景快速体验基本功能。

|

||||

|

||||

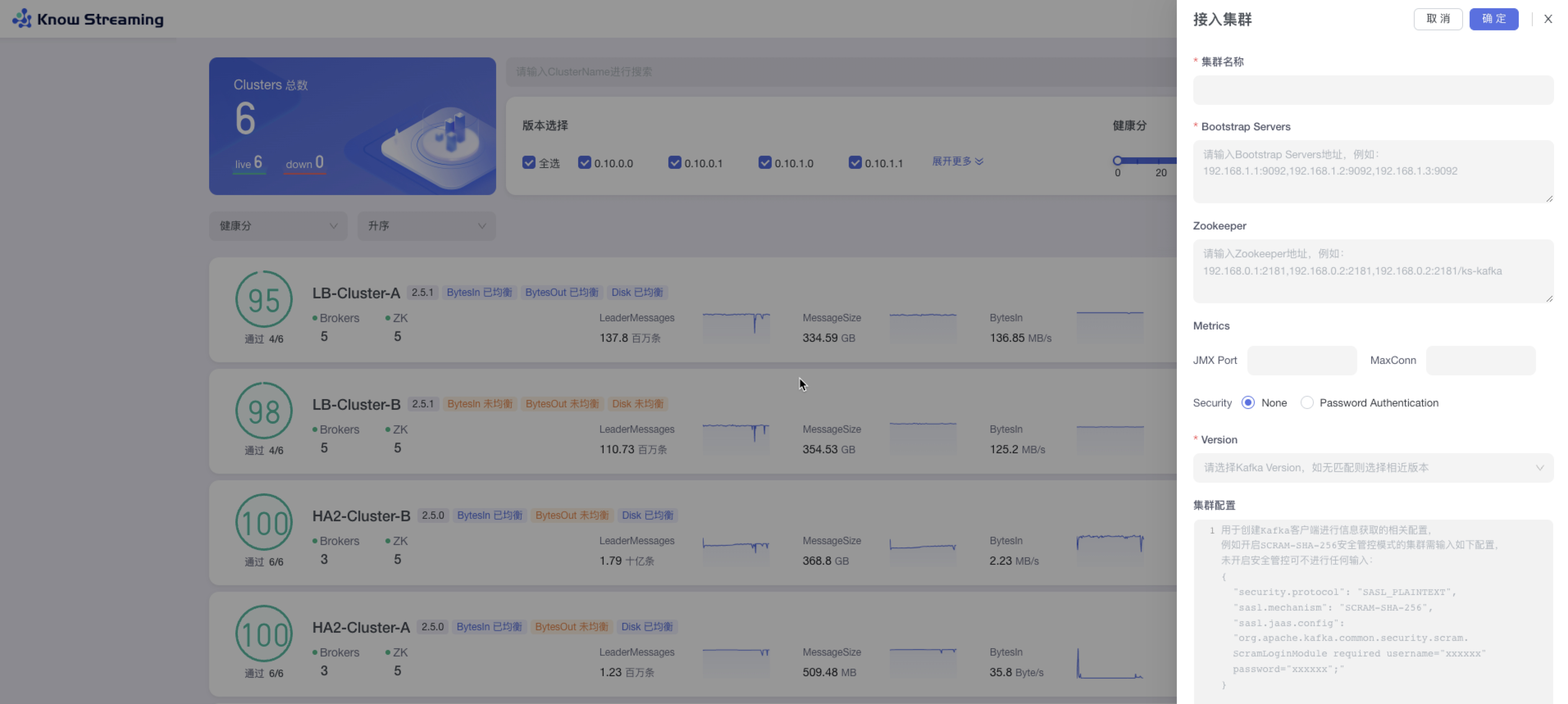

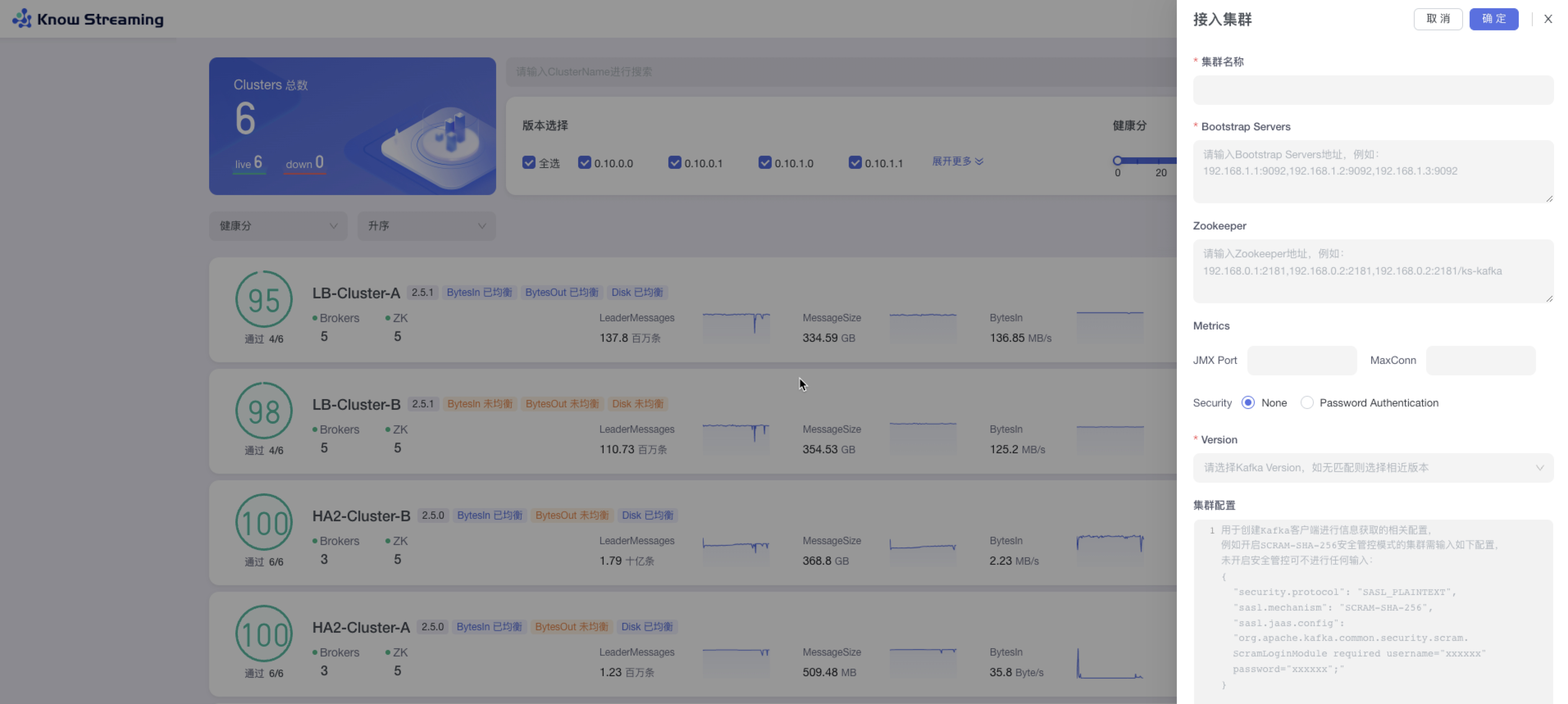

### 2.3.1、接入集群

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“接入集群”

|

||||

|

||||

- 步骤 2:填写相关集群信息

|

||||

|

||||

- 集群名称:平台内不能重复

|

||||

- Bootstrap Servers:输入完成之后会进行连接测试,测试完成之后会给出测试结果连接成功 or 连接失败(以及失败的原因)。

|

||||

- Zookeeper:输入完成之后会进行连接测试,测试完成之后会给出测试结果连接成功 or 连接失败(以及失败的原因)

|

||||

- Metrics 选填:JMX Port,输入 JMX 端口号;MaxConn,输入服务端最大允许的连接数

|

||||

- Security:JMX 账号密码

|

||||

- Version:kafka 版本,如果没有匹配则可以选择相近版本

|

||||

- 集群配置选填:创建 kafka 客户端进行信息获取的相关配置

|

||||

|

||||

|

||||

|

||||

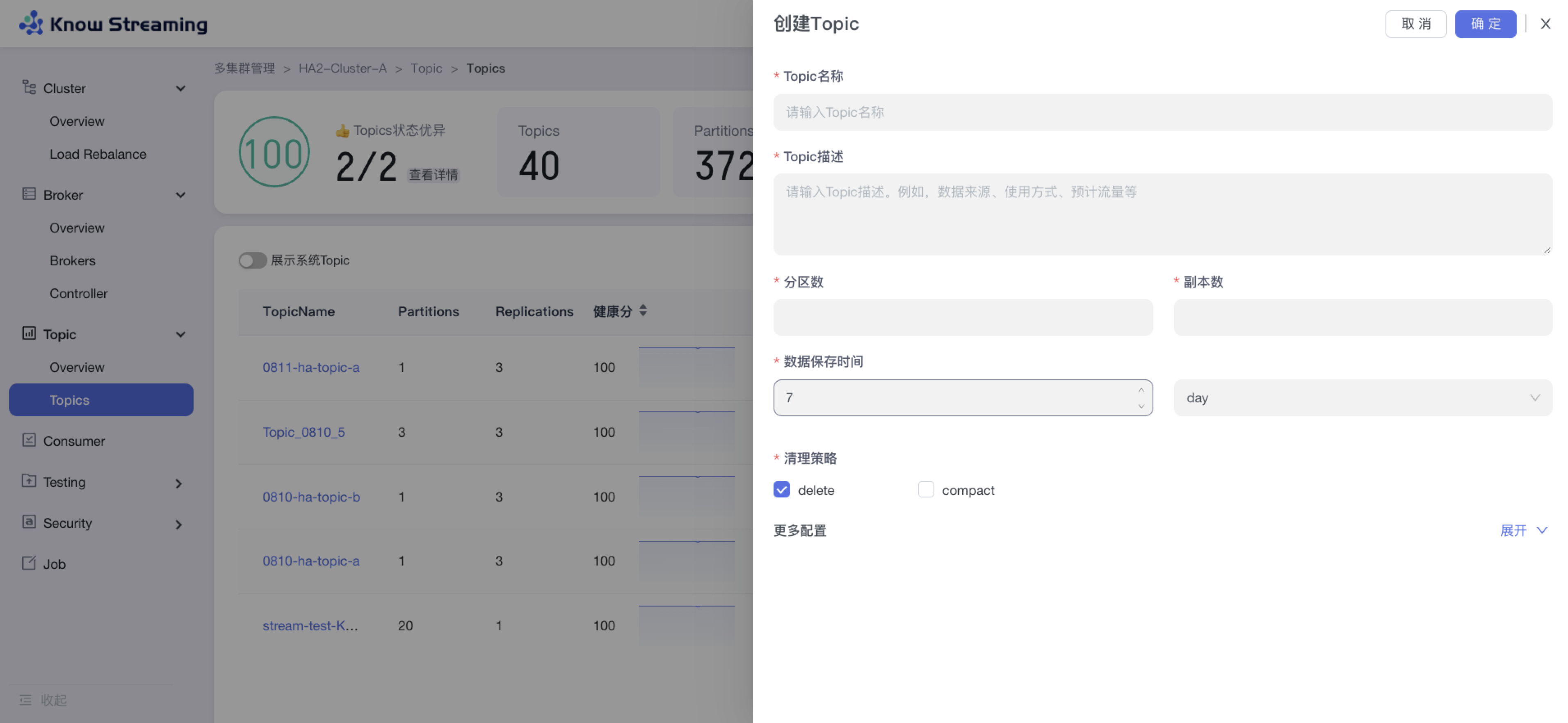

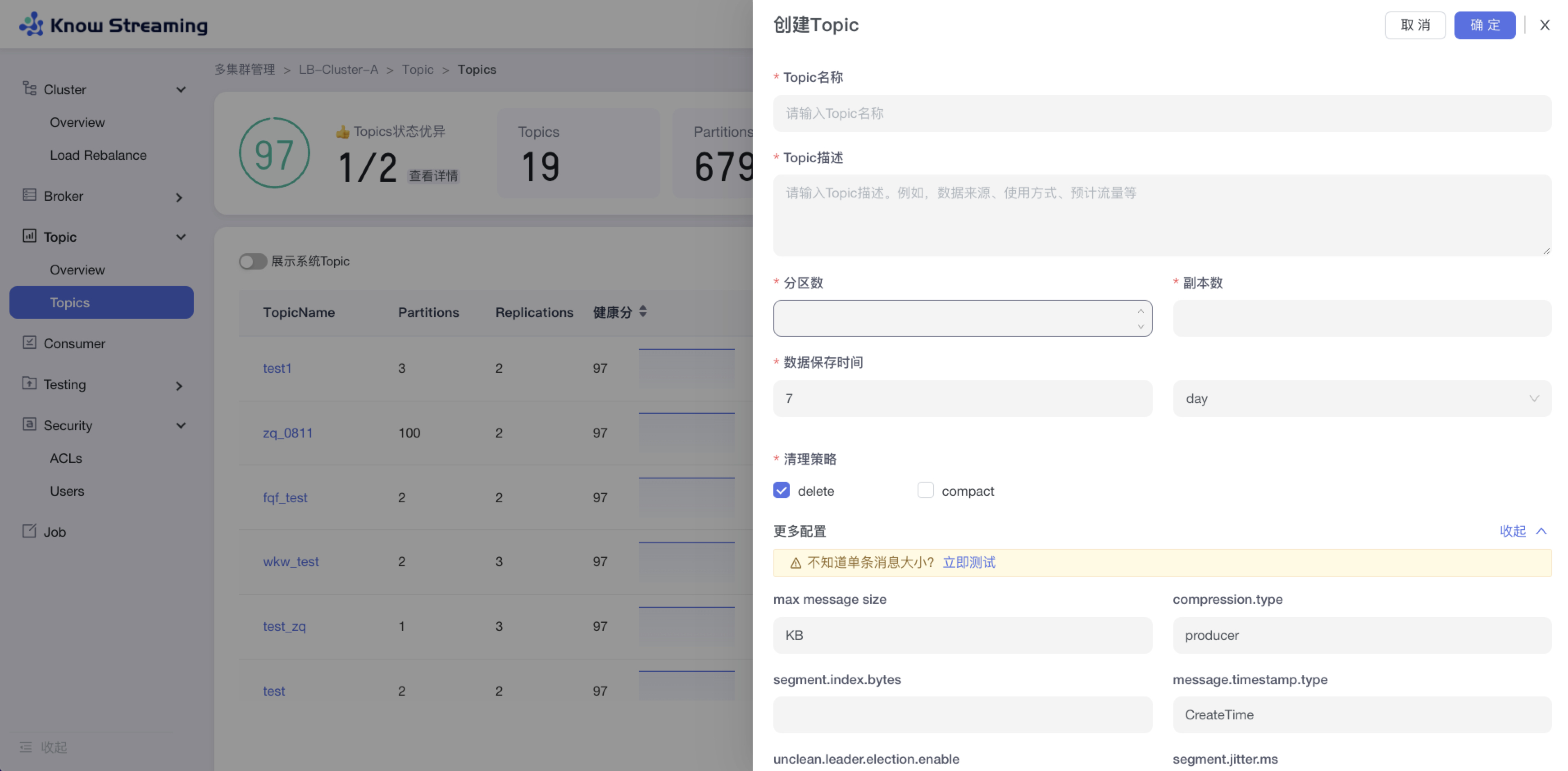

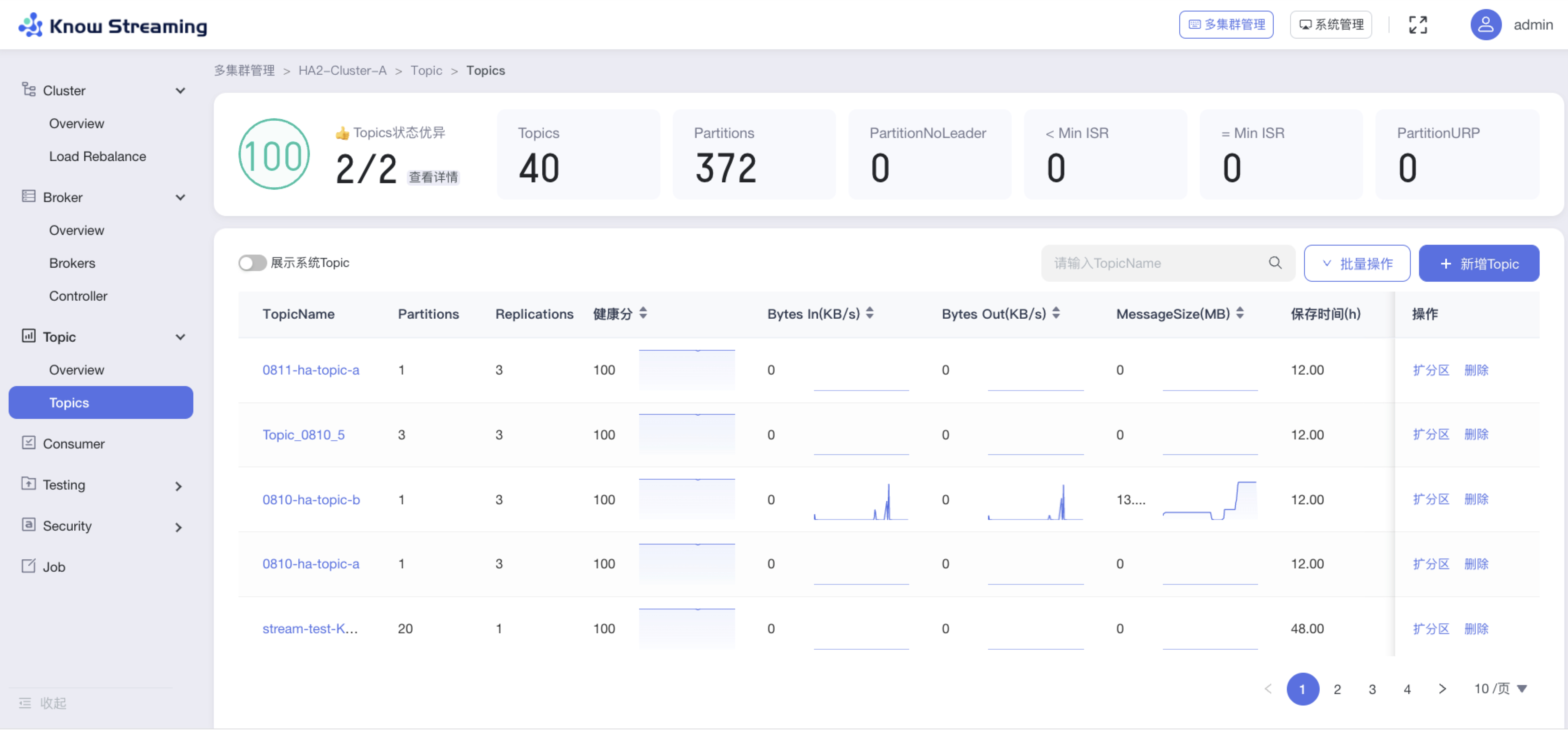

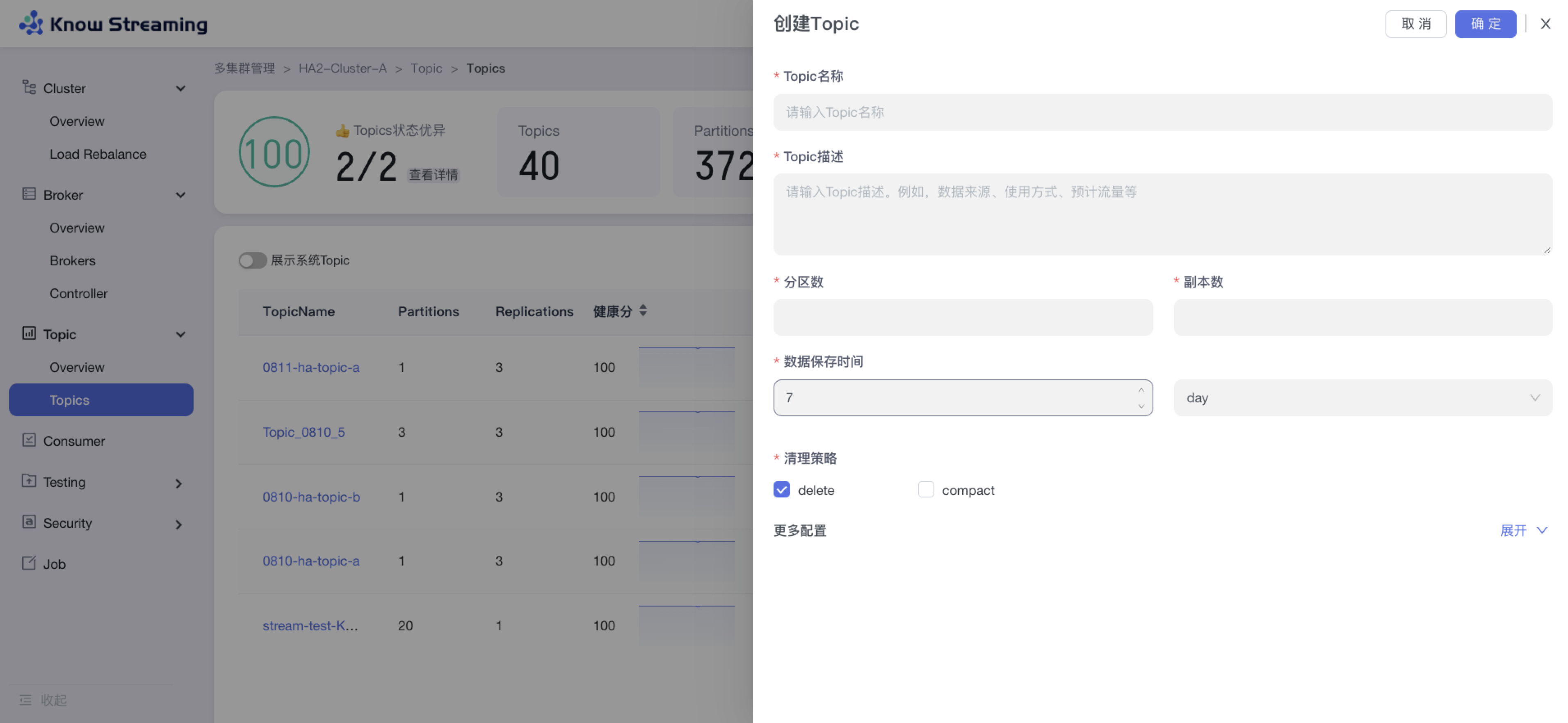

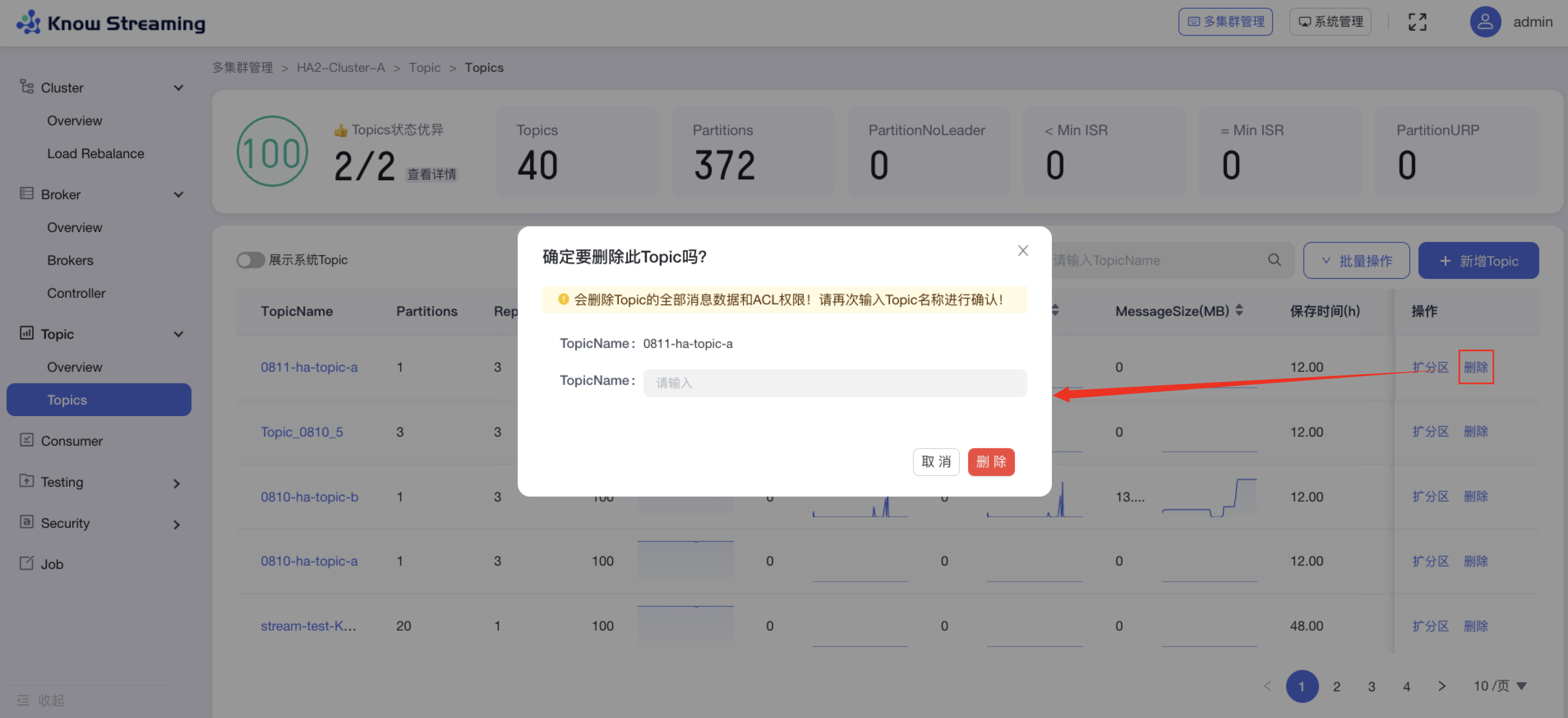

### 2.3.2、新增 Topic

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“新增 Topic”按钮>“创建 Topic“抽屉

|

||||

|

||||

- 步骤 2:输入“Topic 名称(不能重复)”、“Topic 描述”、“分区数”、“副本数”、“数据保存时间”、“清理策略(删除或压缩)”

|

||||

|

||||

- 步骤 3:展开“更多配置”可以打开高级配置选项,根据自己需要输入相应配置参数

|

||||

|

||||

- 步骤 4:点击“确定”,创建 Topic 完成

|

||||

|

||||

|

||||

|

||||

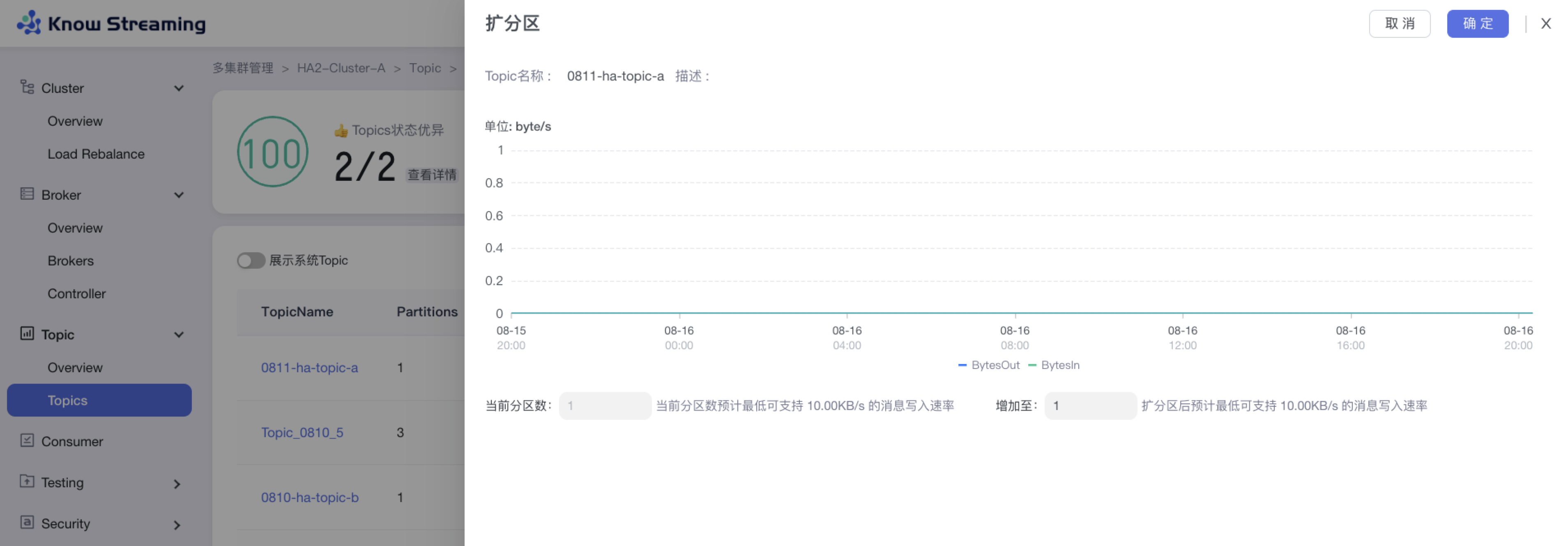

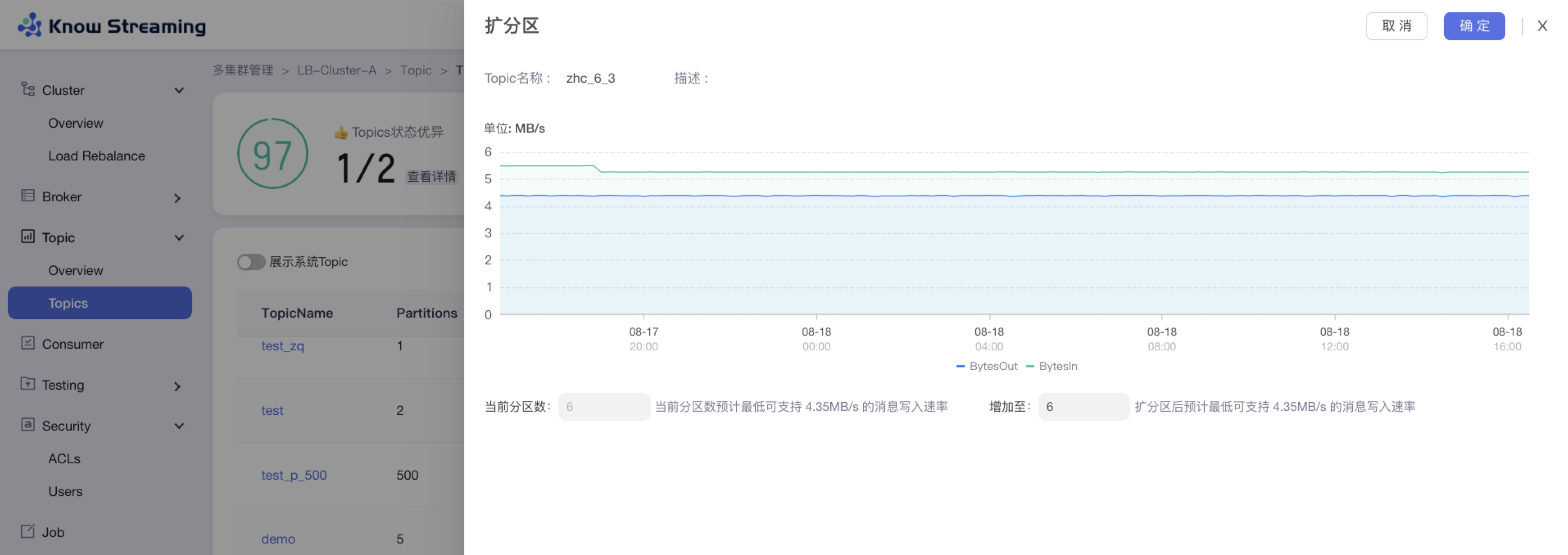

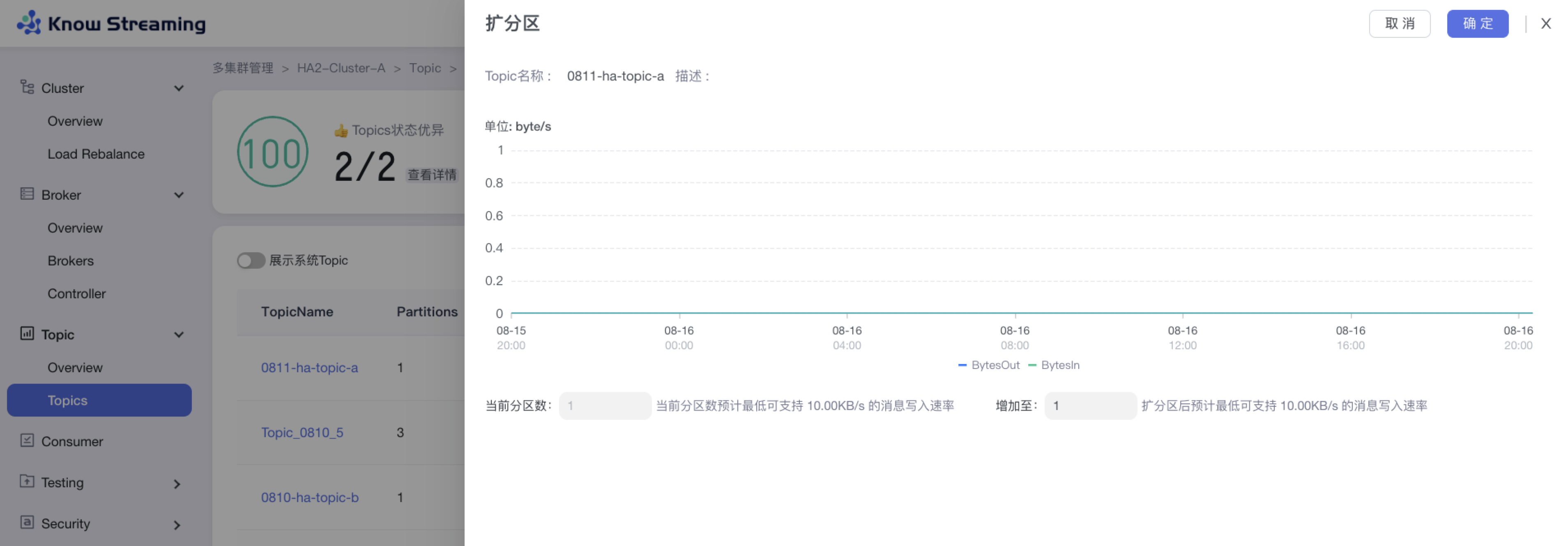

### 2.3.3、Topic 扩分区

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“Topic 列表“>操作项”扩分区“>“扩分区”抽屉

|

||||

|

||||

- 步骤 2:扩分区抽屉展示内容为“流量的趋势图”、“当前分区数及支持的最低消息写入速率”、“扩分区后支持的最低消息写入速率”

|

||||

|

||||

- 步骤 3:输入所需的分区总数,自动计算出扩分区后支持的最低消息写入速率

|

||||

|

||||

- 步骤 4:点击确定,扩分区完成

|

||||

|

||||

|

||||

|

||||

### 2.3.4、Topic 批量扩缩副本

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“批量操作下拉“>“批量扩缩副本“>“批量扩缩容”抽屉

|

||||

|

||||

- 步骤 2:选择所需要进行扩缩容的 Topic,可多选,所选择的 Topic 出现在下方 Topic 列表中

|

||||

|

||||

- 步骤 3:Topic 列表展示 Topic“近三天平均流量”、“近三天峰值流量及时间”、“Partition 数”、”当前副本数“、“新副本数”

|

||||

|

||||

- 步骤 4:扩容时,选择目标节点,新增的副本会在选择的目标节点上;缩容时不需要选择目标节点,自动删除最后一个(或几个)副本

|

||||

|

||||

- 步骤 5:输入迁移任务配置参数,包含限流值和任务执行时间

|

||||

|

||||

- 步骤 6:输入任务描述

|

||||

|

||||

- 步骤 7:点击“确定”,创建 Topic 扩缩副本任务

|

||||

|

||||

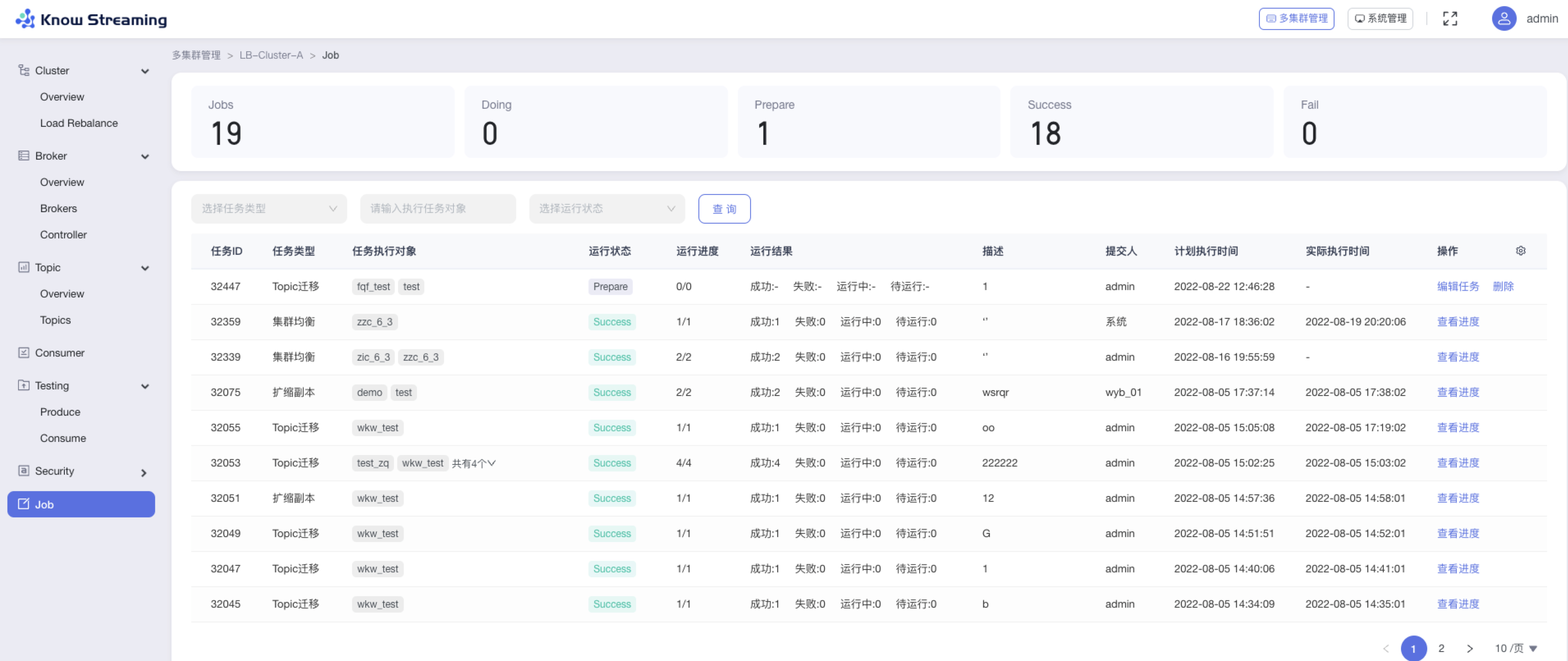

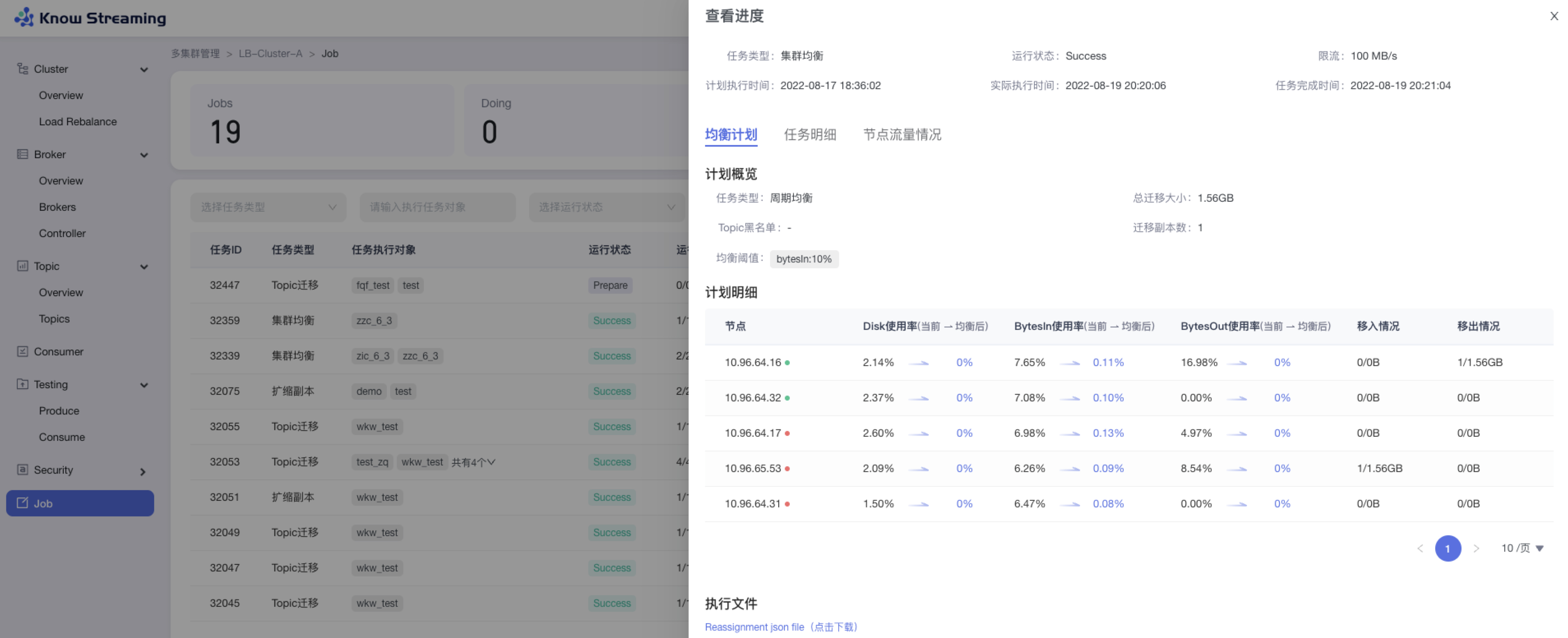

- 步骤 8:去“Job”模块的 Job 列表查看创建的任务,如果已经执行则可以查看执行进度;如果未开始执行则可以编辑任务

|

||||

|

||||

|

||||

|

||||

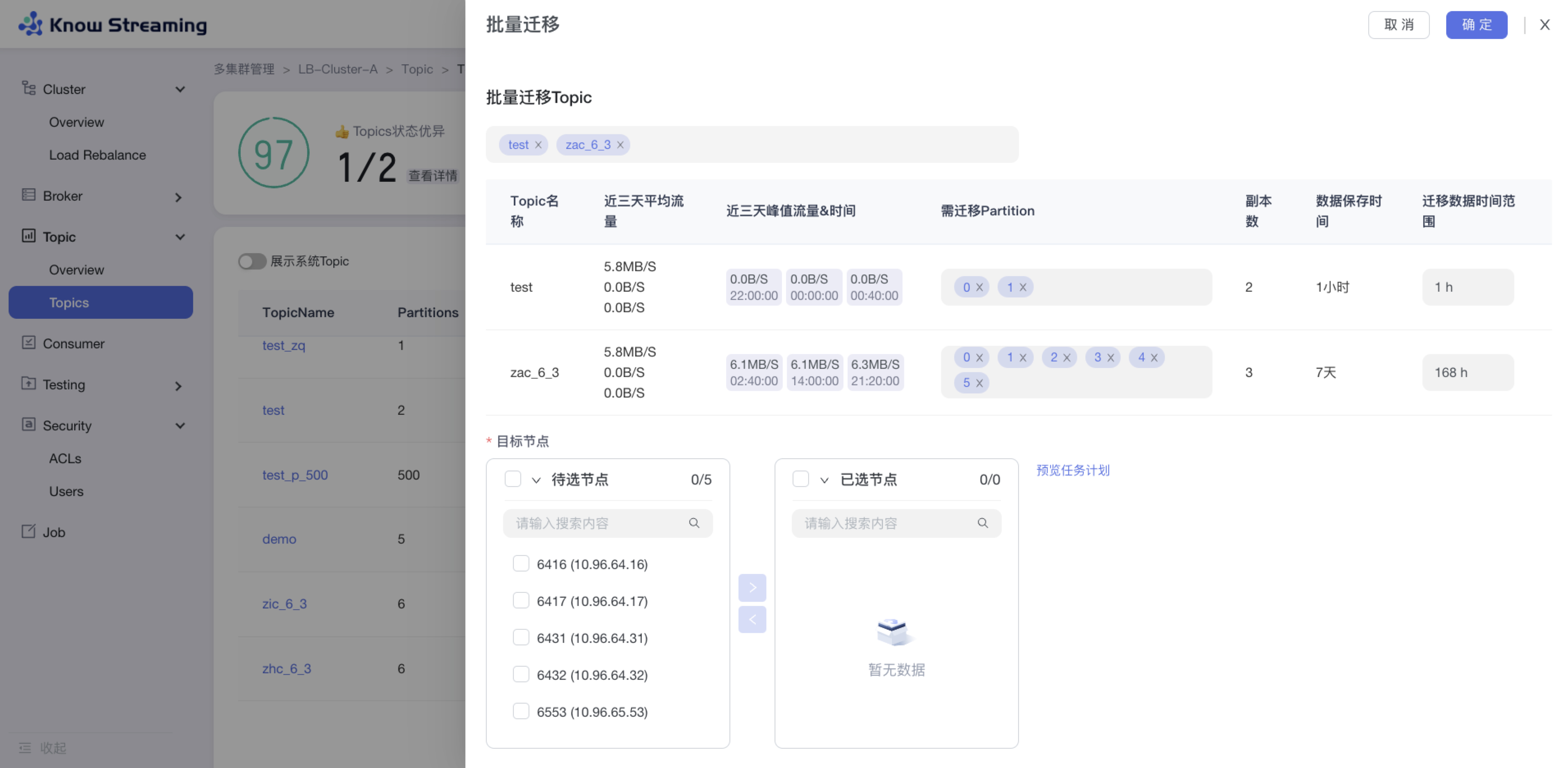

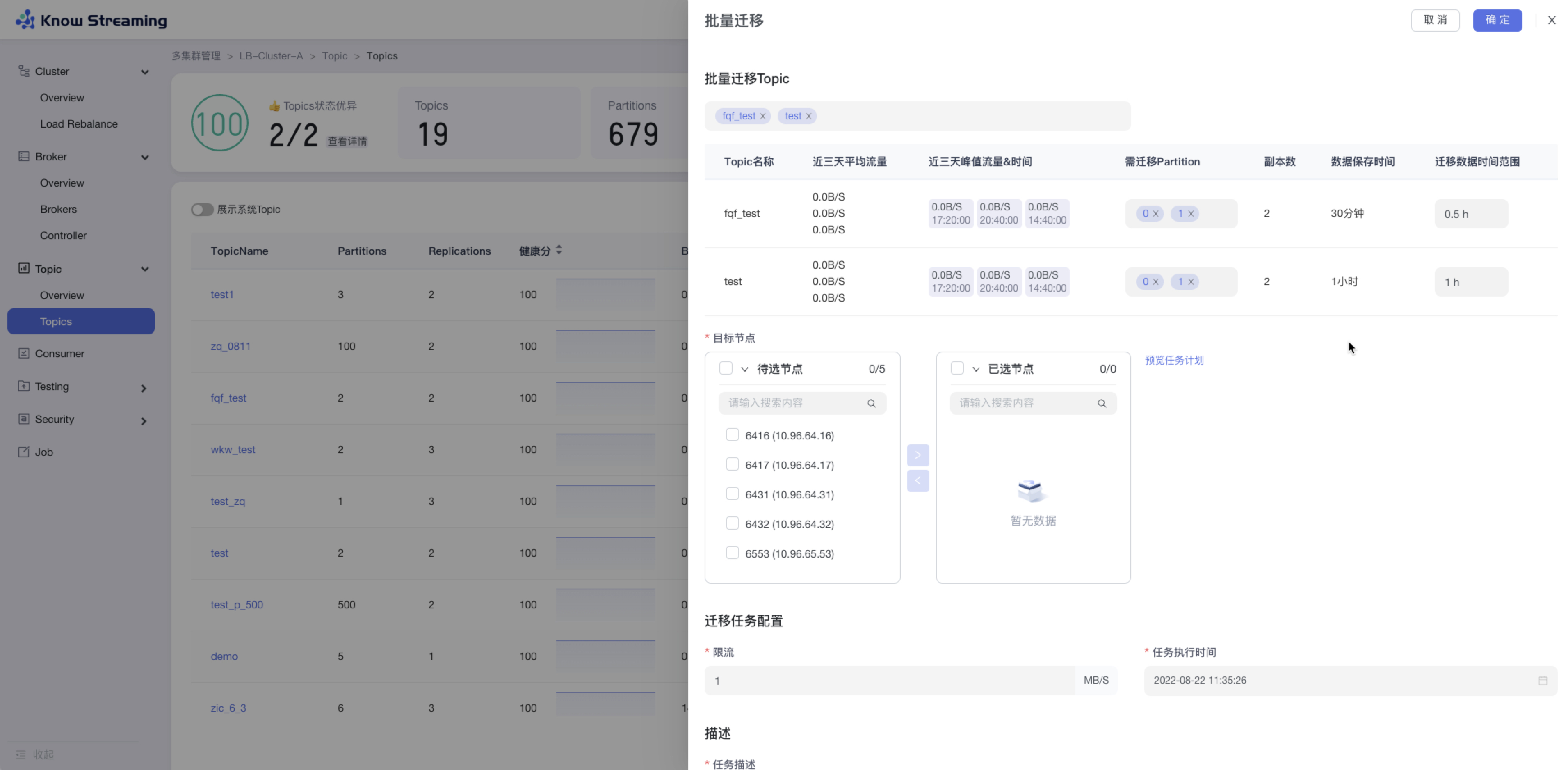

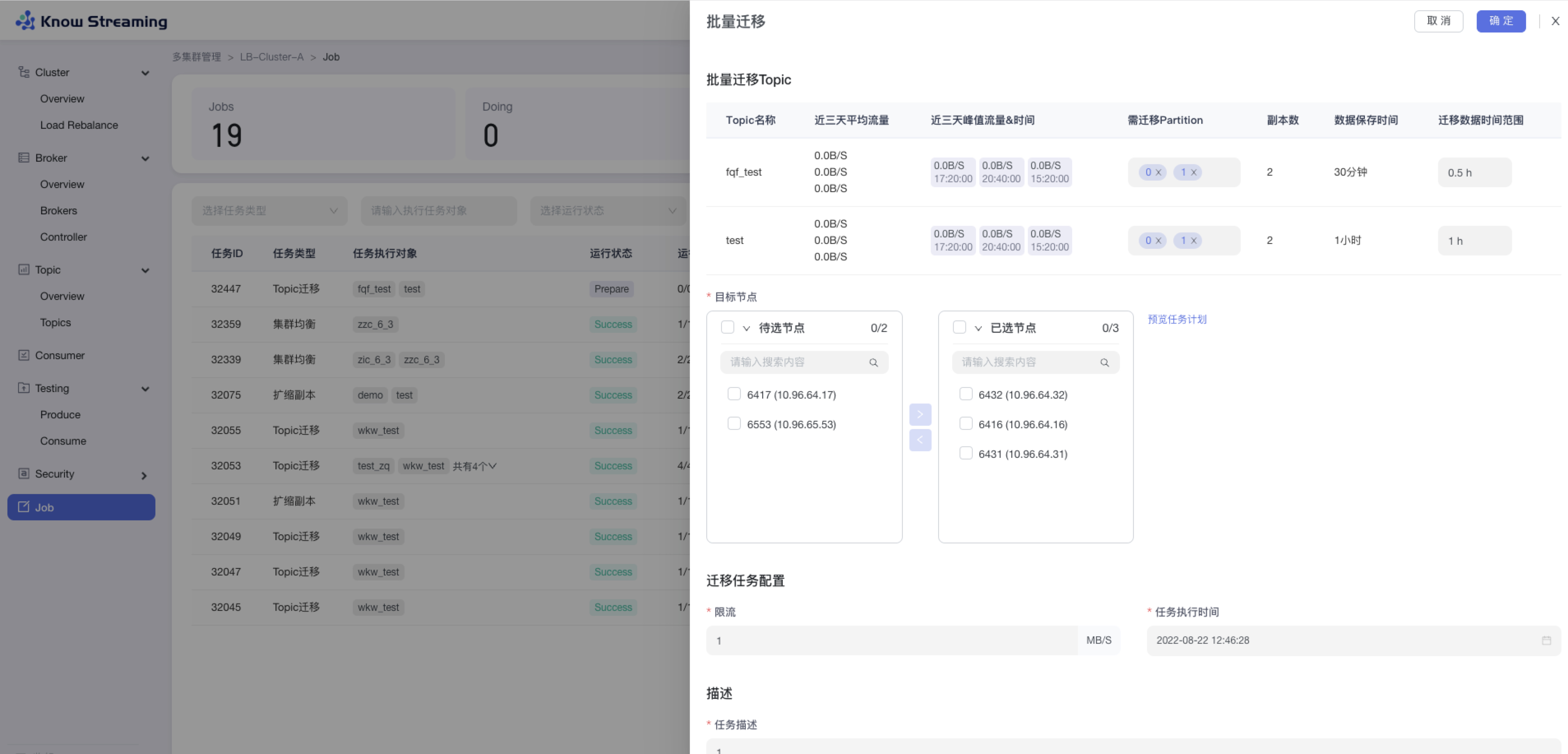

### 2.3.5、Topic 批量迁移

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“批量操作下拉“>“批量迁移“>“批量迁移”抽屉

|

||||

|

||||

- 步骤 2:选择所需要进行迁移的 Topic,可多选,所选择的 Topic 出现在下方 Topic 列表中

|

||||

|

||||

- 步骤 3:选择所需要迁移的 partition 和迁移数据的时间范围

|

||||

|

||||

- 步骤 4:选择目标节点(节点数必须不小于最大副本数)

|

||||

|

||||

- 步骤 5:点击“预览任务计划”,打开“任务计划”二次抽屉,可对目标 Broker ID 进行编辑

|

||||

|

||||

- 步骤 6:输入迁移任务配置参数,包含限流值和任务执行时间

|

||||

|

||||

- 步骤 7:输入任务描述

|

||||

|

||||

- 步骤 8:点击“确定”,创建 Topic 迁移任务

|

||||

|

||||

- 步骤 9:去“Job”模块的 Job 列表查看创建的任务,如果已经执行则可以查看执行进度;如果未开始执行则可以编辑任务

|

||||

|

||||

|

||||

|

||||

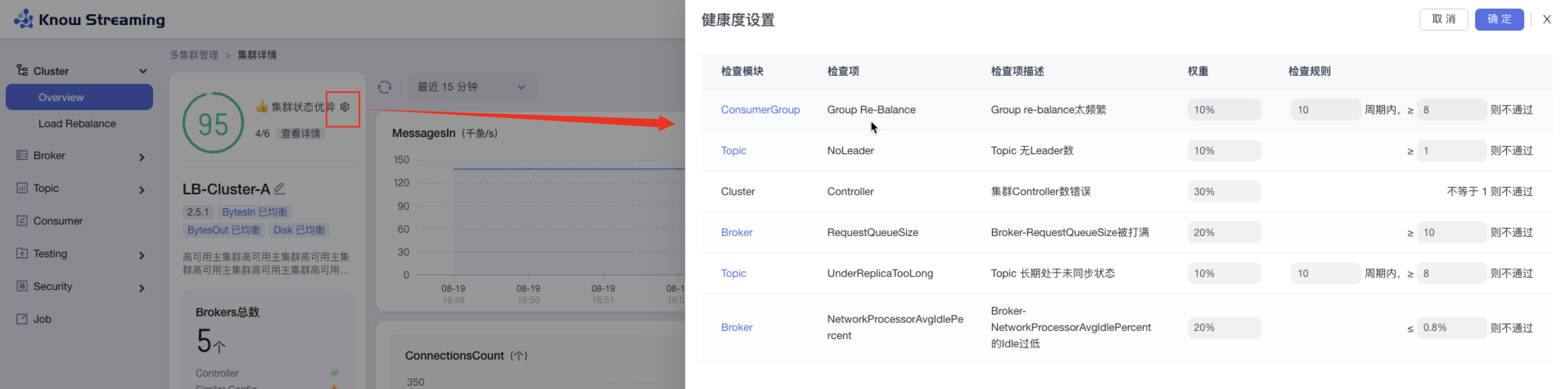

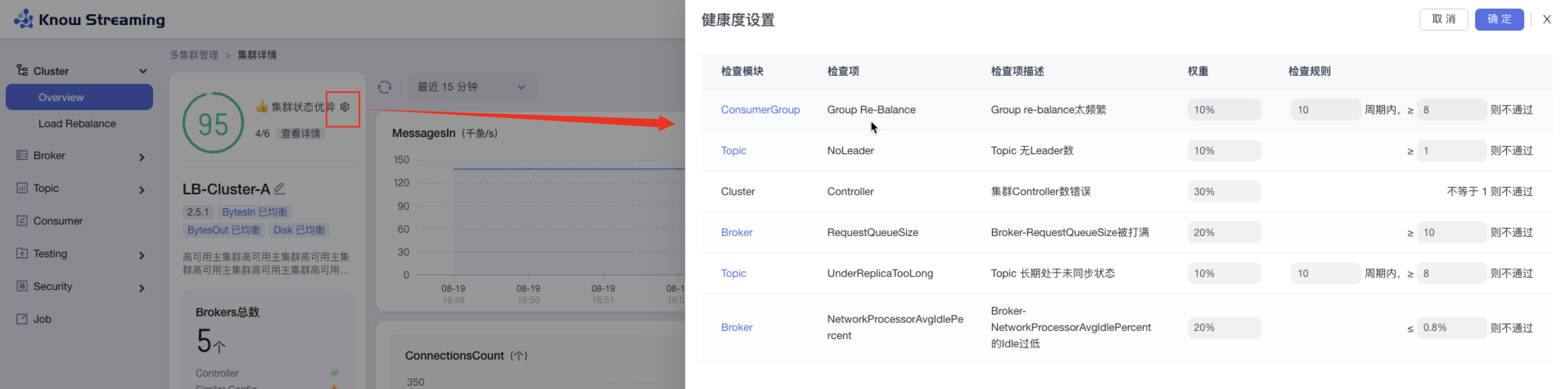

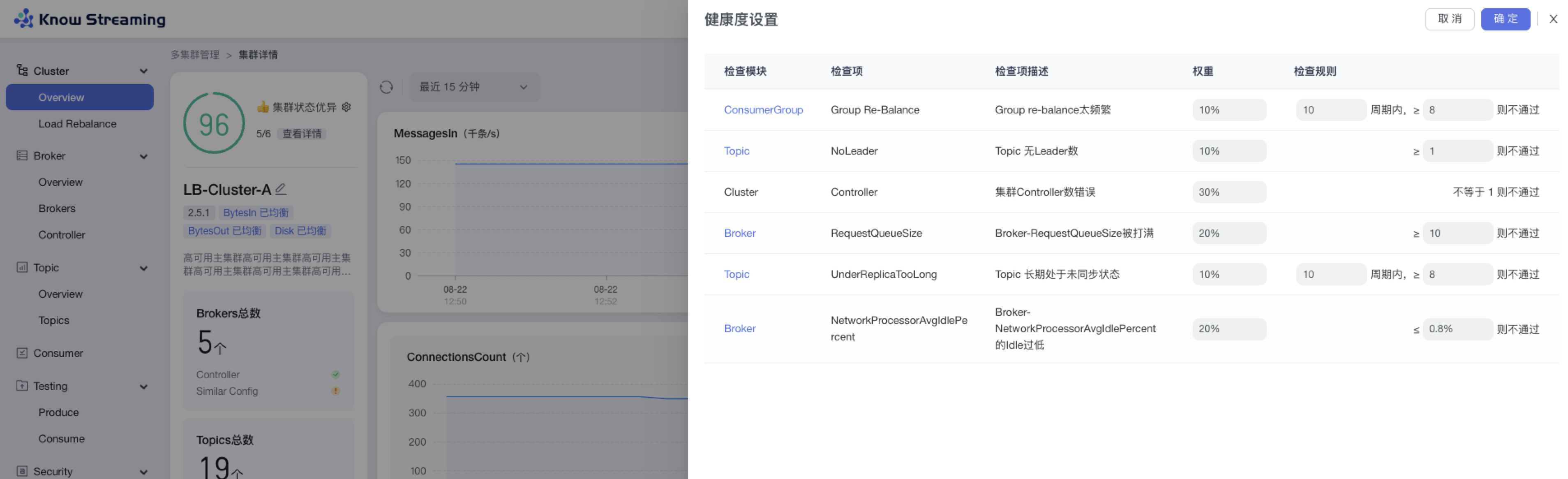

### 2.3.6、设置 Cluster 健康检查规则

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Cluster”>“Overview”>“集群健康状态旁边 icon”>“健康度设置抽屉”

|

||||

|

||||

- 步骤 2:健康度设置抽屉展示出了检查项和其对应的权重,可以修改检查项的检查规则

|

||||

|

||||

- 步骤 3:检查规则可配置,分别为

|

||||

|

||||

- Cluster:集群 controller 数不等于 1(数字不可配置)不通过

|

||||

- Broker:RequestQueueSize 大于等于 10(默认为 10,可配置数字)不通过

|

||||

- Broker:NetworkProcessorAvgIdlePercent 的 Idle 小于等于 0.8%(默认为 0.8%,可配置数字)不通过

|

||||

- Topic:无 leader 的 Topic 数量,大于等于 1(默认为 1,数字可配置)不通过

|

||||

- Topic:Topic 在 10(默认为 10,数字可配置)个周期内 8(默认为 8,数字可配置)个周期内处于未同步的状态则不通过

|

||||

- ConsumerGroup:Group 在 10(默认为 10,数字可配置)个周期内进行 8(默认为 8,数字可配置)次 re-balance 不通过

|

||||

|

||||

- 步骤 4:设置完成后,点击“确认”,健康检查规则设置成功

|

||||

|

||||

|

||||

|

||||

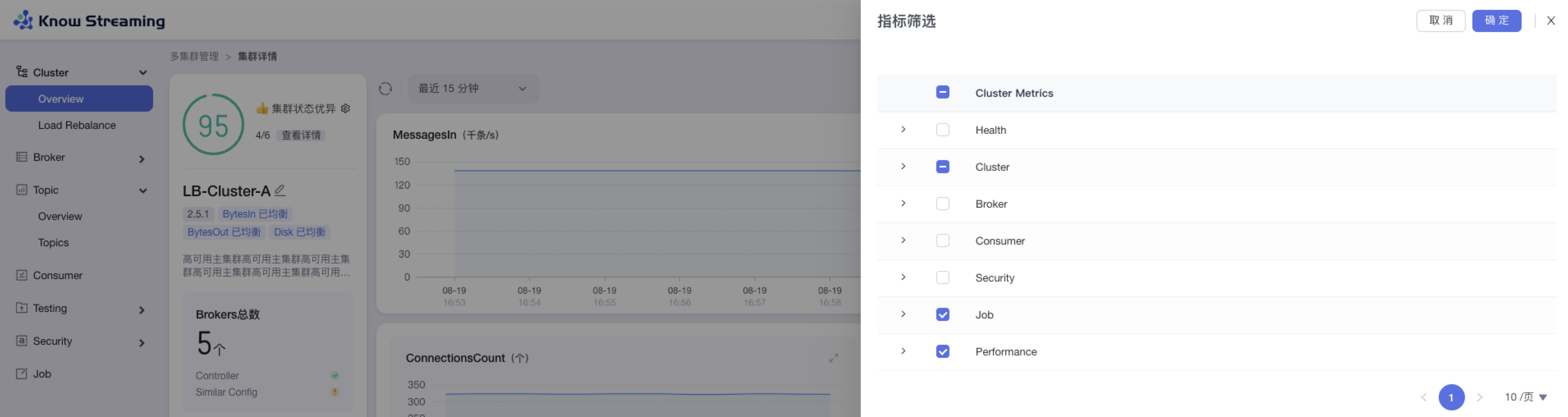

### 2.3.7、图表指标筛选

|

||||

|

||||

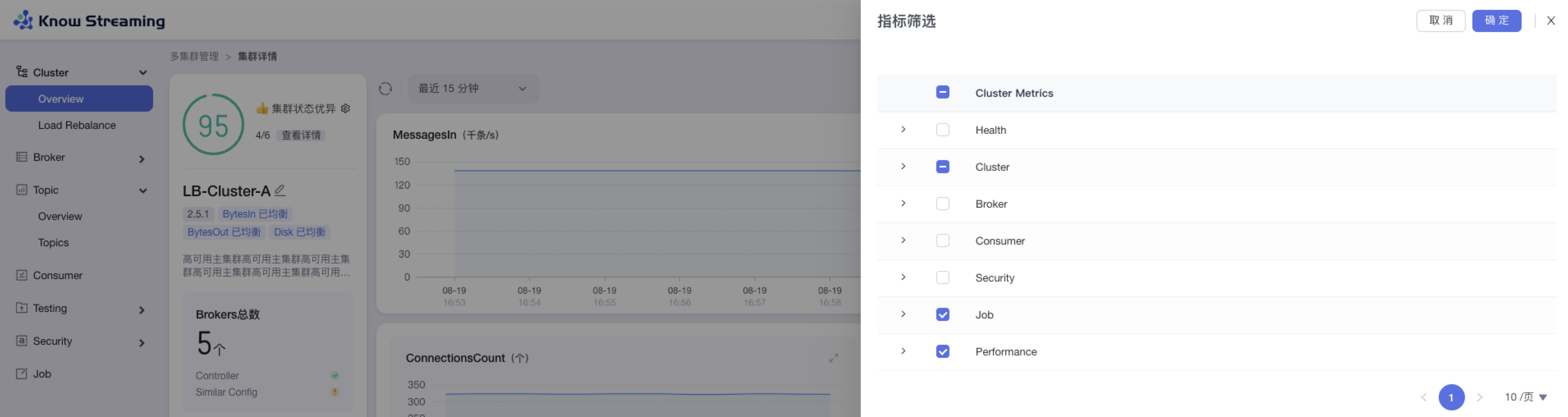

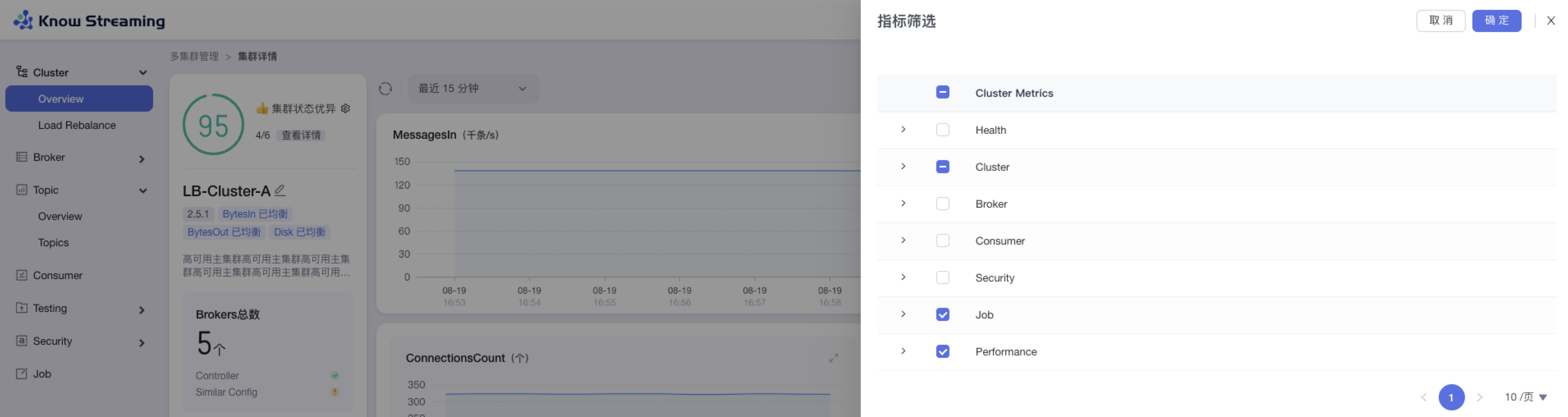

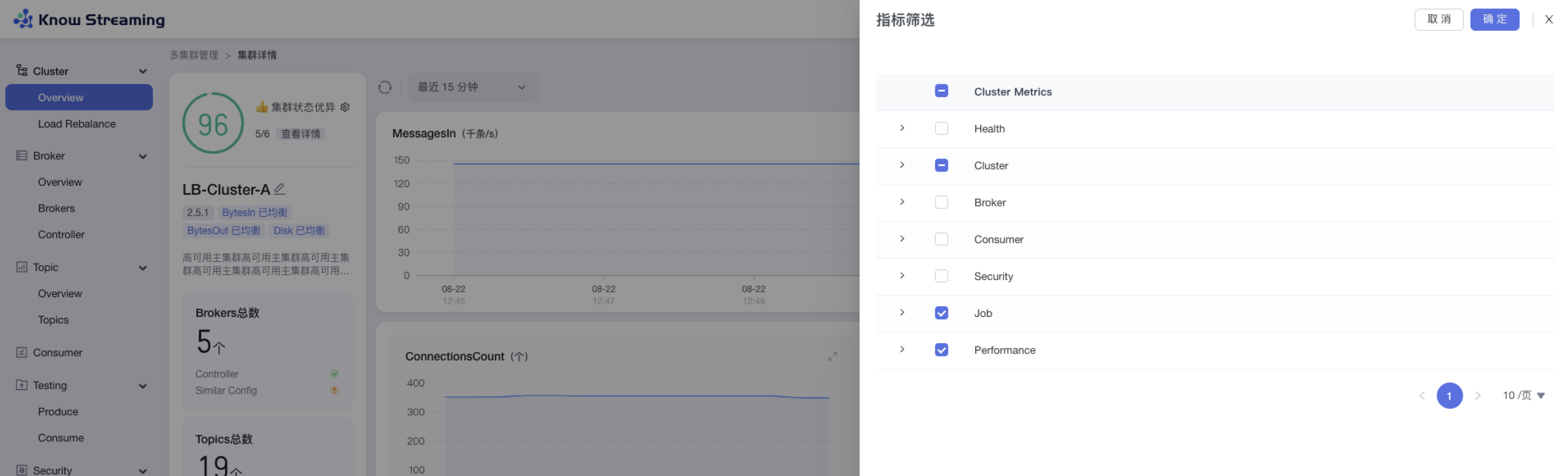

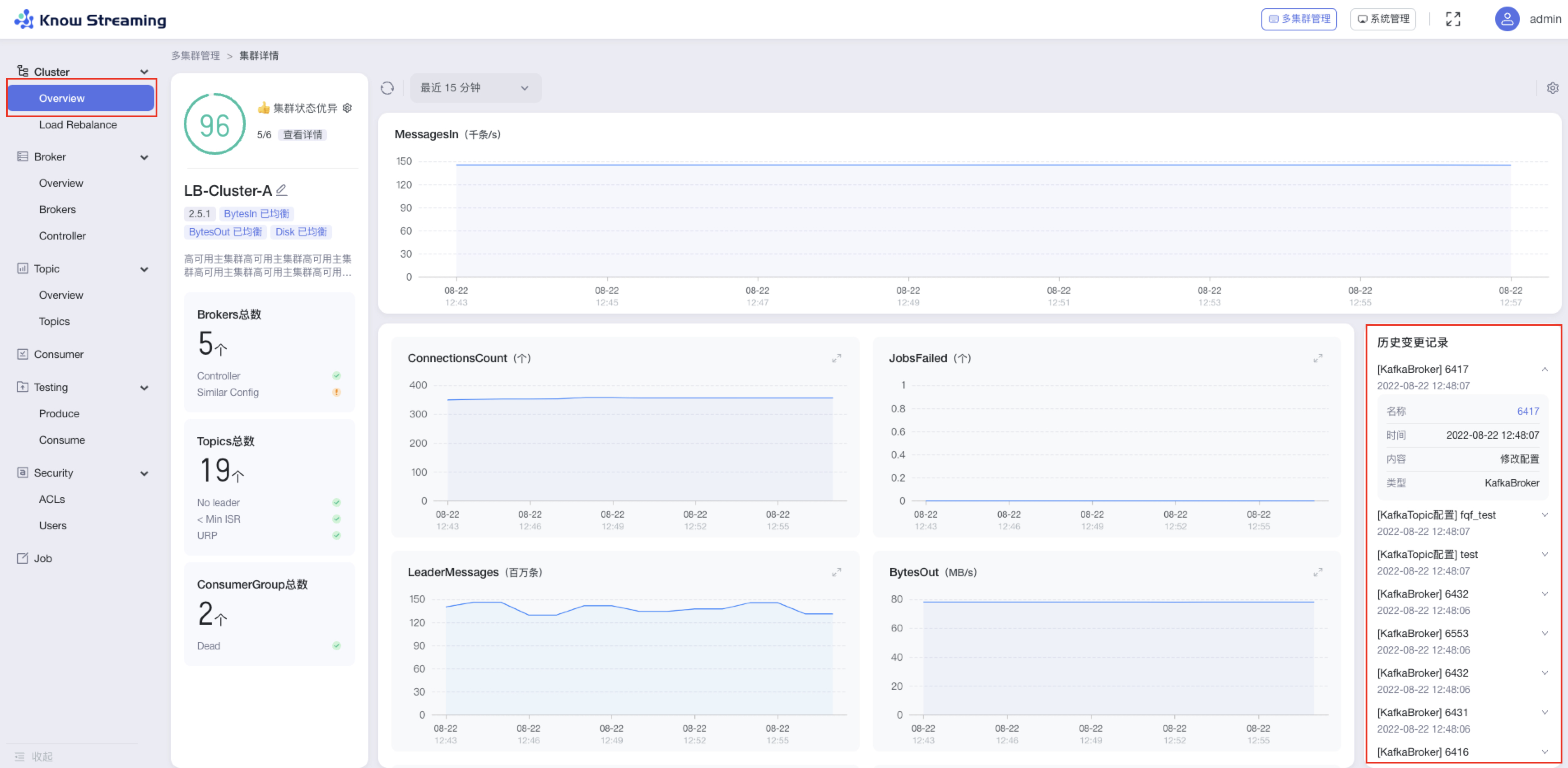

- 步骤 1:点击“多集群管理”>“集群卡片”>“Cluster”>“Overview”>“指标筛选 icon”>“指标筛选抽屉”

|

||||

|

||||

- 步骤 2:指标筛选抽屉展示信息为以下几类“Health”、“Cluster”、“Broker”、“Consumer”、“Security”、“Job”

|

||||

|

||||

- 步骤 3:默认勾选比较重要的指标进行展示。根据需要选中/取消选中相应指标,点击”确认“,指标筛选成功,展示的图表随之变化

|

||||

|

||||

|

||||

|

||||

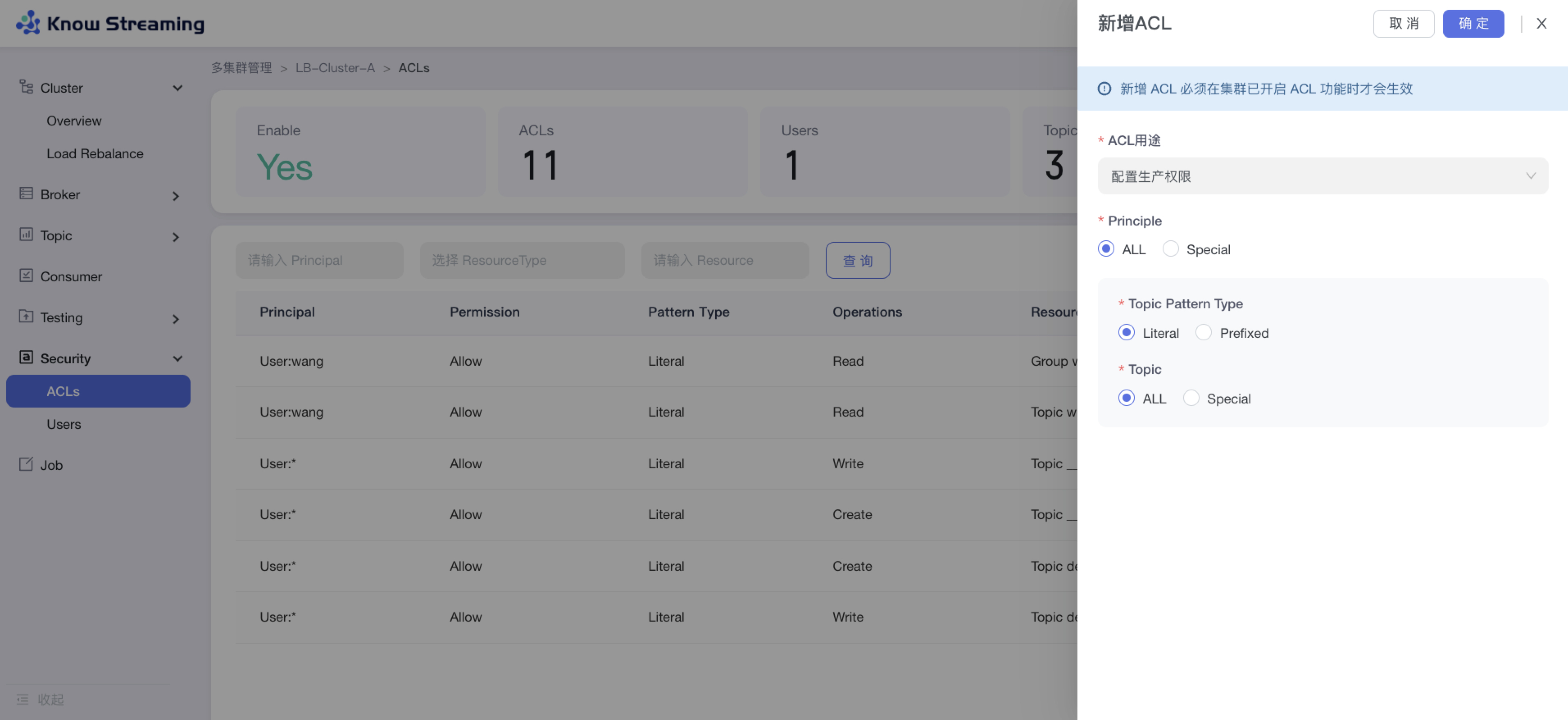

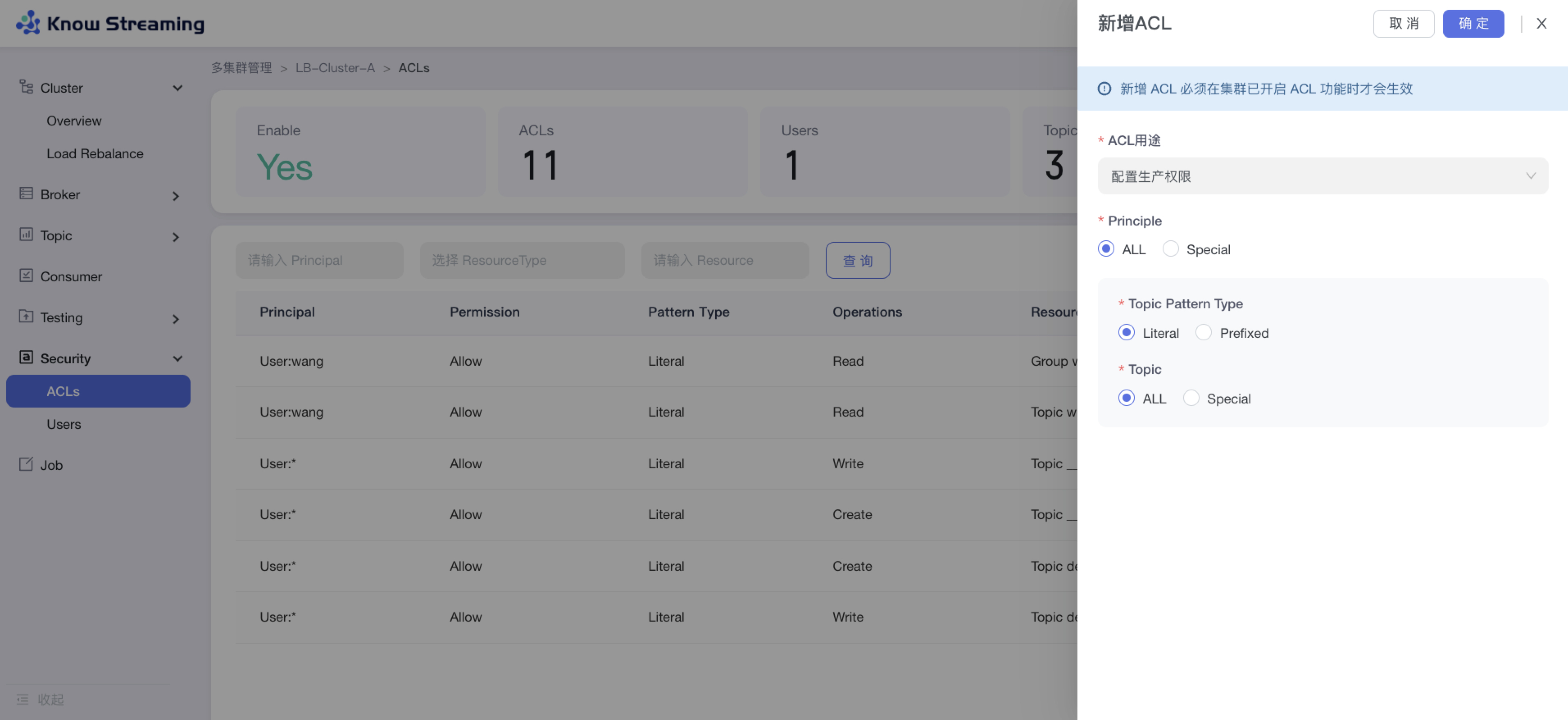

### 2.3.8、新增 ACL

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Security”>“Users”>“新增 ACL”

|

||||

|

||||

- 步骤 2:输入 ACL 配置参数

|

||||

|

||||

- ACL 用途:生产权限、消费权限、自定义权限

|

||||

- 生产权限时:可选择应用于所有 Kafka User 或者特定 Kafka User;可选择应用于所有 Topic 或者特定 Topic

|

||||

- 消费权限时:可选择应用于所有 Kafka User 或者特定 Kafka User;可选择应用于所有 Topic 或者特定 Topic;可选择应用于所有 Consumer Group 或者特定 Consumer Group

|

||||

|

||||

- 步骤 3:点击“确定”,新增 ACL 成功

|

||||

|

||||

|

||||

|

||||

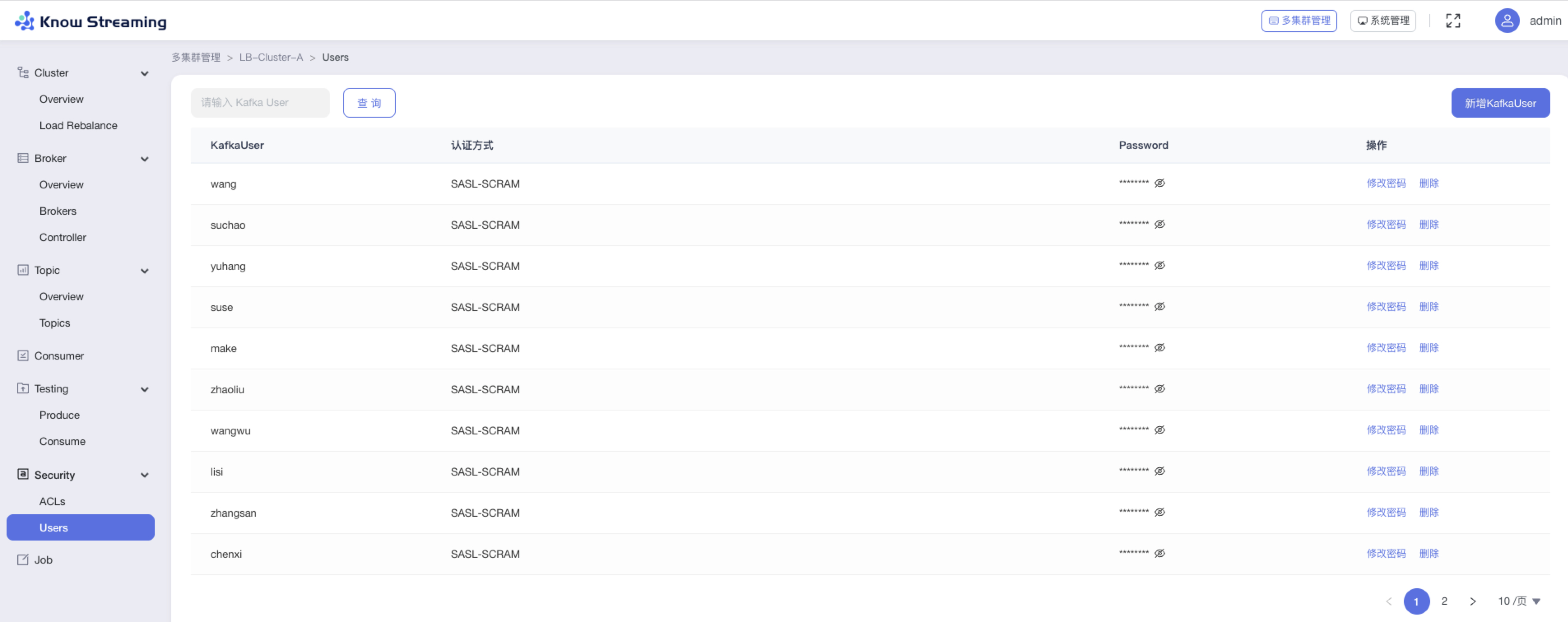

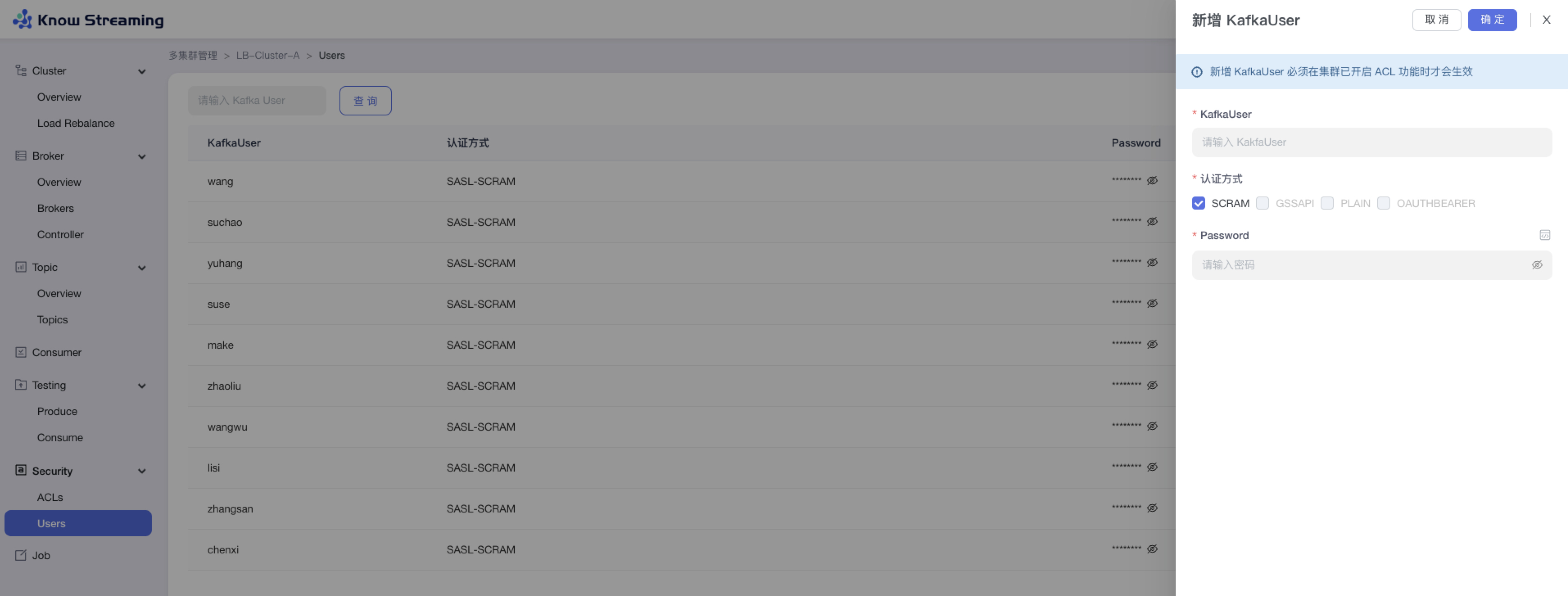

### 2.3.9、用户管理

|

||||

|

||||

用户管理是提供给管理员进行人员管理和用户角色管理的功能模块,可以进行新增用户和分配角色。下面是一个典型的场景:

|

||||

eg:团队加入了新成员,需要给这位成员分配一个使用系统的账号,需要以下几个步骤

|

||||

|

||||

- 步骤 1:点击“系统管理”>“用户管理”>“人员管理”>“新增用户”,输入“账号”、“实名”、“密码”,根据此账号所需要的权限,选择此账号所对应的角色。如果有满足权限的角色,则用户新增成功。如果没有满足权限的角色,则需要新增角色(步骤 2)

|

||||

|

||||

- 步骤 2:点击“系统管理”>“用户管理”>“角色管理”>“新增角色”。输入角色名称和描述,给此角色分配权限,点击“确定”,角色新增成功

|

||||

|

||||

- 步骤 3:根据此新增的角色,参考步骤 1,重新新增用户

|

||||

|

||||

- 步骤 4:此用户账号新增成功,可以进行登录产品使用

|

||||

|

||||

|

||||

213

product/3-design-doc.md

Normal file

213

product/3-design-doc.md

Normal file

@@ -0,0 +1,213 @@

|

||||

---

|

||||

order: 3

|

||||

title: '3.设计文档'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

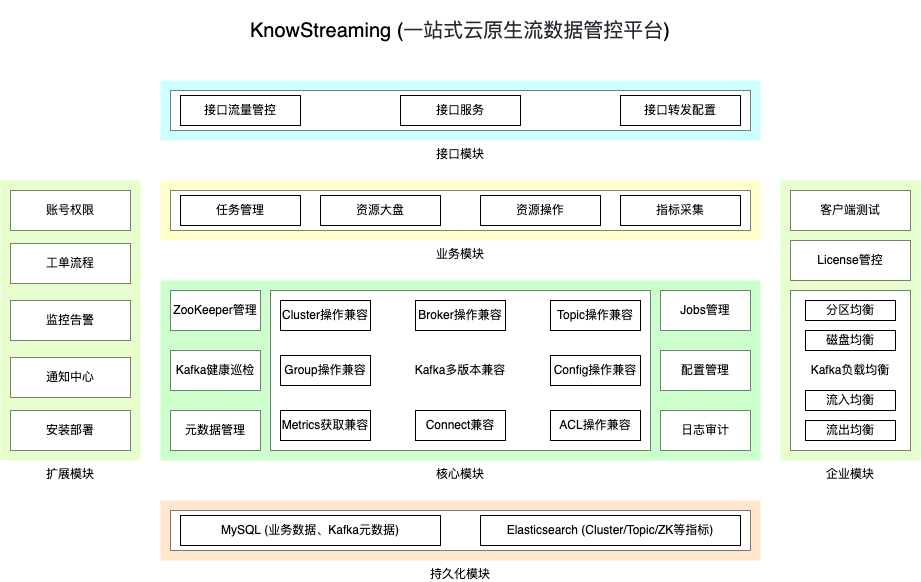

## 3.1、架构设计

|

||||

|

||||

### 3.1.1、功能架构

|

||||

|

||||

|

||||

|

||||

### 3.1.2、技术架构

|

||||

|

||||

|

||||

|

||||

## 3.2、生态对接(持续完善)

|

||||

|

||||

### 3.2.1、LDAP 对接(持续完善)

|

||||

|

||||

### 3.2.2、Prometheus + Grafana 对接

|

||||

|

||||

安装配置 Knowstreaming + Prometheus + Grafana,参考 https://prometheus.io/docs/visualization/grafana/

|

||||

|

||||

#### 配置 promethues

|

||||

|

||||

```yaml

|

||||

scrape_configs:

|

||||

- job_name: 'ks'

|

||||

# ks metrics 路径

|

||||

metrics_path: '/metrics/prometheus'

|

||||

static_configs:

|

||||

# ks 集群地址

|

||||

- targets: ['172.16.1.10:8080', '172.16.1.11:8080', '172.16.1.12:8080']

|

||||

```

|

||||

|

||||

配置完成后,重启 prometheus

|

||||

|

||||

```sh

|

||||

curl -X POST http://localhost:9090/-/reload

|

||||

```

|

||||

|

||||

访问 promethues 查看指标是否采集成功

|

||||

|

||||

- Cluster_MessagesIn

|

||||

- ...

|

||||

|

||||

#### 配置 grafana

|

||||

|

||||

- 配置 Prometheus 源

|

||||

- 参考 https://prometheus.io/docs/visualization/grafana/

|

||||

- 导入监控面板配置文件

|

||||

- https://grafana.com/grafana/dashboards/16729-knowstreaming/

|

||||

|

||||

|

||||

|

||||

|

||||

#### 预览

|

||||

|

||||

|

||||

|

||||

## 3.3、指标说明

|

||||

|

||||

当前 KnowStreaming 支持针对 kafka 集群的多维度指标的采集和展示,同时也支持多个 kafka 版本的指标进行兼容,以下是 KnowStreaming 支持的指标说明。

|

||||

|

||||

现在对当前 KnowStreaming 支持的指标从指标名称、指标单位、指标说明、kafka 版本、企业/开源版指标 五个维度进行说明。

|

||||

|

||||

### 3.3.1、Cluster 指标

|

||||

|

||||

| 指标名称 | 指标单位 | 指标含义 | kafka 版本 | 企业/开源版指标 |

|

||||

| ------------------------- | -------- | ------------------------------------ | ---------------- | --------------- |

|

||||

| HealthScore | 分 | 集群总体的健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed | 个 | 集群总体健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal | 个 | 集群总体健康检查总数 | 全部版本 | 开源版 |

|

||||

| HealthScore_Topics | 分 | 集群 Topics 的健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed_Topics | 个 | 集群 Topics 健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal_Topics | 个 | 集群 Topics 健康检查总数 | 全部版本 | 开源版 |

|

||||

| HealthScore_Brokers | 分 | 集群 Brokers 的健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed_Brokers | 个 | 集群 Brokers 健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal_Brokers | 个 | 集群 Brokers 健康检查总数 | 全部版本 | 开源版 |

|

||||

| HealthScore_Groups | 分 | 集群 Groups 的健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed_Groups | 个 | 集群 Groups 健康检查总数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal_Groups | 个 | 集群 Groups 健康检查总数 | 全部版本 | 开源版 |

|

||||

| HealthScore_Cluster | 分 | 集群自身的健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed_Cluster | 个 | 集群自身健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal_Cluster | 个 | 集群自身健康检查总数 | 全部版本 | 开源版 |

|

||||

| TotalRequestQueueSize | 个 | 集群中总的请求队列数 | 全部版本 | 开源版 |

|

||||

| TotalResponseQueueSize | 个 | 集群中总的响应队列数 | 全部版本 | 开源版 |

|

||||

| EventQueueSize | 个 | 集群中 Controller 的 EventQueue 大小 | 2.0.0 及以上版本 | 开源版 |

|

||||

| ActiveControllerCount | 个 | 集群中存活的 Controller 数 | 全部版本 | 开源版 |

|

||||

| TotalProduceRequests | 个 | 集群中的 Produce 每秒请求数 | 全部版本 | 开源版 |

|

||||

| TotalLogSize | byte | 集群总的已使用的磁盘大小 | 全部版本 | 开源版 |

|

||||

| ConnectionsCount | 个 | 集群的连接(Connections)个数 | 全部版本 | 开源版 |

|

||||

| Zookeepers | 个 | 集群中存活的 zk 节点个数 | 全部版本 | 开源版 |

|

||||

| ZookeepersAvailable | 是/否 | ZK 地址是否合法 | 全部版本 | 开源版 |

|

||||

| Brokers | 个 | 集群的 broker 的总数 | 全部版本 | 开源版 |

|

||||

| BrokersAlive | 个 | 集群的 broker 的存活数 | 全部版本 | 开源版 |

|

||||

| BrokersNotAlive | 个 | 集群的 broker 的未存活数 | 全部版本 | 开源版 |

|

||||

| Replicas | 个 | 集群中 Replica 的总数 | 全部版本 | 开源版 |

|

||||

| Topics | 个 | 集群中 Topic 的总数 | 全部版本 | 开源版 |

|

||||

| Partitions | 个 | 集群的 Partitions 总数 | 全部版本 | 开源版 |

|

||||

| PartitionNoLeader | 个 | 集群中的 PartitionNoLeader 总数 | 全部版本 | 开源版 |

|

||||

| PartitionMinISR_S | 个 | 集群中的小于 PartitionMinISR 总数 | 全部版本 | 开源版 |

|

||||

| PartitionMinISR_E | 个 | 集群中的等于 PartitionMinISR 总数 | 全部版本 | 开源版 |

|

||||

| PartitionURP | 个 | 集群中的未同步的 Partition 总数 | 全部版本 | 开源版 |

|

||||

| MessagesIn | 条/s | 集群每条消息写入条数 | 全部版本 | 开源版 |

|

||||

| Messages | 条 | 集群总的消息条数 | 全部版本 | 开源版 |

|

||||

| LeaderMessages | 条 | 集群中 leader 总的消息条数 | 全部版本 | 开源版 |

|

||||

| BytesIn | byte/s | 集群的每秒写入字节数 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_5 | byte/s | 集群的每秒写入字节数,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_15 | byte/s | 集群的每秒写入字节数,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut | byte/s | 集群的每秒流出字节数 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_5 | byte/s | 集群的每秒流出字节数,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_15 | byte/s | 集群的每秒流出字节数,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| Groups | 个 | 集群中 Group 的总数 | 全部版本 | 开源版 |

|

||||

| GroupActives | 个 | 集群中 ActiveGroup 的总数 | 全部版本 | 开源版 |

|

||||

| GroupEmptys | 个 | 集群中 EmptyGroup 的总数 | 全部版本 | 开源版 |

|

||||

| GroupRebalances | 个 | 集群中 RebalanceGroup 的总数 | 全部版本 | 开源版 |

|

||||

| GroupDeads | 个 | 集群中 DeadGroup 的总数 | 全部版本 | 开源版 |

|

||||

| Alive | 是/否 | 集群是否存活,1:存活;0:没有存活 | 全部版本 | 开源版 |

|

||||

| AclEnable | 是/否 | 集群是否开启 Acl,1:是;0:否 | 全部版本 | 开源版 |

|

||||

| Acls | 个 | ACL 数 | 全部版本 | 开源版 |

|

||||

| AclUsers | 个 | ACL-KafkaUser 数 | 全部版本 | 开源版 |

|

||||

| AclTopics | 个 | ACL-Topic 数 | 全部版本 | 开源版 |

|

||||

| AclGroups | 个 | ACL-Group 数 | 全部版本 | 开源版 |

|

||||

| Jobs | 个 | 集群任务总数 | 全部版本 | 开源版 |

|

||||

| JobsRunning | 个 | 集群 running 任务总数 | 全部版本 | 开源版 |

|

||||

| JobsWaiting | 个 | 集群 waiting 任务总数 | 全部版本 | 开源版 |

|

||||

| JobsSuccess | 个 | 集群 success 任务总数 | 全部版本 | 开源版 |

|

||||

| JobsFailed | 个 | 集群 failed 任务总数 | 全部版本 | 开源版 |

|

||||

| LoadReBalanceEnable | 是/否 | 是否开启均衡, 1:是;0:否 | 全部版本 | 企业版 |

|

||||

| LoadReBalanceCpu | 是/否 | CPU 是否均衡, 1:是;0:否 | 全部版本 | 企业版 |

|

||||

| LoadReBalanceNwIn | 是/否 | BytesIn 是否均衡, 1:是;0:否 | 全部版本 | 企业版 |

|

||||

| LoadReBalanceNwOut | 是/否 | BytesOut 是否均衡, 1:是;0:否 | 全部版本 | 企业版 |

|

||||

| LoadReBalanceDisk | 是/否 | Disk 是否均衡, 1:是;0:否 | 全部版本 | 企业版 |

|

||||

|

||||

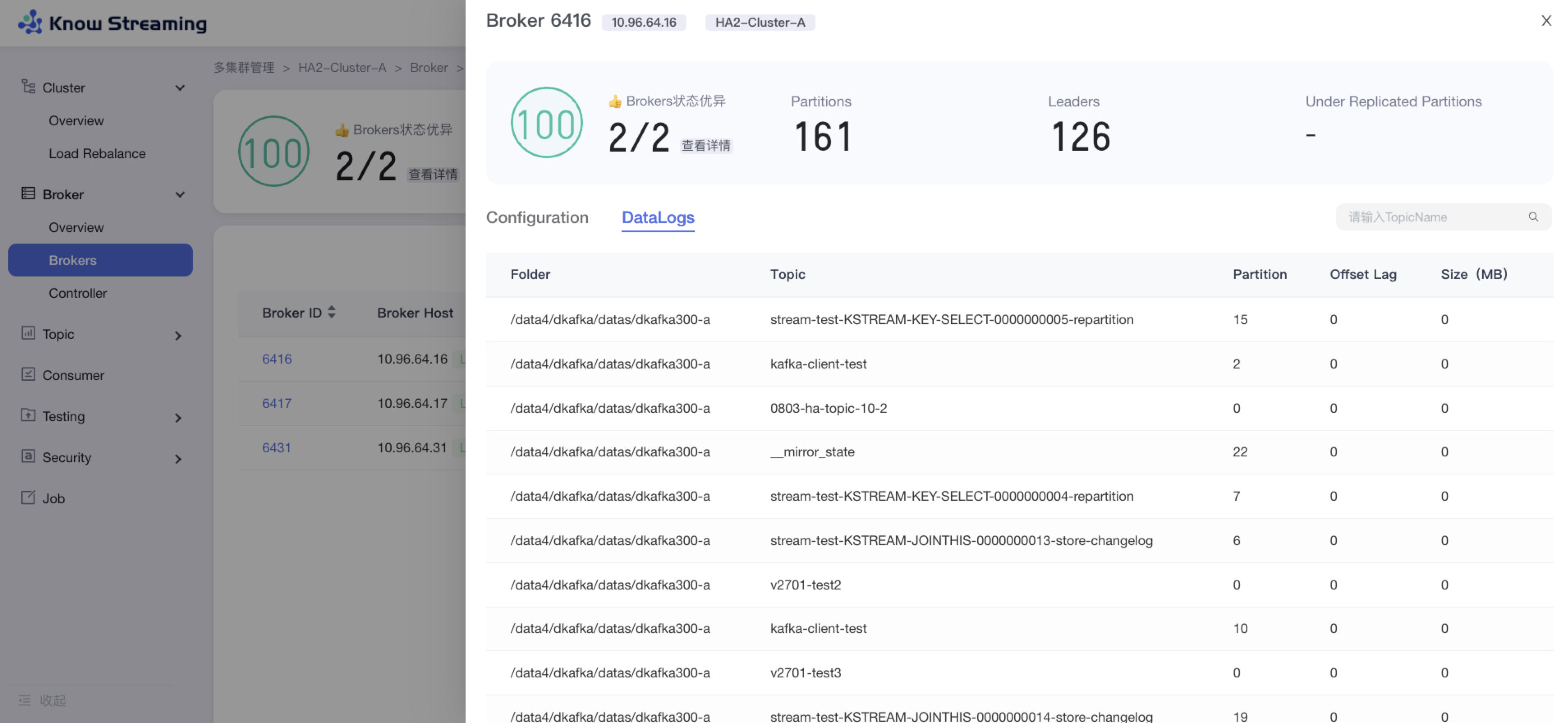

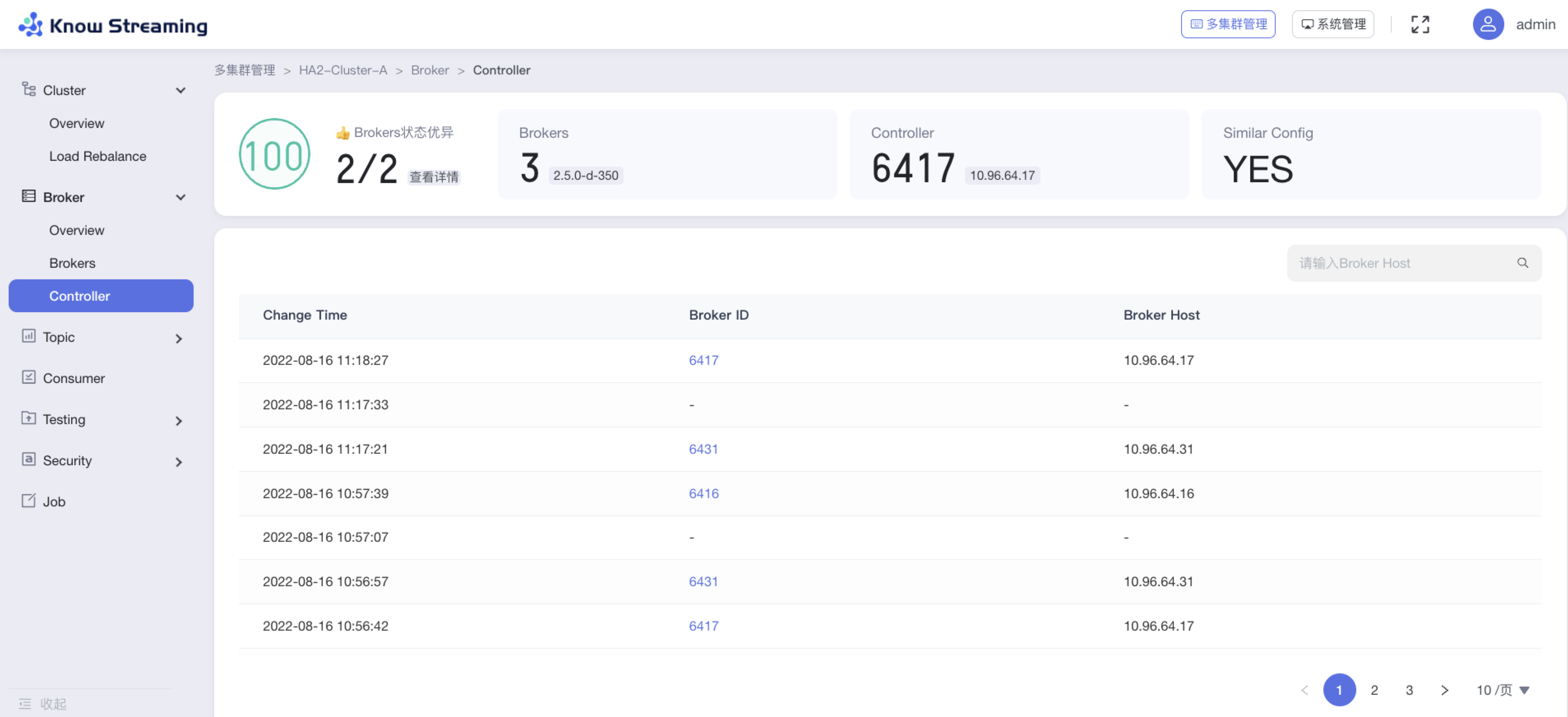

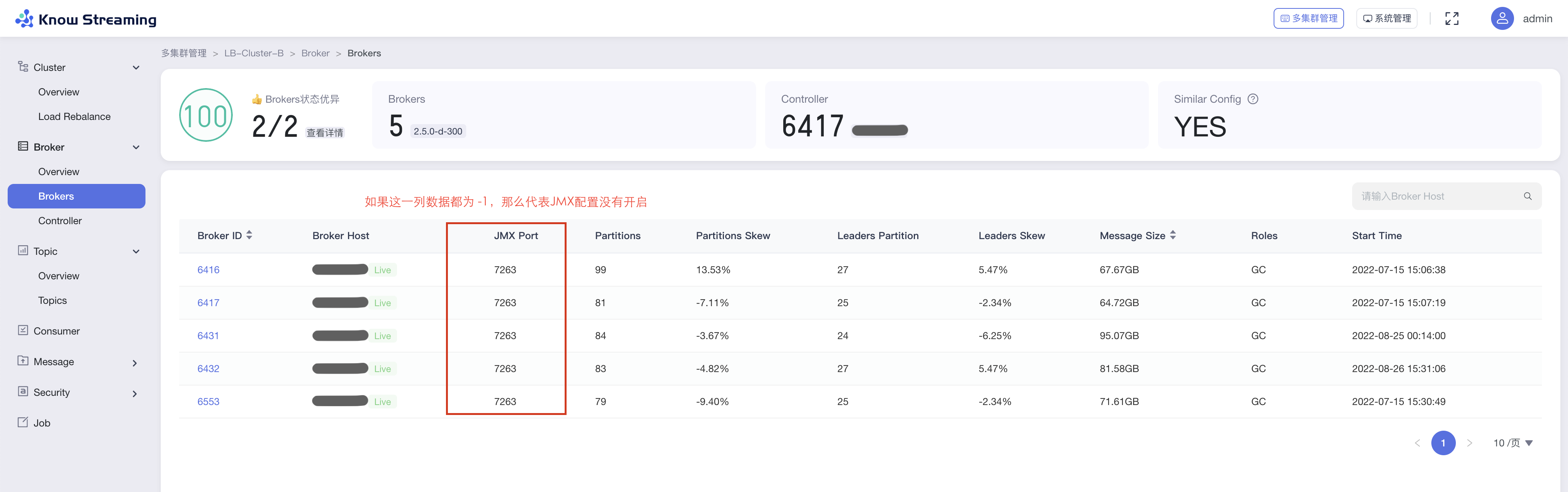

### 3.3.2、Broker 指标

|

||||

|

||||

| 指标名称 | 指标单位 | 指标含义 | kafka 版本 | 企业/开源版指标 |

|

||||

| ----------------------- | -------- | ------------------------------------- | ---------- | --------------- |

|

||||

| HealthScore | 分 | Broker 健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed | 个 | Broker 健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal | 个 | Broker 健康检查总数 | 全部版本 | 开源版 |

|

||||

| TotalRequestQueueSize | 个 | Broker 的请求队列大小 | 全部版本 | 开源版 |

|

||||

| TotalResponseQueueSize | 个 | Broker 的应答队列大小 | 全部版本 | 开源版 |

|

||||

| ReplicationBytesIn | byte/s | Broker 的副本流入流量 | 全部版本 | 开源版 |

|

||||

| ReplicationBytesOut | byte/s | Broker 的副本流出流量 | 全部版本 | 开源版 |

|

||||

| MessagesIn | 条/s | Broker 的每秒消息流入条数 | 全部版本 | 开源版 |

|

||||

| TotalProduceRequests | 个/s | Broker 上 Produce 的每秒请求数 | 全部版本 | 开源版 |

|

||||

| NetworkProcessorAvgIdle | % | Broker 的网络处理器的空闲百分比 | 全部版本 | 开源版 |

|

||||

| RequestHandlerAvgIdle | % | Broker 上请求处理器的空闲百分比 | 全部版本 | 开源版 |

|

||||

| PartitionURP | 个 | Broker 上的未同步的副本的个数 | 全部版本 | 开源版 |

|

||||

| ConnectionsCount | 个 | Broker 上网络链接的个数 | 全部版本 | 开源版 |

|

||||

| BytesIn | byte/s | Broker 的每秒数据写入量 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_5 | byte/s | Broker 的每秒数据写入量,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_15 | byte/s | Broker 的每秒数据写入量,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut | byte/s | Broker 的每秒数据流出量 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_5 | byte/s | Broker 的每秒数据流出量,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_15 | byte/s | Broker 的每秒数据流出量,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| ReassignmentBytesIn | byte/s | Broker 的每秒数据迁移写入量 | 全部版本 | 开源版 |

|

||||

| ReassignmentBytesOut | byte/s | Broker 的每秒数据迁移流出量 | 全部版本 | 开源版 |

|

||||

| Partitions | 个 | Broker 上的 Partition 个数 | 全部版本 | 开源版 |

|

||||

| PartitionsSkew | % | Broker 上的 Partitions 倾斜度 | 全部版本 | 开源版 |

|

||||

| Leaders | 个 | Broker 上的 Leaders 个数 | 全部版本 | 开源版 |

|

||||

| LeadersSkew | % | Broker 上的 Leaders 倾斜度 | 全部版本 | 开源版 |

|

||||

| LogSize | byte | Broker 上的消息容量大小 | 全部版本 | 开源版 |

|

||||

| Alive | 是/否 | Broker 是否存活,1:存活;0:没有存活 | 全部版本 | 开源版 |

|

||||

|

||||

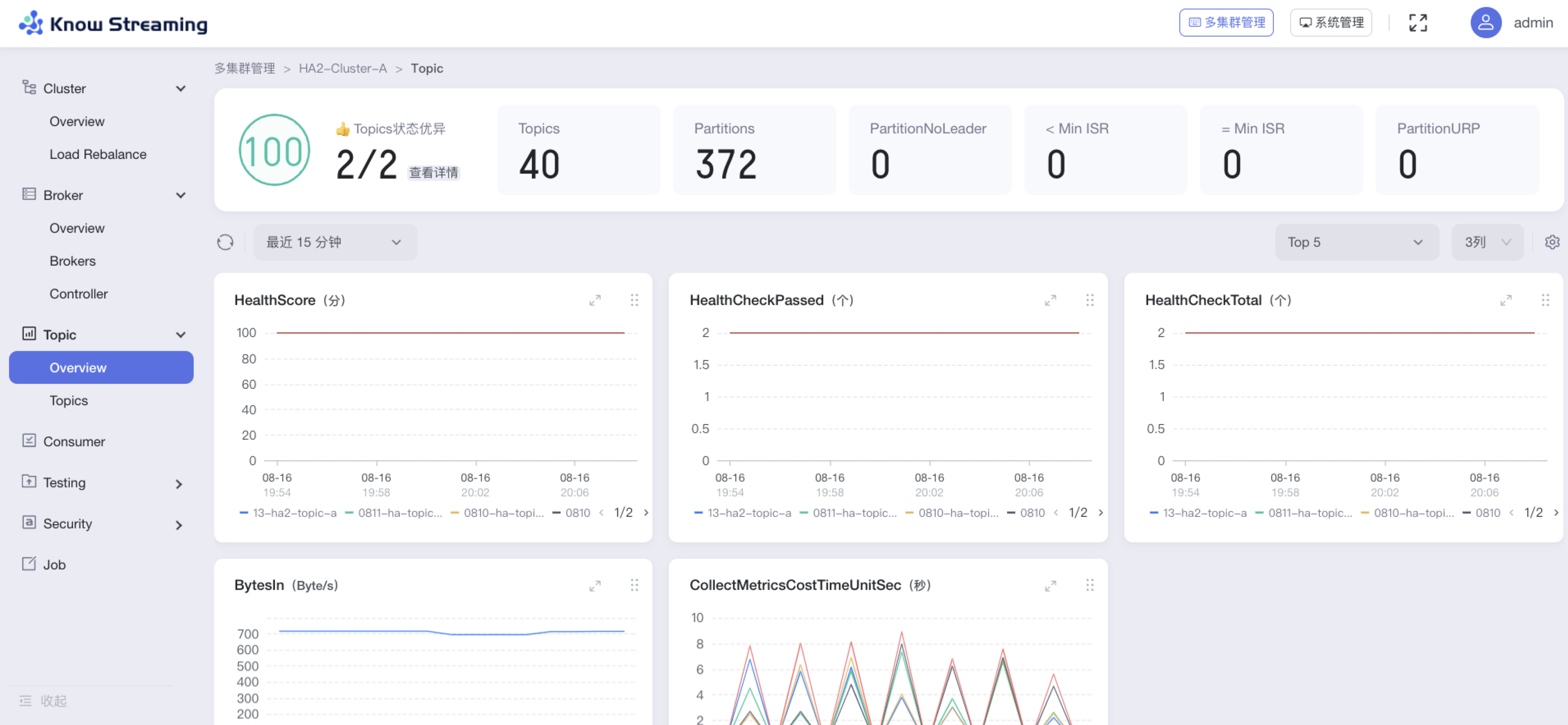

### 3.3.3、Topic 指标

|

||||

|

||||

| 指标名称 | 指标单位 | 指标含义 | kafka 版本 | 企业/开源版指标 |

|

||||

| --------------------- | -------- | ------------------------------------- | ---------- | --------------- |

|

||||

| HealthScore | 分 | 健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed | 个 | 健康项检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal | 个 | 健康项检查总数 | 全部版本 | 开源版 |

|

||||

| TotalProduceRequests | 条/s | Topic 的 TotalProduceRequests | 全部版本 | 开源版 |

|

||||

| BytesRejected | 个/s | Topic 的每秒写入拒绝量 | 全部版本 | 开源版 |

|

||||

| FailedFetchRequests | 个/s | Topic 的 FailedFetchRequests | 全部版本 | 开源版 |

|

||||

| FailedProduceRequests | 个/s | Topic 的 FailedProduceRequests | 全部版本 | 开源版 |

|

||||

| ReplicationCount | 个 | Topic 总的副本数 | 全部版本 | 开源版 |

|

||||

| Messages | 条 | Topic 总的消息数 | 全部版本 | 开源版 |

|

||||

| MessagesIn | 条/s | Topic 每秒消息条数 | 全部版本 | 开源版 |

|

||||

| BytesIn | byte/s | Topic 每秒消息写入字节数 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_5 | byte/s | Topic 每秒消息写入字节数,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesIn_min_15 | byte/s | Topic 每秒消息写入字节数,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut | byte/s | Topic 每秒消息流出字节数 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_5 | byte/s | Topic 每秒消息流出字节数,5 分钟均值 | 全部版本 | 开源版 |

|

||||

| BytesOut_min_15 | byte/s | Topic 每秒消息流出字节数,15 分钟均值 | 全部版本 | 开源版 |

|

||||

| LogSize | byte | Topic 的大小 | 全部版本 | 开源版 |

|

||||

| PartitionURP | 个 | Topic 未同步的副本数 | 全部版本 | 开源版 |

|

||||

|

||||

### 3.3.4、Partition 指标

|

||||

|

||||

| 指标名称 | 指标单位 | 指标含义 | kafka 版本 | 企业/开源版指标 |

|

||||

| -------------- | -------- | ----------------------------------------- | ---------- | --------------- |

|

||||

| LogEndOffset | 条 | Partition 中 leader 副本的 LogEndOffset | 全部版本 | 开源版 |

|

||||

| LogStartOffset | 条 | Partition 中 leader 副本的 LogStartOffset | 全部版本 | 开源版 |

|

||||

| Messages | 条 | Partition 总的消息数 | 全部版本 | 开源版 |

|

||||

| BytesIn | byte/s | Partition 的每秒消息流入字节数 | 全部版本 | 开源版 |

|

||||

| BytesOut | byte/s | Partition 的每秒消息流出字节数 | 全部版本 | 开源版 |

|

||||

| LogSize | byte | Partition 的大小 | 全部版本 | 开源版 |

|

||||

|

||||

### 3.3.5、Group 指标

|

||||

|

||||

| 指标名称 | 指标单位 | 指标含义 | kafka 版本 | 企业/开源版指标 |

|

||||

| ----------------- | -------- | -------------------------- | ---------- | --------------- |

|

||||

| HealthScore | 分 | 健康分 | 全部版本 | 开源版 |

|

||||

| HealthCheckPassed | 个 | 健康检查通过数 | 全部版本 | 开源版 |

|

||||

| HealthCheckTotal | 个 | 健康检查总数 | 全部版本 | 开源版 |

|

||||

| OffsetConsumed | 条 | Consumer 的 CommitedOffset | 全部版本 | 开源版 |

|

||||

| LogEndOffset | 条 | Consumer 的 LogEndOffset | 全部版本 | 开源版 |

|

||||

| Lag | 条 | Group 消费者的 Lag 数 | 全部版本 | 开源版 |

|

||||

| State | 个 | Group 组的状态 | 全部版本 | 开源版 |

|

||||

50

product/4-unique-feature.md

Normal file

50

product/4-unique-feature.md

Normal file

@@ -0,0 +1,50 @@

|

||||

---

|

||||

order: 4

|

||||

title: '4.特色能力'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

## 4.1、集群诊断(敬请期待)

|

||||

|

||||

## 4.2、Kafka 多版本兼容方案

|

||||

|

||||

当前 KnowStreaming 支持纳管多个版本的 kafka 集群,由于不同版本的 kafka 在指标采集、接口查询、行为操作上有些不一致,因此 KnowStreaming 需要一套机制来解决多 kafka 版本的纳管兼容性问题。

|

||||

|

||||

### 4.2.1、整体思路

|

||||

|

||||

由于需要纳管多个 kafka 版本,而且未来还可能会纳管非 kafka 官方的版本,kafka 的版本号会存在着多种情况,所以首先要明确一个核心思想:KnowStreaming 提供尽可能多的纳管能力,但是不提供无限的纳管能力,每一个版本的 KnowStreaming 只纳管其自身声明的 kafka 版本,后续随着 KnowStreaming 自身版本的迭代,会逐步支持更多 kafka 版本的纳管接入。

|

||||

|

||||

### 4.2.2、构建版本兼容列表

|

||||

|

||||

每一个版本的 KnowStreaming 都声明一个自身支持纳管的 kafka 版本列表,并且对 kafka 的版本号进行归一化处理,后续所有 KnowStreaming 对不同 kafka 集群的操作都和这个集群对应的版本号严格相关。

|

||||

|

||||

KnowStreaming 对外提供自身所支持的 kafka 版本兼容列表,用以声明自身支持的版本范围。

|

||||

|

||||

对于在集群接入过程中,如果希望接入当前 KnowStreaming 不支持的 kafka 版本的集群,KnowStreaming 建议在于的过程中选择相近的版本号接入。

|

||||

|

||||

### 4.2.3、构建版本兼容性字典

|

||||

|

||||

在构建了 KnowStreaming 支持的 kafka 版本列表的基础上,KnowStreaming 在实现过程中,还会声明自身支持的所有兼容性,构建兼容性字典。

|

||||

|

||||

当前 KnowStreaming 支持的 kafka 版本兼容性字典包括三个维度:

|

||||

|

||||

- 指标采集:同一个指标在不同 kafka 版本下可能获取的方式不一样,不同版本的 kafka 可能会有不同的指标,因此对于指标采集的处理需要构建兼容性字典。

|

||||

- kafka api:同一个 kafka 的操作处理的方式在不同 kafka 版本下可能存在不一致,如:topic 的创建,因此 KnowStreaming 针对不同 kafka-api 的处理需要构建兼容性字典。

|

||||

- 平台操作:KnowStreaming 在接入不同版本的 kafka 集群的时候,在平台页面上会根据不同的 kafka 版。

|

||||

|

||||

兼容性字典的核心设计字段如下:

|

||||

|

||||

| 兼容性维度 | 兼容项名称 | 最小 Kafka 版本号(归一化) | 最大 Kafka 版本号(归一化) | 处理器 |

|

||||

| ---------- | ---------- | --------------------------- | --------------------------- | ------ |

|

||||

|

||||

KS-KM 根据其需要纳管的 kafka 版本,按照上述三个维度构建了完善了兼容性字典。

|

||||

|

||||

### 4.2.4、兼容性问题

|

||||

|

||||

KS-KM 的每个版本针对需要纳管的 kafka 版本列表,事先分析各个版本的差异性和产品需求,同时 KS-KM 构建了一套专门处理兼容性的服务,来进行兼容性的注册、字典构建、处理器分发等操作,其中版本兼容性处理器是来具体处理不同 kafka 版本差异性的地方。

|

||||

|

||||

|

||||

|

||||

如上图所示,KS-KM 的 topic 服务在面对不同 kafka 版本时,其 topic 的创建、删除、扩容由于 kafka 版本自身的差异,导致 KnowStreaming 的处理也不一样,所以需要根据不同的 kafka 版本来实现不同的兼容性处理器,同时向 KnowStreaming 的兼容服务进行兼容性的注册,构建兼容性字典,后续在 KnowStreaming 的运行过程中,针对不同的 kafka 版本即可分发到不同的处理器中执行。

|

||||

|

||||

后续随着 KnowStreaming 产品的发展,如果有新的兼容性的地方需要增加,只需要实现新版本的处理器,增加注册项即可。

|

||||

884

product/5-user-doc.md

Normal file

884

product/5-user-doc.md

Normal file

@@ -0,0 +1,884 @@

|

||||

---

|

||||

order: 5

|

||||

title: '5.用户手册'

|

||||

toc: menu

|

||||

---

|

||||

|

||||

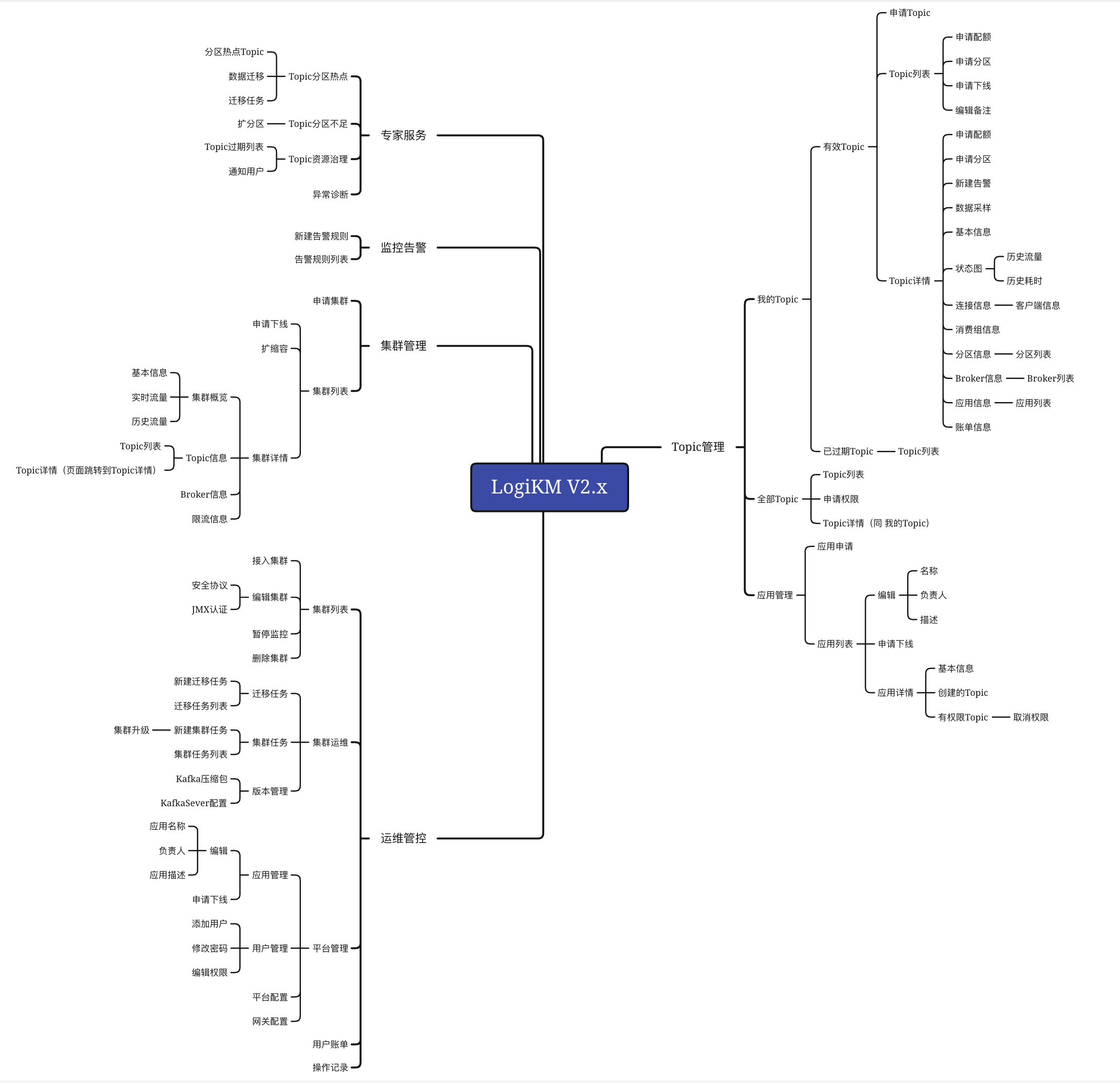

## 5.1、功能架构

|

||||

|

||||

|

||||

|

||||

## 5.2、体验路径

|

||||

|

||||

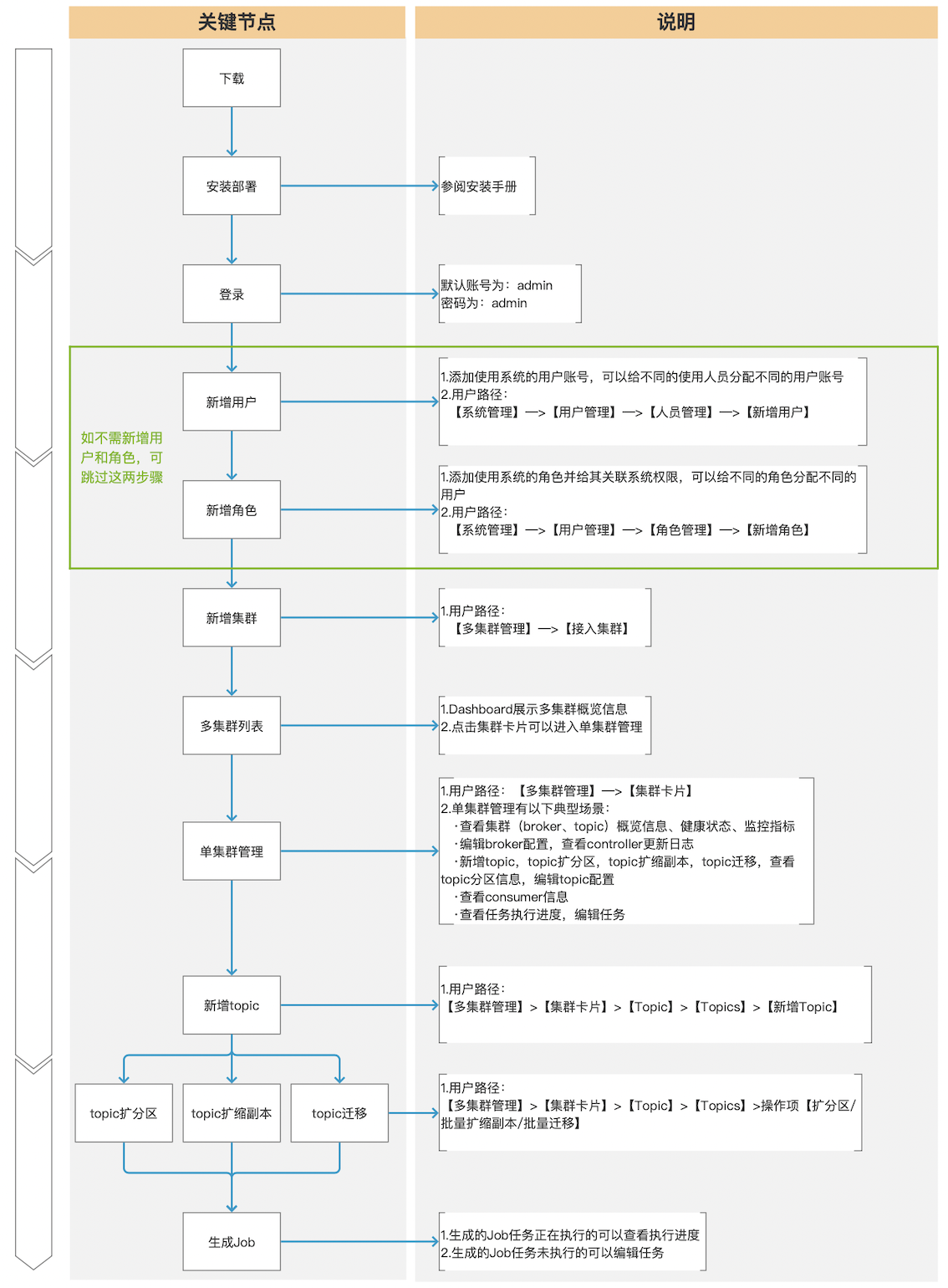

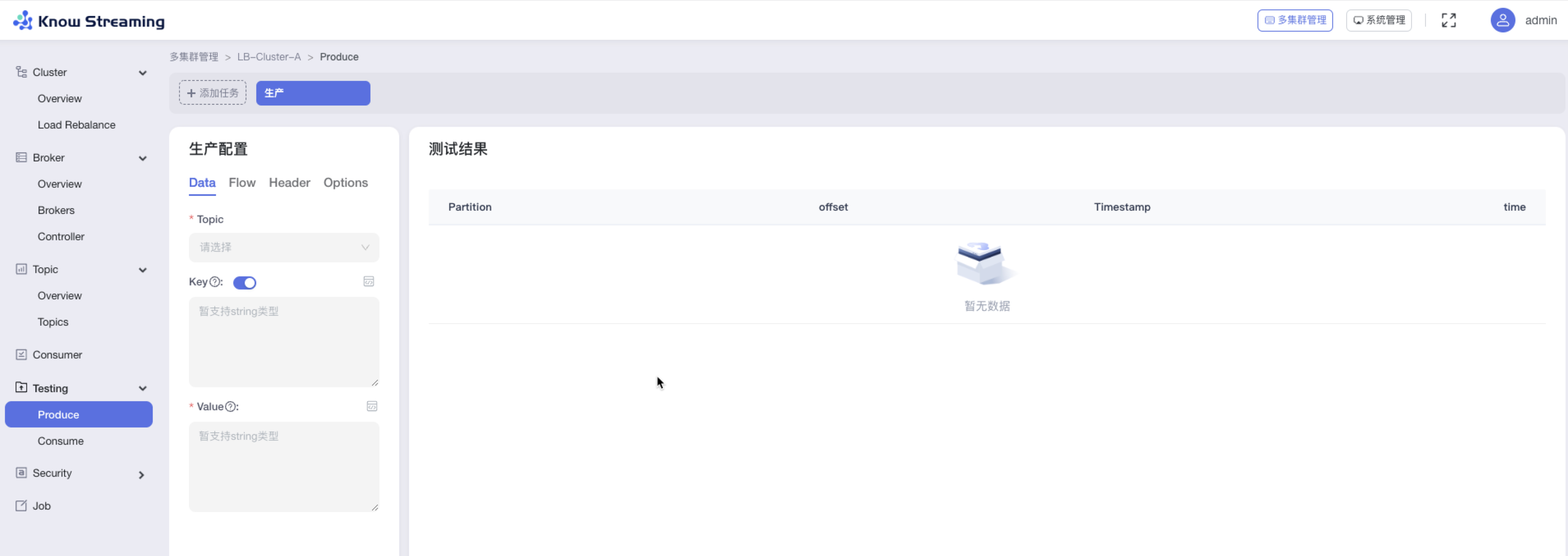

下面是用户第一次使用我们产品的典型体验路径:

|

||||

|

||||

|

||||

|

||||

## 5.3、常用功能

|

||||

|

||||

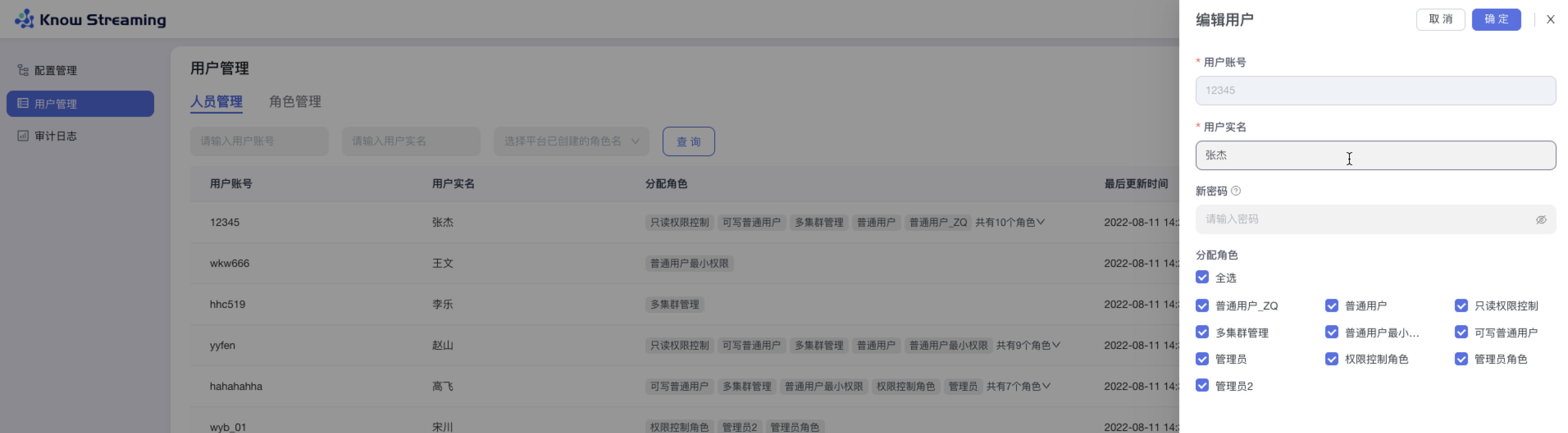

### 5.3.1、用户管理

|

||||

|

||||

用户管理是提供给管理员进行人员管理和用户角色管理的功能模块,可以进行新增用户和分配角色。下面是一个典型的场景:

|

||||

eg:团队加入了新成员,需要给这位成员分配一个使用系统的账号,需要以下几个步骤

|

||||

|

||||

- 步骤 1:点击“系统管理”>“用户管理”>“人员管理”>“新增用户”,输入“账号”、“实名”、“密码”,根据此账号所需要的权限,选择此账号所对应的角色。如果有满足权限的角色,则用户新增成功。如果没有满足权限的角色,则需要新增角色(步骤 2)

|

||||

- 步骤 2:点击“系统管理”>“用户管理”>“角色管理”>“新增角色”。输入角色名称和描述,给此角色分配权限,点击“确定”,角色新增成功

|

||||

|

||||

- 步骤 3:根据此新增的角色,参考步骤 1,重新新增用户

|

||||

|

||||

- 步骤 4:此用户账号新增成功,可以进行登录产品使用

|

||||

|

||||

|

||||

|

||||

### 5.3.2、接入集群

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“接入集群”

|

||||

|

||||

- 步骤 2:填写相关集群信息

|

||||

|

||||

- 集群名称:支持中英文、下划线、短划线(-),最长 128 字符。平台内不能重复

|

||||

- Bootstrap Servers:输入 Bootstrap Servers 地址。输入完成之后会进行连接测试,测试完成之后会给出测试结果连接成功 or 连接失败(以及失败的原因)。

|

||||

- Zookeeper:输入 zookeeper 地址,输入完成之后会进行连接测试,测试完成之后会给出测试结果连接成功 or 连接失败(以及失败的原因)

|

||||

- Metrics 选填:JMX Port,输入 JMX 端口号;MaxConn,输入服务端最大允许的连接数

|

||||

- Security:若有 JMX 账号密码,则输入账号密码

|

||||

- Version:选择所支持的 kafka 版本,如果没有匹配则可以选择相近版本

|

||||

- 集群配置选填:输入用户创建 kafka 客户端进行信息获取的相关配置

|

||||

- 集群描述:最多 200 字符

|

||||

|

||||

|

||||

|

||||

### 5.3.3、新增 Topic

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“新增 Topic”按钮>“创建 Topic“抽屉

|

||||

|

||||

- 步骤 2:输入“Topic 名称(不能重复)”、“Topic 描述”、“分区数”、“副本数”、“数据保存时间”、“清理策略(删除或压缩)”

|

||||

|

||||

- 步骤 3:展开“更多配置”可以打开高级配置选项,根据自己需要输入相应配置参数

|

||||

|

||||

- 步骤 4:点击“确定”,创建 Topic 完成

|

||||

|

||||

|

||||

|

||||

### 5.3.4、Topic 扩分区

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“Topic 列表“>操作项”扩分区“>“扩分区”抽屉

|

||||

|

||||

- 步骤 2:扩分区抽屉展示内容为“流量的趋势图”、“当前分区数及支持的最低消息写入速率”、“扩分区后支持的最低消息写入速率”

|

||||

|

||||

- 步骤 3:输入所需的分区总数,自动计算出扩分区后支持的最低消息写入速率

|

||||

|

||||

- 步骤 4:点击确定,扩分区完成

|

||||

|

||||

|

||||

|

||||

### 5.3.5、Topic 批量扩缩副本

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“批量操作下拉“>“批量扩缩副本“>“批量扩缩容”抽屉

|

||||

|

||||

- 步骤 2:选择所需要进行扩缩容的 Topic,可多选,所选择的 Topic 出现在下方 Topic 列表中

|

||||

|

||||

- 步骤 3:Topic 列表展示 Topic“近三天平均流量”、“近三天峰值流量及时间”、“Partition 数”、”当前副本数“、“新副本数”

|

||||

|

||||

- 步骤 4:扩容时,选择目标节点,新增的副本会在选择的目标节点上;缩容时不需要选择目标节点,自动删除最后一个(或几个)副本

|

||||

|

||||

- 步骤 5:输入迁移任务配置参数,包含限流值和任务执行时间

|

||||

|

||||

- 步骤 6:输入任务描述

|

||||

|

||||

- 步骤 7:点击“确定”,创建 Topic 扩缩副本任务

|

||||

|

||||

- 步骤 8:去“Job”模块的 Job 列表查看创建的任务,如果已经执行则可以查看执行进度;如果未开始执行则可以编辑任务

|

||||

|

||||

|

||||

|

||||

### 5.3.6、Topic 批量迁移

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Topic”>“Topics”>“批量操作下拉“>“批量迁移“>“批量迁移”抽屉

|

||||

|

||||

- 步骤 2:选择所需要进行迁移的 Topic,可多选,所选择的 Topic 出现在下方 Topic 列表中

|

||||

|

||||

- 步骤 3:选择所需要迁移的 partition 和迁移数据的时间范围

|

||||

|

||||

- 步骤 4:选择目标节点(节点数必须不小于最大副本数)

|

||||

|

||||

- 步骤 5:点击“预览任务计划”,打开“任务计划”二次抽屉,可对目标 Broker ID 进行编辑

|

||||

|

||||

- 步骤 6:输入迁移任务配置参数,包含限流值和任务执行时间

|

||||

|

||||

- 步骤 7:输入任务描述

|

||||

|

||||

- 步骤 8:点击“确定”,创建 Topic 迁移任务

|

||||

|

||||

- 步骤 9:去“Job”模块的 Job 列表查看创建的任务,如果已经执行则可以查看执行进度;如果未开始执行则可以编辑任务

|

||||

|

||||

|

||||

|

||||

### 5.3.7、设置 Cluster 健康检查规则

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Cluster”>“Overview”>“集群健康状态旁边 icon”>“健康度设置抽屉”

|

||||

|

||||

- 步骤 2:健康度设置抽屉展示出了检查项和其对应的权重,可以修改检查项的检查规则

|

||||

|

||||

- 步骤 3:检查规则可配置,分别为

|

||||

|

||||

- Cluster:集群 controller 数不等于 1(数字不可配置)不通过

|

||||

- Broker:RequestQueueSize 大于等于 10(默认为 10,可配置数字)不通过

|

||||

- Broker:NetworkProcessorAvgIdlePercent 的 Idle 小于等于 0.8%(默认为 0.8%,可配置数字)不通过

|

||||

- Topic:无 leader 的 Topic 数量,大于等于 1(默认为 1,数字可配置)不通过

|

||||

- Topic:Topic 在 10(默认为 10,数字可配置)个周期内 8(默认为 8,数字可配置)个周期内处于未同步的状态则不通过

|

||||

- ConsumerGroup:Group 在 10(默认为 10,数字可配置)个周期内进行 8(默认为 8,数字可配置)次 re-balance 不通过

|

||||

|

||||

- 步骤 4:设置完成后,点击“确认”,健康检查规则设置成功

|

||||

|

||||

|

||||

|

||||

### 5.3.8、图表指标筛选

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Cluster”>“Overview”>“指标筛选 icon”>“指标筛选抽屉”

|

||||

|

||||

- 步骤 2:指标筛选抽屉展示信息为以下几类“Health”、“Cluster”、“Broker”、“Consumer”、“Security”、“Job”

|

||||

|

||||

- 步骤 3:默认勾选比较重要的指标进行展示。根据需要选中/取消选中相应指标,点击”确认“,指标筛选成功,展示的图表随之变化

|

||||

|

||||

|

||||

|

||||

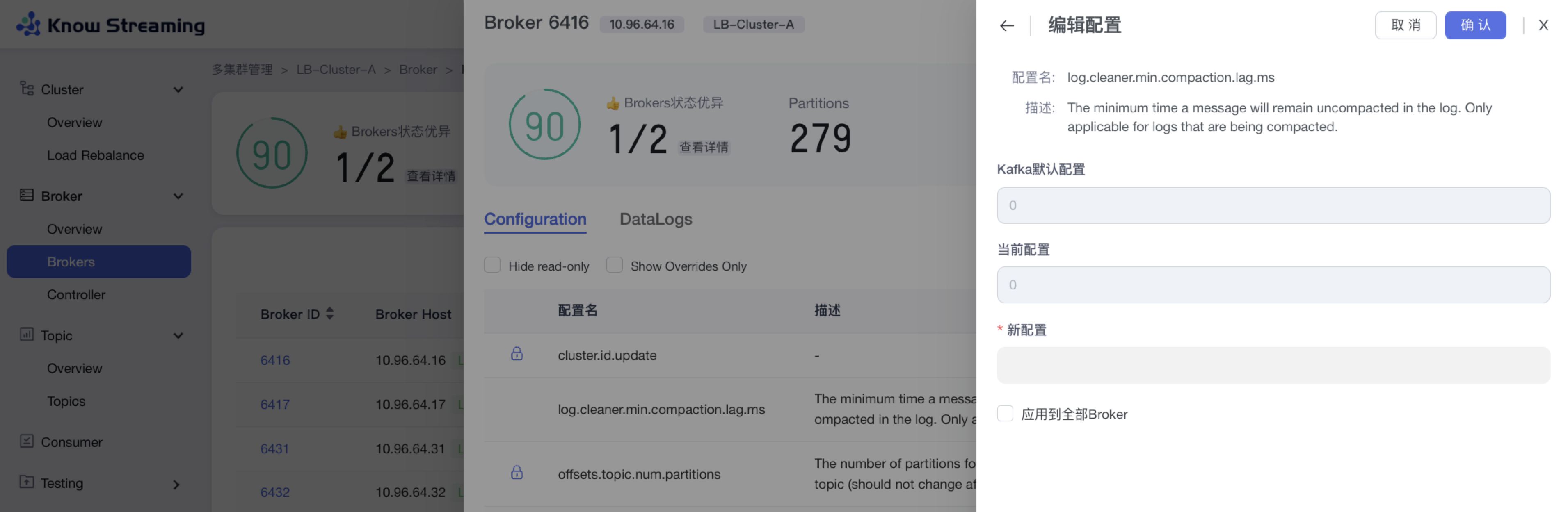

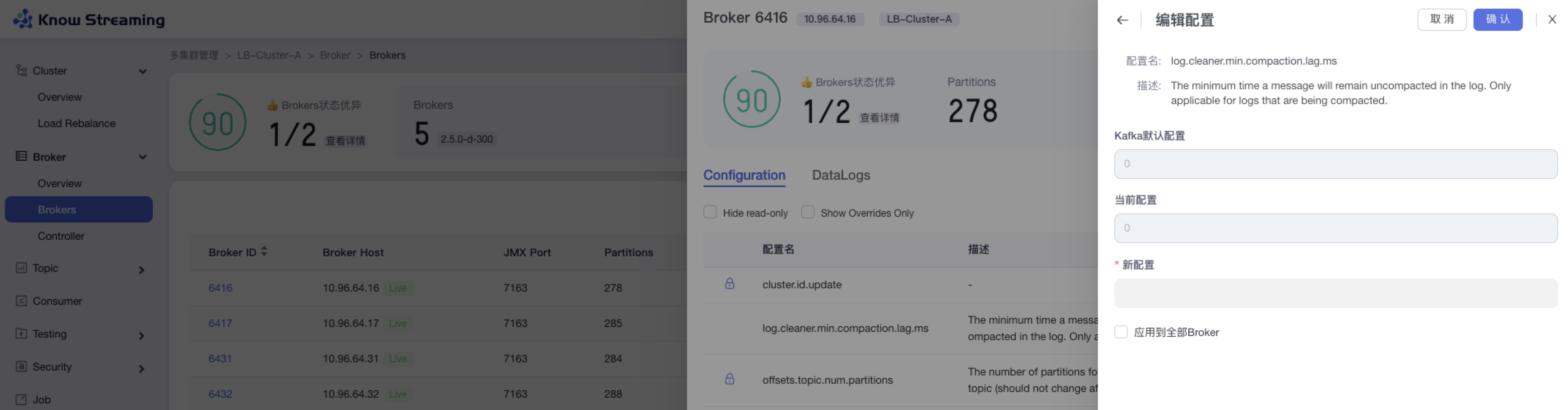

### 5.3.9、编辑 Broker 配置

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Brokers”>“Broker ID”>“Configuration”TAB>“编辑”按钮

|

||||

|

||||

- 步骤 2:输入配置项的新配置内容

|

||||

|

||||

- 步骤 3:(选填)点击“应用于全部 Broker”,将此配置项的修改应用于全部的 Broker

|

||||

|

||||

- 步骤 4:点击“确认”,Broker 配置修改成功

|

||||

|

||||

|

||||

|

||||

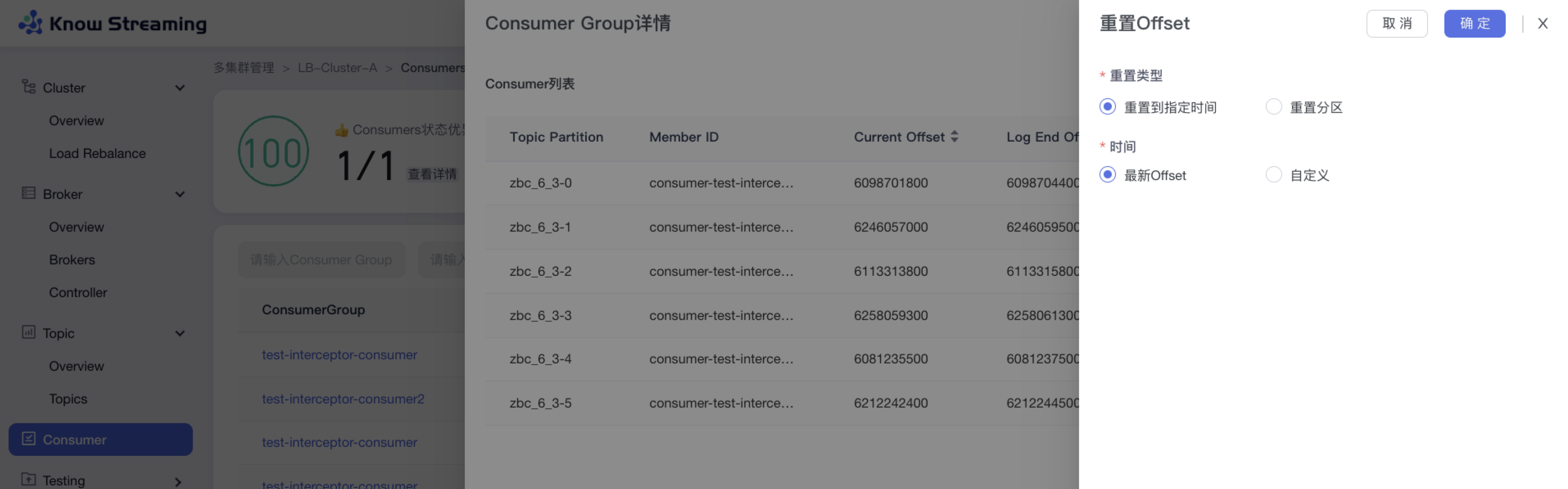

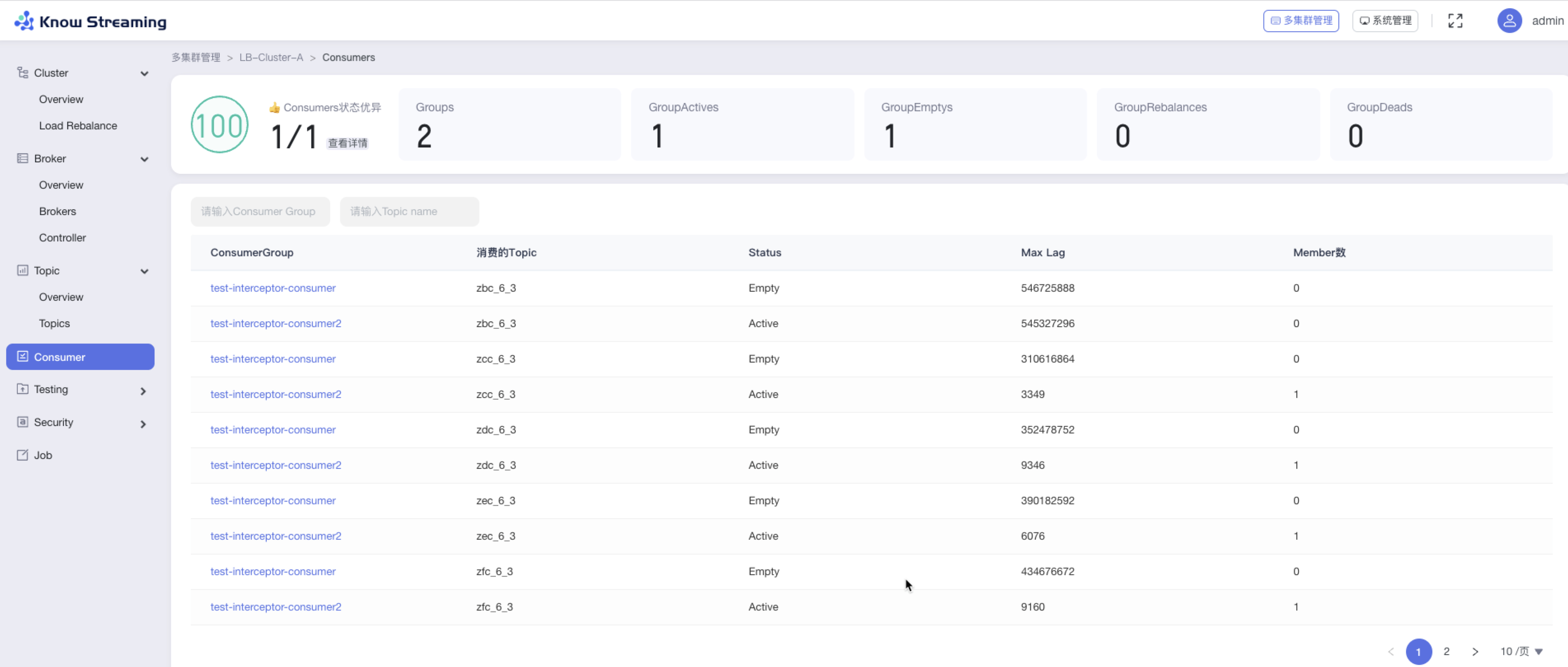

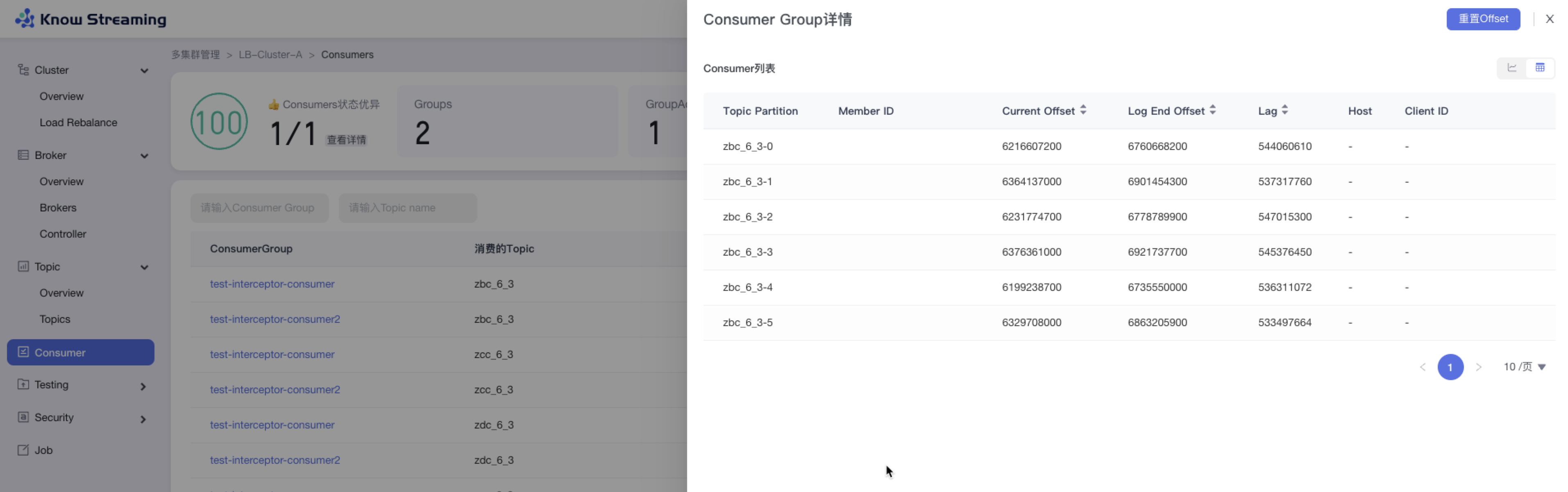

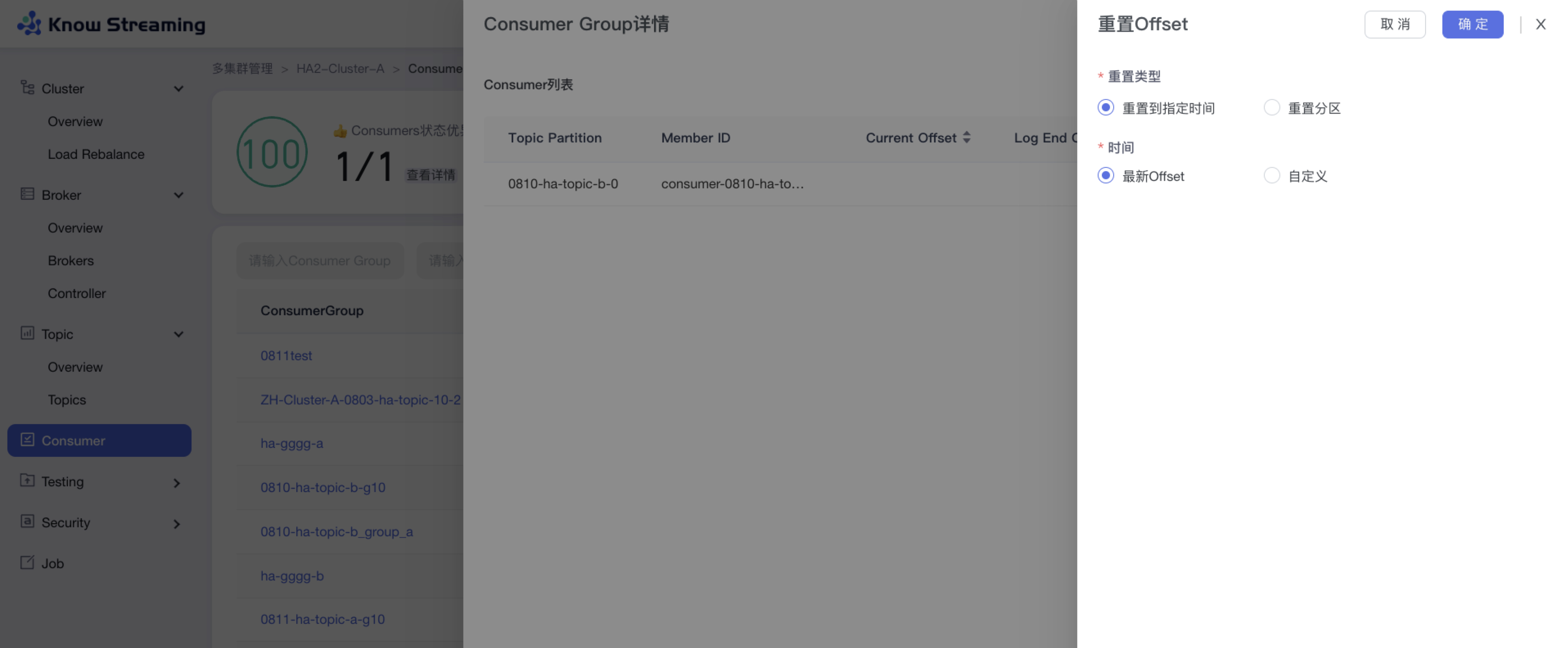

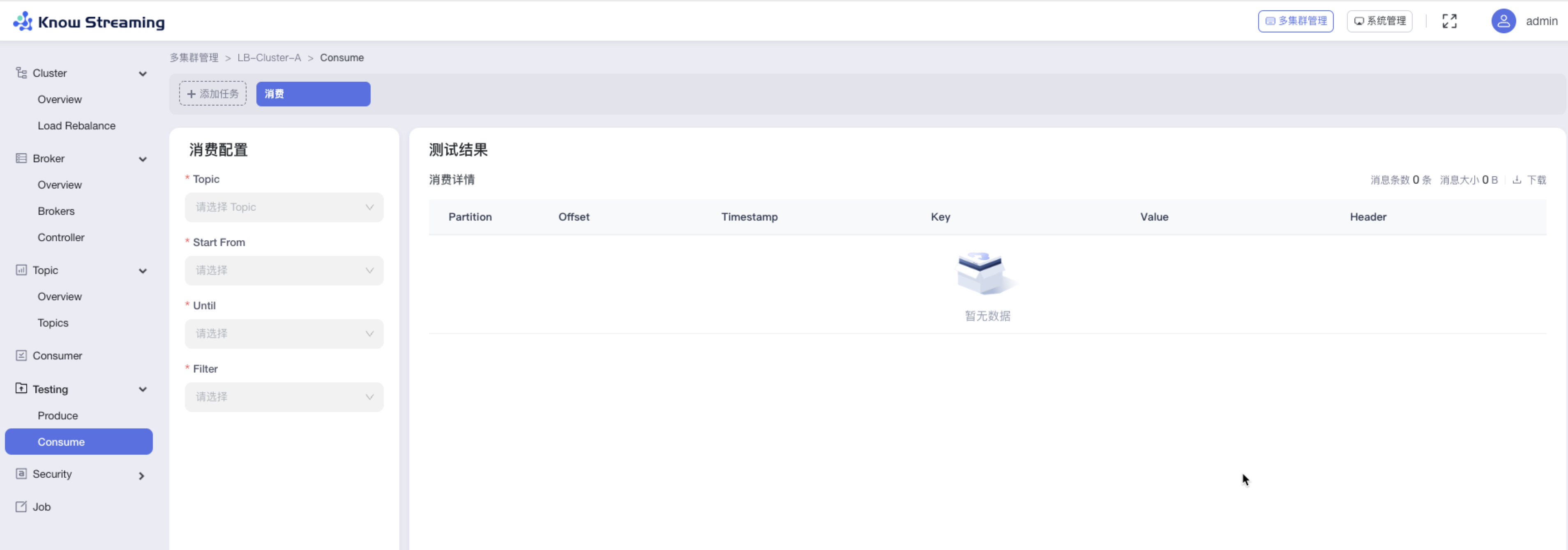

### 5.3.10、重置 consumer Offset

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Consumer”>“Consumer Group”名称>“Consumer Group 详情”抽屉>“重置 Offset”按钮>“重置 Offset”抽屉

|

||||

|

||||

- 步骤 2:选择重置 Offset 的类型,可“重置到指定时间”或“重置分区”

|

||||

|

||||

- 步骤 3:重置到指定时间,可选择“最新 Offset”或“自定义时间”

|

||||

|

||||

- 步骤 4:重置分区,可选择 partition 和其重置的 offset

|

||||

|

||||

- 步骤 5:点击“确认”,重置 Offset 开始执行

|

||||

|

||||

|

||||

|

||||

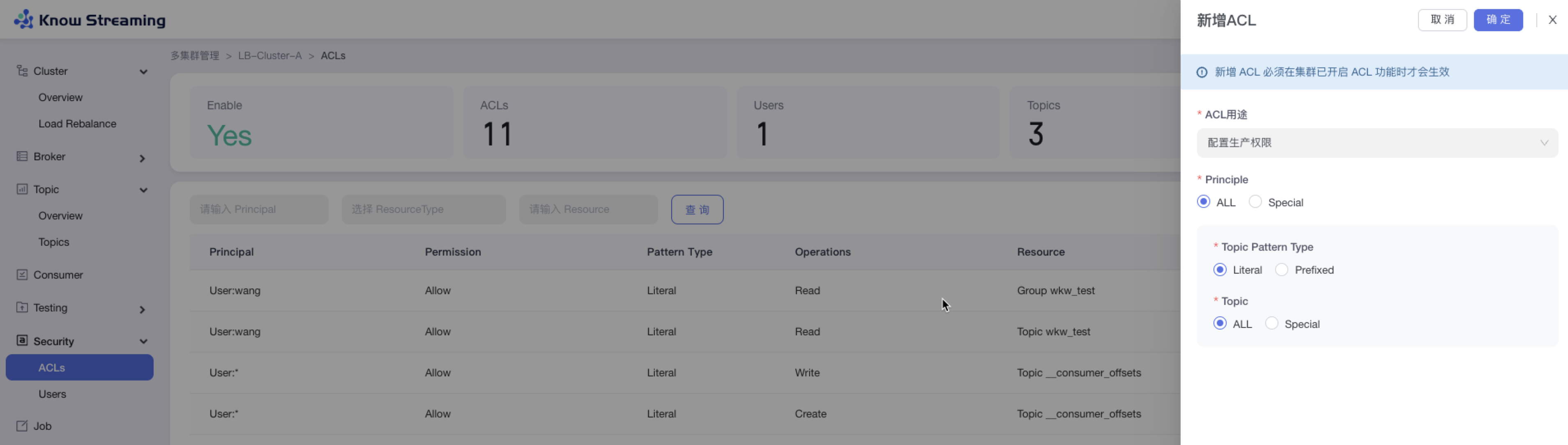

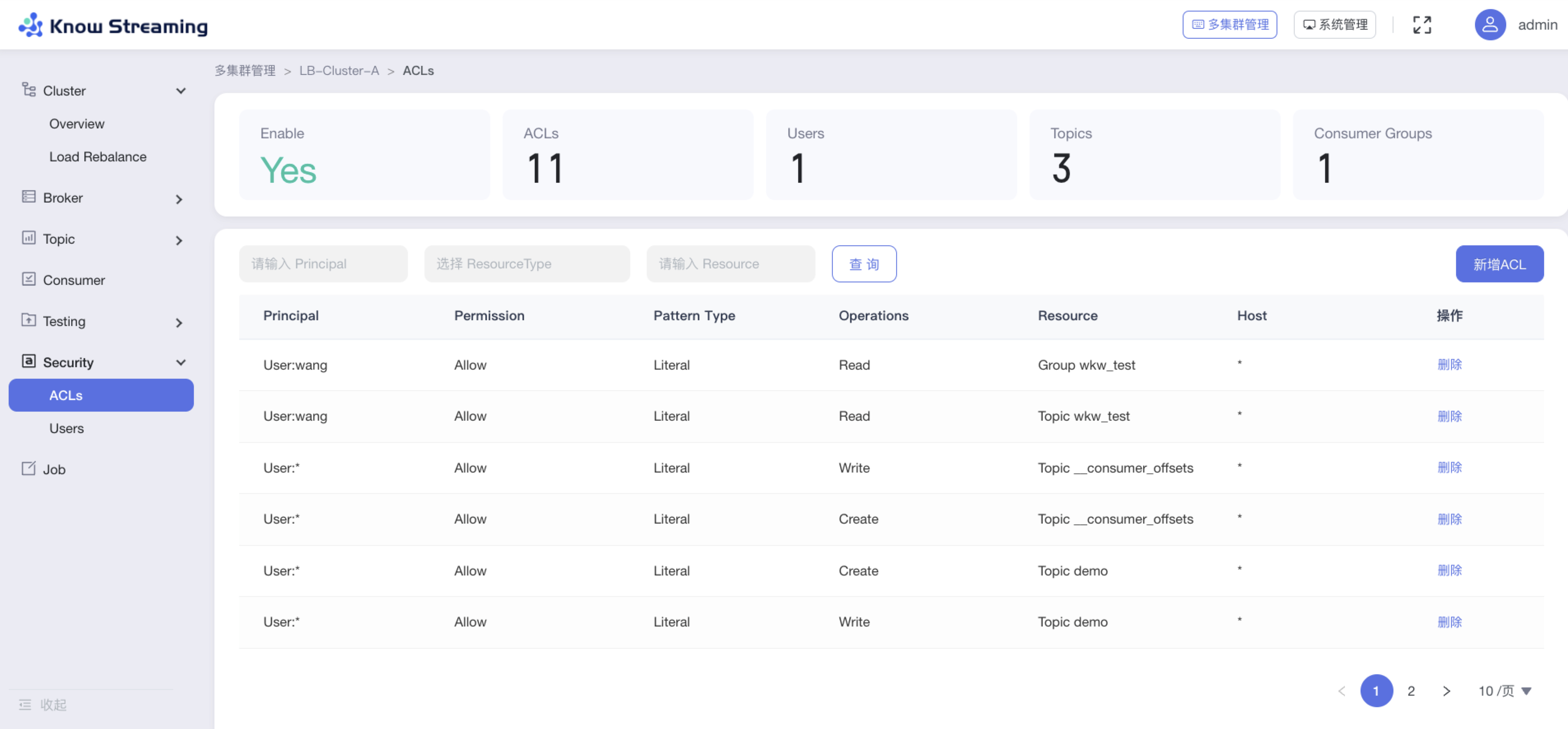

### 5.3.11、新增 ACL

|

||||

|

||||

- 步骤 1:点击“多集群管理”>“集群卡片”>“Security”>“Users”>“新增 ACL”

|

||||

|

||||

- 步骤 2:输入 ACL 配置参数

|

||||

|

||||

- ACL 用途:生产权限、消费权限、自定义权限

|

||||