Compare commits

455 Commits

| Author | SHA1 | Date | |

|---|---|---|---|

|

|

c56d8cfb0f | ||

|

|

c27786a257 | ||

|

|

81910d1958 | ||

|

|

55d5fc4bde | ||

|

|

f30586b150 | ||

|

|

37037c19f0 | ||

|

|

1a5e2c7309 | ||

|

|

941dd4fd65 | ||

|

|

5f6df3681c | ||

|

|

7d045dbf05 | ||

|

|

4ff4accdc3 | ||

|

|

bbe967c4a8 | ||

|

|

b101cec6fa | ||

|

|

e98ec562a2 | ||

|

|

0e71ecc587 | ||

|

|

0f11a65df8 | ||

|

|

da00c8c877 | ||

|

|

8b177877bb | ||

|

|

ea199dca8d | ||

|

|

88b5833f77 | ||

|

|

127b5be651 | ||

|

|

80f001cdd5 | ||

|

|

30d297cae1 | ||

|

|

a96853db90 | ||

|

|

c1502152c0 | ||

|

|

afda292796 | ||

|

|

163cab78ae | ||

|

|

8f4ff36c09 | ||

|

|

47b6b3577a | ||

|

|

f3eca3b214 | ||

|

|

62f7d3f72f | ||

|

|

26e60d8a64 | ||

|

|

df655a250c | ||

|

|

811fc9b400 | ||

|

|

83df02783c | ||

|

|

6a5efce874 | ||

|

|

fa0ae5e474 | ||

|

|

cafd665a2d | ||

|

|

e8f77a456b | ||

|

|

4510c62ebd | ||

|

|

79864955e1 | ||

|

|

ff26a8d46c | ||

|

|

cc226d552e | ||

|

|

962f89475b | ||

|

|

ec204a1605 | ||

|

|

58d7623938 | ||

|

|

8f4ecfcdc0 | ||

|

|

ef719cedbc | ||

|

|

b7856c892b | ||

|

|

7435a78883 | ||

|

|

f49206b316 | ||

|

|

7d500a0721 | ||

|

|

98a519f20b | ||

|

|

39b655bb43 | ||

|

|

78d56a49fe | ||

|

|

d2e9d1fa01 | ||

|

|

41ff914dc3 | ||

|

|

3ba447fac2 | ||

|

|

e9cc380a2e | ||

|

|

017cac9bbe | ||

|

|

9ad72694af | ||

|

|

e8f9821870 | ||

|

|

bb167b9f8d | ||

|

|

28fbb5e130 | ||

|

|

16101e81e8 | ||

|

|

aced504d2a | ||

|

|

abb064d9d1 | ||

|

|

dc1899a1cd | ||

|

|

442f34278c | ||

|

|

a6dcbcd35b | ||

|

|

2b600e96eb | ||

|

|

177bb80f31 | ||

|

|

63fbe728c4 | ||

|

|

b33020840b | ||

|

|

c5caf7c0d6 | ||

|

|

0f0473db4c | ||

|

|

beadde3e06 | ||

|

|

a423a20480 | ||

|

|

79f0a23813 | ||

|

|

780fdea2cc | ||

|

|

1c0fda1adf | ||

|

|

9cf13e9b30 | ||

|

|

87cd058fd8 | ||

|

|

81b1ec48c2 | ||

|

|

66dd82f4fd | ||

|

|

ce35b23911 | ||

|

|

e79342acf5 | ||

|

|

3fc9f39d24 | ||

|

|

0221fb3a4a | ||

|

|

f009f8b7ba | ||

|

|

b76959431a | ||

|

|

975370b593 | ||

|

|

7275030971 | ||

|

|

99b0be5a95 | ||

|

|

edd3f95fc4 | ||

|

|

479f983b09 | ||

|

|

7650332252 | ||

|

|

8f1a021851 | ||

|

|

ce4df4d5fd | ||

|

|

bd43ae1b5d | ||

|

|

8fa34116b9 | ||

|

|

7e92553017 | ||

|

|

b7e243a693 | ||

|

|

35d4888afb | ||

|

|

b3e8a4f0f6 | ||

|

|

321125caee | ||

|

|

e01427aa4f | ||

|

|

14652e7f7a | ||

|

|

7c05899dbd | ||

|

|

56726b703f | ||

|

|

6237b0182f | ||

|

|

be5b662f65 | ||

|

|

224698355c | ||

|

|

8f47138ecd | ||

|

|

d159746391 | ||

|

|

63df93ea5e | ||

|

|

38948c0daa | ||

|

|

6c610427b6 | ||

|

|

b4cc31c459 | ||

|

|

7d781712c9 | ||

|

|

dd61ce9b2a | ||

|

|

69a7212986 | ||

|

|

ff05a951fd | ||

|

|

89d5357b40 | ||

|

|

7ca3d65c42 | ||

|

|

7b5c2d800f | ||

|

|

f414b47a78 | ||

|

|

44f4e2f0f9 | ||

|

|

2361008bdf | ||

|

|

7377ef3ec5 | ||

|

|

a28d064b7a | ||

|

|

e2e57e8575 | ||

|

|

9d90bd2835 | ||

|

|

7445e68df4 | ||

|

|

ab42625ad2 | ||

|

|

18789a0a53 | ||

|

|

68a37bb56a | ||

|

|

3b33652c47 | ||

|

|

1e0c4c3904 | ||

|

|

04e223de16 | ||

|

|

c4a691aa8a | ||

|

|

ff9dde163a | ||

|

|

eb7efbd1a5 | ||

|

|

8c8c362c54 | ||

|

|

66e119ad5d | ||

|

|

6dedc04a05 | ||

|

|

0cf8bad0df | ||

|

|

95c9582d8b | ||

|

|

7815126ff5 | ||

|

|

a5fa9de54b | ||

|

|

95f1a2c630 | ||

|

|

1e256ae1fd | ||

|

|

9fc9c54fa1 | ||

|

|

1b362b1e02 | ||

|

|

04e3172cca | ||

|

|

1caab7f3f7 | ||

|

|

9d33c725ad | ||

|

|

6ed1d38106 | ||

|

|

0f07ddedaf | ||

|

|

289945b471 | ||

|

|

f331a6d144 | ||

|

|

0c8c12a651 | ||

|

|

028c3bb2fa | ||

|

|

d7a5a0d405 | ||

|

|

5ef5f6e531 | ||

|

|

1d205734b3 | ||

|

|

5edd43884f | ||

|

|

c1992373bc | ||

|

|

ed562f9c8a | ||

|

|

b4d44ef8c7 | ||

|

|

ad0c16a1b4 | ||

|

|

7eabe66853 | ||

|

|

3983d73695 | ||

|

|

161d4c4562 | ||

|

|

9a1e89564e | ||

|

|

0c18c5b4f6 | ||

|

|

3e12ba34f7 | ||

|

|

e71e29391b | ||

|

|

9b7b9a7af0 | ||

|

|

a23819c308 | ||

|

|

6cb1825d96 | ||

|

|

77b8c758dc | ||

|

|

e5a582cfad | ||

|

|

ec83db267e | ||

|

|

bfd026cae7 | ||

|

|

35f1dd8082 | ||

|

|

7ed0e7dd23 | ||

|

|

1a3cbf7a9d | ||

|

|

d9e4abc3de | ||

|

|

a4186085d3 | ||

|

|

26b1846bb4 | ||

|

|

1aa89527a6 | ||

|

|

eac76d7ad0 | ||

|

|

cea0cd56f6 | ||

|

|

c4b897f282 | ||

|

|

47389dbabb | ||

|

|

a2f8b1a851 | ||

|

|

feac0a058f | ||

|

|

27eeac9fd4 | ||

|

|

a14db4b194 | ||

|

|

54ee271a47 | ||

|

|

a3a9be4f7f | ||

|

|

d4f0a832f3 | ||

|

|

7dc533372c | ||

|

|

1737d87713 | ||

|

|

dbb98dea11 | ||

|

|

802b382b36 | ||

|

|

fc82999d45 | ||

|

|

08aa000c07 | ||

|

|

39015b5100 | ||

|

|

0d635ad419 | ||

|

|

9133205915 | ||

|

|

725ac10c3d | ||

|

|

2b76358c8f | ||

|

|

833c360698 | ||

|

|

7da1e67b01 | ||

|

|

7eb86a47dd | ||

|

|

d67e383c28 | ||

|

|

8749d3e1f5 | ||

|

|

30fba21c48 | ||

|

|

d83d35aee9 | ||

|

|

1d3caeea7d | ||

|

|

c8806dbb4d | ||

|

|

e5802c7f50 | ||

|

|

590f684d66 | ||

|

|

8e5a67f565 | ||

|

|

8d2fbce11e | ||

|

|

26916f6632 | ||

|

|

fbfa0d2d2a | ||

|

|

e626b99090 | ||

|

|

203859b71b | ||

|

|

9a25c22f3a | ||

|

|

0a03f41a7c | ||

|

|

56191939c8 | ||

|

|

beb754aaaa | ||

|

|

f234f740ca | ||

|

|

e14679694c | ||

|

|

e06712397e | ||

|

|

b6c6df7ffc | ||

|

|

375c6f56c9 | ||

|

|

0bf85c97b5 | ||

|

|

630e582321 | ||

|

|

a89fe23bdd | ||

|

|

a7a5fa9a31 | ||

|

|

c73a7eee2f | ||

|

|

121f8468d5 | ||

|

|

7b0b6936e0 | ||

|

|

597ea04a96 | ||

|

|

f7f90aeaaa | ||

|

|

227479f695 | ||

|

|

6477fb3fe0 | ||

|

|

4223f4f3c4 | ||

|

|

7288874d72 | ||

|

|

68f76f2daf | ||

|

|

fe6ddebc49 | ||

|

|

12b5acd073 | ||

|

|

a6f1fe07b3 | ||

|

|

85e3f2a946 | ||

|

|

d4f416de14 | ||

|

|

0d9a6702c1 | ||

|

|

d11285cdbf | ||

|

|

5f1f33d2b9 | ||

|

|

474daf752d | ||

|

|

27d1b92690 | ||

|

|

993afa4c19 | ||

|

|

028d891c32 | ||

|

|

0df55ec22d | ||

|

|

579f64774d | ||

|

|

792f8d939d | ||

|

|

e4fb02fcda | ||

|

|

0c14c641d0 | ||

|

|

dba671fd1e | ||

|

|

80d1693722 | ||

|

|

26014a11b2 | ||

|

|

848fddd55a | ||

|

|

97f5f05f1a | ||

|

|

25b82810f2 | ||

|

|

9b1e506fa7 | ||

|

|

7a42996e97 | ||

|

|

dbfcebcf67 | ||

|

|

37c3f69a28 | ||

|

|

5d412890b4 | ||

|

|

1e318a4c40 | ||

|

|

d4549176ec | ||

|

|

61efdf492f | ||

|

|

67ea4d44c8 | ||

|

|

fdae05a4aa | ||

|

|

5efb837ee8 | ||

|

|

584b626d93 | ||

|

|

de25a4ed8e | ||

|

|

2e852e5ca6 | ||

|

|

b11000715a | ||

|

|

b3f8b46f0f | ||

|

|

8d22a0664a | ||

|

|

20756a3453 | ||

|

|

c9b4d45a64 | ||

|

|

83f7f5468b | ||

|

|

59c042ad67 | ||

|

|

d550fc5068 | ||

|

|

6effba69a0 | ||

|

|

9b46956259 | ||

|

|

b5a4a732da | ||

|

|

487862367e | ||

|

|

5b63b9ce67 | ||

|

|

afbcd3e1df | ||

|

|

12b82c1395 | ||

|

|

863b765e0d | ||

|

|

731429c51c | ||

|

|

66f3bc61fe | ||

|

|

4efe35dd51 | ||

|

|

c92461ef93 | ||

|

|

405e6e0c1d | ||

|

|

0d227aef49 | ||

|

|

0e49002f42 | ||

|

|

2e016800e0 | ||

|

|

09f317b991 | ||

|

|

5a48cb1547 | ||

|

|

f632febf33 | ||

|

|

3c53467943 | ||

|

|

d358c0f4f7 | ||

|

|

de977a5b32 | ||

|

|

703d685d59 | ||

|

|

31a5f17408 | ||

|

|

c40ae3c455 | ||

|

|

b71a34279e | ||

|

|

8f8c0c4eda | ||

|

|

3a384f0e34 | ||

|

|

cf7bc11cbd | ||

|

|

be60ae8399 | ||

|

|

8e50d145d5 | ||

|

|

7a3d15525c | ||

|

|

64f32d8b24 | ||

|

|

949d6ba605 | ||

|

|

ceb8db09f4 | ||

|

|

ed05a0ebb8 | ||

|

|

a7cbb76655 | ||

|

|

93cbfa0b1f | ||

|

|

6120613a98 | ||

|

|

dbd00db159 | ||

|

|

befde952f5 | ||

|

|

1aa759e5be | ||

|

|

2de27719c1 | ||

|

|

21db57b537 | ||

|

|

dfe8d09477 | ||

|

|

90dfa22c64 | ||

|

|

0f35427645 | ||

|

|

7909f60ff8 | ||

|

|

9a1a8a4c30 | ||

|

|

fa7ad64140 | ||

|

|

8a0c23339d | ||

|

|

e7ab3aff16 | ||

|

|

d0948797b9 | ||

|

|

04a5e17451 | ||

|

|

47065c8042 | ||

|

|

488c778736 | ||

|

|

d10a7bcc75 | ||

|

|

afe44a2537 | ||

|

|

9eadafe850 | ||

|

|

dab3eefcc0 | ||

|

|

2b9a6b28d8 | ||

|

|

465f98ca2b | ||

|

|

a0312be4fd | ||

|

|

4a5161372b | ||

|

|

4c9921f752 | ||

|

|

6dd72d40ee | ||

|

|

db49c234bb | ||

|

|

4a9df0c4d9 | ||

|

|

461573c2ba | ||

|

|

291992753f | ||

|

|

fcefe7ac38 | ||

|

|

7da712fcff | ||

|

|

2fd8687624 | ||

|

|

639b1f8336 | ||

|

|

ab3b83e42a | ||

|

|

4818629c40 | ||

|

|

61784c860a | ||

|

|

d5667254f2 | ||

|

|

af2b93983f | ||

|

|

8281301cbd | ||

|

|

0043ab8371 | ||

|

|

500eaace82 | ||

|

|

28e8540c78 | ||

|

|

69adf682e2 | ||

|

|

69cd1ff6e1 | ||

|

|

415d67cc32 | ||

|

|

46a2fec79b | ||

|

|

560b322fca | ||

|

|

effe17ac85 | ||

|

|

7699acfc1b | ||

|

|

6e058240b3 | ||

|

|

f005c6bc44 | ||

|

|

7be462599f | ||

|

|

271ab432d9 | ||

|

|

4114777a4e | ||

|

|

9189a54442 | ||

|

|

b95ee762e3 | ||

|

|

9e3c4dc06b | ||

|

|

1891a3ac86 | ||

|

|

9ecdcac06d | ||

|

|

790cb6a2e1 | ||

|

|

4a98e5f025 | ||

|

|

507abc1d84 | ||

|

|

9b732fbbad | ||

|

|

220f1c6fc3 | ||

|

|

7a950c67b6 | ||

|

|

78f625dc8c | ||

|

|

211d26a3ed | ||

|

|

dce2bc6326 | ||

|

|

90e5d7f6f0 | ||

|

|

71d4e0f9e6 | ||

|

|

580b4534e0 | ||

|

|

fc835e09c6 | ||

|

|

c6e782a637 | ||

|

|

1ddfbfc833 | ||

|

|

dbf637fe0f | ||

|

|

110e129622 | ||

|

|

677e9d1b54 | ||

|

|

ad2adb905e | ||

|

|

5e9de7ac14 | ||

|

|

c63fb8380c | ||

|

|

2d39acc224 | ||

|

|

e68358e05f | ||

|

|

a96f10edf0 | ||

|

|

f03d94935b | ||

|

|

9c1320cd95 | ||

|

|

4f2ae588a5 | ||

|

|

eff51034b7 | ||

|

|

18832dc448 | ||

|

|

5262ae8907 | ||

|

|

7f251679fa | ||

|

|

5f5920b427 | ||

|

|

65a16d058a | ||

|

|

a73484d23a | ||

|

|

47887a20c6 | ||

|

|

9465c6f198 | ||

|

|

c09872c8c2 | ||

|

|

b0501cc80d | ||

|

|

f0792db6b3 | ||

|

|

e1514c901b | ||

|

|

e90c5003ae | ||

|

|

92a0d5d52c | ||

|

|

8912cb5323 | ||

|

|

d008c19149 | ||

|

|

e844b6444a | ||

|

|

02606cdce2 | ||

|

|

0081720f0e | ||

|

|

cca1e92868 | ||

|

|

69b774a074 | ||

|

|

5656b03fb4 | ||

|

|

02d0dcbb7f | ||

|

|

7b2e06df12 | ||

|

|

4259ae63d7 | ||

|

|

d7b11803bc | ||

|

|

fed298a6d4 | ||

|

|

51832385b1 |

51

.github/ISSUE_TEMPLATE/bug_report.md

vendored

Normal file

@@ -0,0 +1,51 @@

|

||||

---

|

||||

name: 报告Bug

|

||||

about: 报告KnowStreaming的相关Bug

|

||||

title: ''

|

||||

labels: bug

|

||||

assignees: ''

|

||||

|

||||

---

|

||||

|

||||

- [ ] 我已经在 [issues](https://github.com/didi/KnowStreaming/issues) 搜索过相关问题了,并没有重复的。

|

||||

|

||||

你是否希望来认领这个Bug。

|

||||

|

||||

「 Y / N 」

|

||||

|

||||

### 环境信息

|

||||

|

||||

* KnowStreaming version : <font size=4 color =red> xxx </font>

|

||||

* Operating System version : <font size=4 color =red> xxx </font>

|

||||

* Java version : <font size=4 color =red> xxx </font>

|

||||

|

||||

|

||||

### 重现该问题的步骤

|

||||

|

||||

1. xxx

|

||||

|

||||

|

||||

|

||||

2. xxx

|

||||

|

||||

|

||||

3. xxx

|

||||

|

||||

|

||||

|

||||

### 预期结果

|

||||

|

||||

<!-- 写下应该出现的预期结果?-->

|

||||

|

||||

### 实际结果

|

||||

|

||||

<!-- 实际发生了什么? -->

|

||||

|

||||

|

||||

---

|

||||

|

||||

如果有异常,请附上异常Trace:

|

||||

|

||||

```

|

||||

Just put your stack trace here!

|

||||

```

|

||||

8

.github/ISSUE_TEMPLATE/config.yml

vendored

Normal file

@@ -0,0 +1,8 @@

|

||||

blank_issues_enabled: true

|

||||

contact_links:

|

||||

- name: 讨论问题

|

||||

url: https://github.com/didi/KnowStreaming/discussions/new

|

||||

about: 发起问题、讨论 等等

|

||||

- name: KnowStreaming官网

|

||||

url: https://knowstreaming.com/

|

||||

about: KnowStreaming website

|

||||

26

.github/ISSUE_TEMPLATE/detail_optimizing.md

vendored

Normal file

@@ -0,0 +1,26 @@

|

||||

---

|

||||

name: 优化建议

|

||||

about: 相关功能优化建议

|

||||

title: ''

|

||||

labels: Optimization Suggestions

|

||||

assignees: ''

|

||||

|

||||

---

|

||||

|

||||

- [ ] 我已经在 [issues](https://github.com/didi/KnowStreaming/issues) 搜索过相关问题了,并没有重复的。

|

||||

|

||||

你是否希望来认领这个优化建议。

|

||||

|

||||

「 Y / N 」

|

||||

|

||||

### 环境信息

|

||||

|

||||

* KnowStreaming version : <font size=4 color =red> xxx </font>

|

||||

* Operating System version : <font size=4 color =red> xxx </font>

|

||||

* Java version : <font size=4 color =red> xxx </font>

|

||||

|

||||

### 需要优化的功能点

|

||||

|

||||

|

||||

### 建议如何优化

|

||||

|

||||

20

.github/ISSUE_TEMPLATE/feature_request.md

vendored

Normal file

@@ -0,0 +1,20 @@

|

||||

---

|

||||

name: 提议新功能/需求

|

||||

about: 给KnowStreaming提一个功能需求

|

||||

title: ''

|

||||

labels: feature

|

||||

assignees: ''

|

||||

|

||||

---

|

||||

|

||||

- [ ] 我在 [issues](https://github.com/didi/KnowStreaming/issues) 中并未搜索到与此相关的功能需求。

|

||||

- [ ] 我在 [release note](https://github.com/didi/KnowStreaming/releases) 已经发布的版本中并没有搜到相关功能.

|

||||

|

||||

你是否希望来认领这个Feature。

|

||||

|

||||

「 Y / N 」

|

||||

|

||||

|

||||

## 这里描述需求

|

||||

<!--请尽可能的描述清楚您的需求 -->

|

||||

|

||||

12

.github/ISSUE_TEMPLATE/question.md

vendored

Normal file

@@ -0,0 +1,12 @@

|

||||

---

|

||||

name: 提个问题

|

||||

about: 问KnowStreaming相关问题

|

||||

title: ''

|

||||

labels: question

|

||||

assignees: ''

|

||||

|

||||

---

|

||||

|

||||

- [ ] 我已经在 [issues](https://github.com/didi/KnowStreaming/issues) 搜索过相关问题了,并没有重复的。

|

||||

|

||||

## 在这里提出你的问题

|

||||

22

.github/PULL_REQUEST_TEMPLATE.md

vendored

Normal file

@@ -0,0 +1,22 @@

|

||||

请不要在没有先创建Issue的情况下创建Pull Request。

|

||||

|

||||

## 变更的目的是什么

|

||||

|

||||

XXXXX

|

||||

|

||||

## 简短的更新日志

|

||||

|

||||

XX

|

||||

|

||||

## 验证这一变化

|

||||

|

||||

XXXX

|

||||

|

||||

请遵循此清单,以帮助我们快速轻松地整合您的贡献:

|

||||

|

||||

* [ ] 确保有针对更改提交的 Github issue(通常在您开始处理之前)。诸如拼写错误之类的琐碎更改不需要 Github issue。您的Pull Request应该只解决这个问题,而不需要进行其他更改—— 一个 PR 解决一个问题。

|

||||

* [ ] 格式化 Pull Request 标题,如[ISSUE #123] support Confluent Schema Registry。 Pull Request 中的每个提交都应该有一个有意义的主题行和正文。

|

||||

* [ ] 编写足够详细的Pull Request描述,以了解Pull Request的作用、方式和原因。

|

||||

* [ ] 编写必要的单元测试来验证您的逻辑更正。如果提交了新功能或重大更改,请记住在test 模块中添加 integration-test

|

||||

* [ ] 确保编译通过,集成测试通过

|

||||

|

||||

226

.gitignore

vendored

@@ -1,114 +1,112 @@

|

||||

### Intellij ###

|

||||

# Covers JetBrains IDEs: IntelliJ, RubyMine, PhpStorm, AppCode, PyCharm, CLion, Android Studio and Webstorm

|

||||

|

||||

*.iml

|

||||

|

||||

## Directory-based project format:

|

||||

.idea/

|

||||

# if you remove the above rule, at least ignore the following:

|

||||

|

||||

# User-specific stuff:

|

||||

# .idea/workspace.xml

|

||||

# .idea/tasks.xml

|

||||

# .idea/dictionaries

|

||||

# .idea/shelf

|

||||

|

||||

# Sensitive or high-churn files:

|

||||

.idea/dataSources.ids

|

||||

.idea/dataSources.xml

|

||||

.idea/sqlDataSources.xml

|

||||

.idea/dynamic.xml

|

||||

.idea/uiDesigner.xml

|

||||

|

||||

|

||||

# Mongo Explorer plugin:

|

||||

.idea/mongoSettings.xml

|

||||

|

||||

## File-based project format:

|

||||

*.ipr

|

||||

*.iws

|

||||

|

||||

## Plugin-specific files:

|

||||

|

||||

# IntelliJ

|

||||

/out/

|

||||

|

||||

# mpeltonen/sbt-idea plugin

|

||||

.idea_modules/

|

||||

|

||||

# JIRA plugin

|

||||

atlassian-ide-plugin.xml

|

||||

|

||||

# Crashlytics plugin (for Android Studio and IntelliJ)

|

||||

com_crashlytics_export_strings.xml

|

||||

crashlytics.properties

|

||||

crashlytics-build.properties

|

||||

fabric.properties

|

||||

|

||||

|

||||

### Java ###

|

||||

*.class

|

||||

|

||||

# Mobile Tools for Java (J2ME)

|

||||

.mtj.tmp/

|

||||

|

||||

# Package Files #

|

||||

*.jar

|

||||

*.war

|

||||

*.ear

|

||||

*.tar.gz

|

||||

|

||||

# virtual machine crash logs, see http://www.java.com/en/download/help/error_hotspot.xml

|

||||

hs_err_pid*

|

||||

|

||||

|

||||

### OSX ###

|

||||

.DS_Store

|

||||

.AppleDouble

|

||||

.LSOverride

|

||||

|

||||

# Icon must end with two \r

|

||||

Icon

|

||||

|

||||

|

||||

# Thumbnails

|

||||

._*

|

||||

|

||||

# Files that might appear in the root of a volume

|

||||

.DocumentRevisions-V100

|

||||

.fseventsd

|

||||

.Spotlight-V100

|

||||

.TemporaryItems

|

||||

.Trashes

|

||||

.VolumeIcon.icns

|

||||

|

||||

# Directories potentially created on remote AFP share

|

||||

.AppleDB

|

||||

.AppleDesktop

|

||||

Network Trash Folder

|

||||

Temporary Items

|

||||

.apdisk

|

||||

|

||||

/target

|

||||

target/

|

||||

*.log

|

||||

*.log.*

|

||||

*.bak

|

||||

*.vscode

|

||||

*/.vscode/*

|

||||

*/.vscode

|

||||

*/velocity.log*

|

||||

*/*.log

|

||||

*/*.log.*

|

||||

node_modules/

|

||||

node_modules/*

|

||||

workspace.xml

|

||||

/output/*

|

||||

.gitversion

|

||||

node_modules/*

|

||||

out/*

|

||||

dist/

|

||||

dist/*

|

||||

kafka-manager-web/src/main/resources/templates/

|

||||

.DS_Store

|

||||

kafka-manager-console/package-lock.json

|

||||

### Intellij ###

|

||||

# Covers JetBrains IDEs: IntelliJ, RubyMine, PhpStorm, AppCode, PyCharm, CLion, Android Studio and Webstorm

|

||||

|

||||

*.iml

|

||||

|

||||

## Directory-based project format:

|

||||

.idea/

|

||||

# if you remove the above rule, at least ignore the following:

|

||||

|

||||

# User-specific stuff:

|

||||

# .idea/workspace.xml

|

||||

# .idea/tasks.xml

|

||||

# .idea/dictionaries

|

||||

# .idea/shelf

|

||||

|

||||

# Sensitive or high-churn files:

|

||||

.idea/dataSources.ids

|

||||

.idea/dataSources.xml

|

||||

.idea/sqlDataSources.xml

|

||||

.idea/dynamic.xml

|

||||

.idea/uiDesigner.xml

|

||||

|

||||

|

||||

# Mongo Explorer plugin:

|

||||

.idea/mongoSettings.xml

|

||||

|

||||

## File-based project format:

|

||||

*.ipr

|

||||

*.iws

|

||||

|

||||

## Plugin-specific files:

|

||||

|

||||

# IntelliJ

|

||||

/out/

|

||||

|

||||

# mpeltonen/sbt-idea plugin

|

||||

.idea_modules/

|

||||

|

||||

# JIRA plugin

|

||||

atlassian-ide-plugin.xml

|

||||

|

||||

# Crashlytics plugin (for Android Studio and IntelliJ)

|

||||

com_crashlytics_export_strings.xml

|

||||

crashlytics.properties

|

||||

crashlytics-build.properties

|

||||

fabric.properties

|

||||

|

||||

|

||||

### Java ###

|

||||

*.class

|

||||

|

||||

# Mobile Tools for Java (J2ME)

|

||||

.mtj.tmp/

|

||||

|

||||

# Package Files #

|

||||

*.jar

|

||||

*.war

|

||||

*.ear

|

||||

*.tar.gz

|

||||

|

||||

# virtual machine crash logs, see http://www.java.com/en/download/help/error_hotspot.xml

|

||||

hs_err_pid*

|

||||

|

||||

|

||||

### OSX ###

|

||||

.DS_Store

|

||||

.AppleDouble

|

||||

.LSOverride

|

||||

|

||||

# Icon must end with two \r

|

||||

Icon

|

||||

|

||||

|

||||

# Thumbnails

|

||||

._*

|

||||

|

||||

# Files that might appear in the root of a volume

|

||||

.DocumentRevisions-V100

|

||||

.fseventsd

|

||||

.Spotlight-V100

|

||||

.TemporaryItems

|

||||

.Trashes

|

||||

.VolumeIcon.icns

|

||||

|

||||

# Directories potentially created on remote AFP share

|

||||

.AppleDB

|

||||

.AppleDesktop

|

||||

Network Trash Folder

|

||||

Temporary Items

|

||||

.apdisk

|

||||

|

||||

/target

|

||||

target/

|

||||

*.log

|

||||

*.log.*

|

||||

*.bak

|

||||

*.vscode

|

||||

*/.vscode/*

|

||||

*/.vscode

|

||||

*/velocity.log*

|

||||

*/*.log

|

||||

*/*.log.*

|

||||

node_modules/

|

||||

node_modules/*

|

||||

workspace.xml

|

||||

/output/*

|

||||

.gitversion

|

||||

out/*

|

||||

dist/

|

||||

dist/*

|

||||

km-rest/src/main/resources/templates/

|

||||

*dependency-reduced-pom*

|

||||

74

CODE_OF_CONDUCT.md

Normal file

@@ -0,0 +1,74 @@

|

||||

|

||||

# Contributor Covenant Code of Conduct

|

||||

|

||||

## Our Pledge

|

||||

|

||||

In the interest of fostering an open and welcoming environment, we as

|

||||

contributors and maintainers pledge to making participation in our project and

|

||||

our community a harassment-free experience for everyone, regardless of age, body

|

||||

size, disability, ethnicity, gender identity and expression, level of experience,

|

||||

education, socio-economic status, nationality, personal appearance, race,

|

||||

religion, or sexual identity and orientation.

|

||||

|

||||

## Our Standards

|

||||

|

||||

Examples of behavior that contributes to creating a positive environment

|

||||

include:

|

||||

|

||||

* Using welcoming and inclusive language

|

||||

* Being respectful of differing viewpoints and experiences

|

||||

* Gracefully accepting constructive criticism

|

||||

* Focusing on what is best for the community

|

||||

* Showing empathy towards other community members

|

||||

|

||||

Examples of unacceptable behavior by participants include:

|

||||

|

||||

* The use of sexualized language or imagery and unwelcome sexual attention or

|

||||

advances

|

||||

* Trolling, insulting/derogatory comments, and personal or political attacks

|

||||

* Public or private harassment

|

||||

* Publishing others' private information, such as a physical or electronic

|

||||

address, without explicit permission

|

||||

* Other conduct which could reasonably be considered inappropriate in a

|

||||

professional setting

|

||||

|

||||

## Our Responsibilities

|

||||

|

||||

Project maintainers are responsible for clarifying the standards of acceptable

|

||||

behavior and are expected to take appropriate and fair corrective action in

|

||||

response to any instances of unacceptable behavior.

|

||||

|

||||

Project maintainers have the right and responsibility to remove, edit, or

|

||||

reject comments, commits, code, wiki edits, issues, and other contributions

|

||||

that are not aligned to this Code of Conduct, or to ban temporarily or

|

||||

permanently any contributor for other behaviors that they deem inappropriate,

|

||||

threatening, offensive, or harmful.

|

||||

|

||||

## Scope

|

||||

|

||||

This Code of Conduct applies both within project spaces and in public spaces

|

||||

when an individual is representing the project or its community. Examples of

|

||||

representing a project or community include using an official project e-mail

|

||||

address, posting via an official social media account, or acting as an appointed

|

||||

representative at an online or offline event. Representation of a project may be

|

||||

further defined and clarified by project maintainers.

|

||||

|

||||

## Enforcement

|

||||

|

||||

Instances of abusive, harassing, or otherwise unacceptable behavior may be

|

||||

reported by contacting the project team at shirenchuang@didiglobal.com . All

|

||||

complaints will be reviewed and investigated and will result in a response that

|

||||

is deemed necessary and appropriate to the circumstances. The project team is

|

||||

obligated to maintain confidentiality with regard to the reporter of an incident.

|

||||

Further details of specific enforcement policies may be posted separately.

|

||||

|

||||

Project maintainers who do not follow or enforce the Code of Conduct in good

|

||||

faith may face temporary or permanent repercussions as determined by other

|

||||

members of the project's leadership.

|

||||

|

||||

## Attribution

|

||||

|

||||

This Code of Conduct is adapted from the [Contributor Covenant][homepage], version 1.4,

|

||||

available at https://www.contributor-covenant.org/version/1/4/code-of-conduct.html

|

||||

|

||||

[homepage]: https://www.contributor-covenant.org

|

||||

158

CONTRIBUTING.md

@@ -1,28 +1,150 @@

|

||||

# Contribution Guideline

|

||||

|

||||

Thanks for considering to contribute this project. All issues and pull requests are highly appreciated.

|

||||

|

||||

## Pull Requests

|

||||

|

||||

Before sending pull request to this project, please read and follow guidelines below.

|

||||

# 为KnowStreaming做贡献

|

||||

|

||||

1. Branch: We only accept pull request on `dev` branch.

|

||||

2. Coding style: Follow the coding style used in kafka-manager.

|

||||

3. Commit message: Use English and be aware of your spell.

|

||||

4. Test: Make sure to test your code.

|

||||

|

||||

Add device mode, API version, related log, screenshots and other related information in your pull request if possible.

|

||||

欢迎👏🏻来到KnowStreaming!本文档是关于如何为KnowStreaming做出贡献的指南。

|

||||

|

||||

NOTE: We assume all your contribution can be licensed under the [Apache License 2.0](LICENSE).

|

||||

如果您发现不正确或遗漏的内容, 请留下意见/建议。

|

||||

|

||||

## Issues

|

||||

## 行为守则

|

||||

请务必阅读并遵守我们的 [行为准则](./CODE_OF_CONDUCT.md).

|

||||

|

||||

We love clearly described issues. :)

|

||||

|

||||

Following information can help us to resolve the issue faster.

|

||||

|

||||

* Device mode and hardware information.

|

||||

* API version.

|

||||

* Logs.

|

||||

* Screenshots.

|

||||

* Steps to reproduce the issue.

|

||||

## 贡献

|

||||

|

||||

**KnowStreaming** 欢迎任何角色的新参与者,包括 **User** 、**Contributor**、**Committer**、**PMC** 。

|

||||

|

||||

我们鼓励新人积极加入 **KnowStreaming** 项目,从User到Contributor、Committer ,甚至是 PMC 角色。

|

||||

|

||||

为了做到这一点,新人需要积极地为 **KnowStreaming** 项目做出贡献。以下介绍如何对 **KnowStreaming** 进行贡献。

|

||||

|

||||

|

||||

### 创建/打开 Issue

|

||||

|

||||

如果您在文档中发现拼写错误、在代码中**发现错误**或想要**新功能**或想要**提供建议**,您可以在 GitHub 上[创建一个Issue](https://github.com/didi/KnowStreaming/issues/new/choose) 进行报告。

|

||||

|

||||

|

||||

如果您想直接贡献, 您可以选择下面标签的问题。

|

||||

|

||||

- [contribution welcome](https://github.com/didi/KnowStreaming/labels/contribution%20welcome) : 非常需要解决/新增 的Issues

|

||||

- [good first issue](https://github.com/didi/KnowStreaming/labels/good%20first%20issue): 对新人比较友好, 新人可以拿这个Issue来练练手热热身。

|

||||

|

||||

<font color=red ><b> 请注意,任何 PR 都必须与有效issue相关联。否则,PR 将被拒绝。</b></font>

|

||||

|

||||

|

||||

|

||||

### 开始你的贡献

|

||||

|

||||

**分支介绍**

|

||||

|

||||

我们将 `dev`分支作为开发分支, 说明这是一个不稳定的分支。

|

||||

|

||||

此外,我们的分支模型符合 [https://nvie.com/posts/a-successful-git-branching-model/](https://nvie.com/posts/a-successful-git-branching-model/). 我们强烈建议新人在创建PR之前先阅读上述文章。

|

||||

|

||||

|

||||

|

||||

**贡献流程**

|

||||

|

||||

为方便描述,我们这里定义一下2个名词:

|

||||

|

||||

自己Fork出来的仓库是私人仓库, 我们这里称之为 :**分叉仓库**

|

||||

Fork的源项目,我们称之为:**源仓库**

|

||||

|

||||

|

||||

现在,如果您准备好创建PR, 以下是贡献者的工作流程:

|

||||

|

||||

1. Fork [KnowStreaming](https://github.com/didi/KnowStreaming) 项目到自己的仓库

|

||||

|

||||

2. 从源仓库的`dev`拉取并创建自己的本地分支,例如: `dev`

|

||||

3. 在本地分支上对代码进行修改

|

||||

4. Rebase 开发分支, 并解决冲突

|

||||

5. commit 并 push 您的更改到您自己的**分叉仓库**

|

||||

6. 创建一个 Pull Request 到**源仓库**的`dev`分支中。

|

||||

7. 等待回复。如果回复的慢,请无情的催促。

|

||||

|

||||

|

||||

更为详细的贡献流程请看:[贡献流程](./docs/contributer_guide/贡献流程.md)

|

||||

|

||||

创建Pull Request时:

|

||||

|

||||

1. 请遵循 PR的 [模板](./.github/PULL_REQUEST_TEMPLATE.md)

|

||||

2. 请确保 PR 有相应的issue。

|

||||

3. 如果您的 PR 包含较大的更改,例如组件重构或新组件,请编写有关其设计和使用的详细文档(在对应的issue中)。

|

||||

4. 注意单个 PR 不能太大。如果需要进行大量更改,最好将更改分成几个单独的 PR。

|

||||

5. 在合并PR之前,尽量的将最终的提交信息清晰简洁, 将多次修改的提交尽可能的合并为一次提交。

|

||||

6. 创建 PR 后,将为PR分配一个或多个reviewers。

|

||||

|

||||

|

||||

<font color=red><b>如果您的 PR 包含较大的更改,例如组件重构或新组件,请编写有关其设计和使用的详细文档。</b></font>

|

||||

|

||||

|

||||

# 代码审查指南

|

||||

|

||||

Commiter将轮流review代码,以确保在合并前至少有一名Commiter

|

||||

|

||||

一些原则:

|

||||

|

||||

- 可读性——重要的代码应该有详细的文档。API 应该有 Javadoc。代码风格应与现有风格保持一致。

|

||||

- 优雅:新的函数、类或组件应该设计得很好。

|

||||

- 可测试性——单元测试用例应该覆盖 80% 的新代码。

|

||||

- 可维护性 - 遵守我们的编码规范。

|

||||

|

||||

|

||||

# 开发者

|

||||

|

||||

## 成为Contributor

|

||||

|

||||

只要成功提交并合并PR , 则为Contributor

|

||||

|

||||

贡献者名单请看:[贡献者名单](./docs/contributer_guide/开发者名单.md)

|

||||

|

||||

## 尝试成为Commiter

|

||||

|

||||

一般来说, 贡献8个重要的补丁并至少让三个不同的人来Review他们(您需要3个Commiter的支持)。

|

||||

然后请人给你提名, 您需要展示您的

|

||||

|

||||

1. 至少8个重要的PR和项目的相关问题

|

||||

2. 与团队合作的能力

|

||||

3. 了解项目的代码库和编码风格

|

||||

4. 编写好代码的能力

|

||||

|

||||

当前的Commiter可以通过在KnowStreaming中的Issue标签 `nomination`(提名)来提名您

|

||||

|

||||

1. 你的名字和姓氏

|

||||

2. 指向您的Git个人资料的链接

|

||||

3. 解释为什么你应该成为Commiter

|

||||

4. 详细说明提名人与您合作的3个PR以及相关问题,这些问题可以证明您的能力。

|

||||

|

||||

另外2个Commiter需要支持您的**提名**,如果5个工作日内没有人反对,您就是提交者,如果有人反对或者想要更多的信息,Commiter会讨论并通常达成共识(5个工作日内) 。

|

||||

|

||||

|

||||

# 开源奖励计划

|

||||

|

||||

|

||||

我们非常欢迎开发者们为KnowStreaming开源项目贡献一份力量,相应也将给予贡献者激励以表认可与感谢。

|

||||

|

||||

|

||||

## 参与贡献

|

||||

|

||||

1. 积极参与 Issue 的讨论,如答疑解惑、提供想法或报告无法解决的错误(Issue)

|

||||

2. 撰写和改进项目的文档(Wiki)

|

||||

3. 提交补丁优化代码(Coding)

|

||||

|

||||

|

||||

## 你将获得

|

||||

|

||||

1. 加入KnowStreaming开源项目贡献者名单并展示

|

||||

2. KnowStreaming开源贡献者证书(纸质&电子版)

|

||||

3. KnowStreaming贡献者精美大礼包(KnowStreamin/滴滴 周边)

|

||||

|

||||

|

||||

## 相关规则

|

||||

|

||||

- Contributer和Commiter都会有对应的证书和对应的礼包

|

||||

- 每季度有KnowStreaming项目团队评选出杰出贡献者,颁发相应证书。

|

||||

- 年末进行年度评选

|

||||

|

||||

贡献者名单请看:[贡献者名单](./docs/contributer_guide/开发者名单.md)

|

||||

41

Dockerfile

@@ -1,41 +0,0 @@

|

||||

ARG MAVEN_VERSION=3.8.4-openjdk-8-slim

|

||||

ARG JAVA_VERSION=8-jdk-alpine3.9

|

||||

FROM maven:${MAVEN_VERSION} AS builder

|

||||

ARG CONSOLE_ENABLE=true

|

||||

|

||||

WORKDIR /opt

|

||||

COPY . .

|

||||

COPY distribution/conf/settings.xml /root/.m2/settings.xml

|

||||

|

||||

# whether to build console

|

||||

RUN set -eux; \

|

||||

if [ $CONSOLE_ENABLE = 'false' ]; then \

|

||||

sed -i "/kafka-manager-console/d" pom.xml; \

|

||||

fi \

|

||||

&& mvn -Dmaven.test.skip=true clean install -U

|

||||

|

||||

FROM openjdk:${JAVA_VERSION}

|

||||

|

||||

RUN sed -i 's/dl-cdn.alpinelinux.org/mirrors.aliyun.com/g' /etc/apk/repositories && apk add --no-cache tini

|

||||

|

||||

ENV TZ=Asia/Shanghai

|

||||

ENV AGENT_HOME=/opt/agent/

|

||||

|

||||

COPY --from=builder /opt/kafka-manager-web/target/kafka-manager.jar /opt

|

||||

COPY --from=builder /opt/container/dockerfiles/docker-depends/config.yaml $AGENT_HOME

|

||||

COPY --from=builder /opt/container/dockerfiles/docker-depends/jmx_prometheus_javaagent-0.15.0.jar $AGENT_HOME

|

||||

COPY --from=builder /opt/distribution/conf/application-docker.yml /opt

|

||||

|

||||

WORKDIR /opt

|

||||

|

||||

ENV JAVA_AGENT="-javaagent:$AGENT_HOME/jmx_prometheus_javaagent-0.15.0.jar=9999:$AGENT_HOME/config.yaml"

|

||||

ENV JAVA_HEAP_OPTS="-Xms1024M -Xmx1024M -Xmn100M "

|

||||

ENV JAVA_OPTS="-verbose:gc \

|

||||

-XX:MaxMetaspaceSize=256M -XX:+DisableExplicitGC -XX:+UseStringDeduplication \

|

||||

-XX:+UseG1GC -XX:+HeapDumpOnOutOfMemoryError -XX:-UseContainerSupport"

|

||||

|

||||

EXPOSE 8080 9999

|

||||

|

||||

ENTRYPOINT ["tini", "--"]

|

||||

|

||||

CMD [ "sh", "-c", "java -jar $JAVA_AGENT $JAVA_HEAP_OPTS $JAVA_OPTS kafka-manager.jar --spring.config.location=application-docker.yml"]

|

||||

278

README.md

@@ -1,121 +1,157 @@

|

||||

|

||||

---

|

||||

|

||||

|

||||

**一站式`Apache Kafka`管控平台**

|

||||

|

||||

`LogiKM开源至今备受关注,考虑到开源项目应该更贴合Apache Kafka未来发展方向,经项目组慎重考虑,我们将其品牌升级成Know Streaming,新的大版本更新马上就绪,感谢大家一如既往的支持!也欢迎Kafka爱好者一起共建社区`

|

||||

|

||||

阅读本README文档,您可以了解到滴滴Know Streaming的用户群体、产品定位等信息,并通过体验地址,快速体验Kafka集群指标监控与运维管控的全流程。

|

||||

|

||||

|

||||

## 1 产品简介

|

||||

滴滴Know Streaming脱胎于滴滴内部多年的Kafka运营实践经验,是面向Kafka用户、Kafka运维人员打造的共享多租户Kafka云平台。专注于Kafka运维管控、监控告警、资源治理等核心场景,经历过大规模集群、海量大数据的考验。内部满意度高达90%的同时,还与多家知名企业达成商业化合作。

|

||||

|

||||

### 1.1 快速体验地址

|

||||

|

||||

- 体验地址(新的体验地址马上就来) http://117.51.150.133:8080 账号密码 admin/admin

|

||||

|

||||

### 1.2 体验地图

|

||||

相比较于同类产品的用户视角单一(大多为管理员视角),滴滴Logi-KafkaManager建立了基于分角色、多场景视角的体验地图。分别是:**用户体验地图、运维体验地图、运营体验地图**

|

||||

|

||||

#### 1.2.1 用户体验地图

|

||||

- 平台租户申请 :申请应用(App)作为Kafka中的用户名,并用 AppID+password作为身份验证

|

||||

- 集群资源申请 :按需申请、按需使用。可使用平台提供的共享集群,也可为应用申请独立的集群

|

||||

- Topic 申 请 :可根据应用(App)创建Topic,或者申请其他topic的读写权限

|

||||

- Topic 运 维 :Topic数据采样、调整配额、申请分区等操作

|

||||

- 指 标 监 控 :基于Topic生产消费各环节耗时统计,监控不同分位数性能指标

|

||||

- 消 费 组 运 维 :支持将消费偏移重置至指定时间或指定位置

|

||||

|

||||

#### 1.2.2 运维体验地图

|

||||

- 多版本集群管控 :支持从`0.10.2`到`2.x`版本

|

||||

- 集 群 监 控 :集群Topic、Broker等多维度历史与实时关键指标查看,建立健康分体系

|

||||

- 集 群 运 维 :划分部分Broker作为Region,使用Region定义资源划分单位,并按照业务、保障能力区分逻辑集群

|

||||

- Broker 运 维 :包括优先副本选举等操作

|

||||

- Topic 运 维 :包括创建、查询、扩容、修改属性、迁移、下线等

|

||||

|

||||

|

||||

#### 1.2.3 运营体验地图

|

||||

- 资 源 治 理 :沉淀资源治理方法。针对Topic分区热点、分区不足等高频常见问题,沉淀资源治理方法,实现资源治理专家化

|

||||

- 资 源 审 批 :工单体系。Topic创建、调整配额、申请分区等操作,由专业运维人员审批,规范资源使用,保障平台平稳运行

|

||||

- 账 单 体 系 :成本控制。Topic资源、集群资源按需申请、按需使用。根据流量核算费用,帮助企业建设大数据成本核算体系

|

||||

|

||||

### 1.3 核心优势

|

||||

- 高 效 的 问 题 定 位 :监控多项核心指标,统计不同分位数据,提供种类丰富的指标监控报表,帮助用户、运维人员快速高效定位问题

|

||||

- 便 捷 的 集 群 运 维 :按照Region定义集群资源划分单位,将逻辑集群根据保障等级划分。在方便资源隔离、提高扩展能力的同时,实现对服务端的强管控

|

||||

- 专 业 的 资 源 治 理 :基于滴滴内部多年运营实践,沉淀资源治理方法,建立健康分体系。针对Topic分区热点、分区不足等高频常见问题,实现资源治理专家化

|

||||

- 友 好 的 运 维 生 态 :与Prometheus、Grafana、滴滴夜莺监控告警系统打通,集成指标分析、监控告警、集群部署、集群升级等能力。形成运维生态,凝练专家服务,使运维更高效

|

||||

|

||||

### 1.4 滴滴Logi-KafkaManager架构图

|

||||

|

||||

|

||||

|

||||

|

||||

## 2 相关文档

|

||||

|

||||

### 2.1 产品文档

|

||||

- [滴滴Know Streaming 安装手册](docs/install_guide/install_guide_cn.md)

|

||||

- [滴滴Know Streaming 接入集群](docs/user_guide/add_cluster/add_cluster.md)

|

||||

- [滴滴Know Streaming 用户使用手册](docs/user_guide/user_guide_cn.md)

|

||||

- [滴滴Know Streaming FAQ](docs/user_guide/faq.md)

|

||||

|

||||

### 2.2 社区文章

|

||||

- [滴滴云官网产品介绍](https://www.didiyun.com/production/logi-KafkaManager.html)

|

||||

- [7年沉淀之作--滴滴Logi日志服务套件](https://mp.weixin.qq.com/s/-KQp-Qo3WKEOc9wIR2iFnw)

|

||||

- [滴滴Know Streaming 一站式Kafka管控平台](https://mp.weixin.qq.com/s/9qSZIkqCnU6u9nLMvOOjIQ)

|

||||

- [滴滴Know Streaming 开源之路](https://xie.infoq.cn/article/0223091a99e697412073c0d64)

|

||||

- [滴滴Know Streaming 系列视频教程](https://space.bilibili.com/442531657/channel/seriesdetail?sid=571649)

|

||||

- [kafka最强最全知识图谱](https://www.szzdzhp.com/kafka/)

|

||||

- [滴滴Know Streaming新用户入门系列文章专栏 --石臻臻](https://www.szzdzhp.com/categories/LogIKM/)

|

||||

- [kafka实践(十五):滴滴开源Kafka管控平台 Know Streaming研究--A叶子叶来](https://blog.csdn.net/yezonggang/article/details/113106244)

|

||||

- [基于云原生应用管理平台Rainbond安装 滴滴Know Streaming](https://www.rainbond.com/docs/opensource-app/logikm/?channel=logikm)

|

||||

|

||||

## 3 Know Streaming开源用户交流群

|

||||

|

||||

|

||||

|

||||

想跟各个大佬交流Kafka Es 等中间件/大数据相关技术请 加微信进群。

|

||||

|

||||

微信加群:添加<font color=red>mike_zhangliang</font>、<font color=red>PenceXie</font>的微信号备注Know Streaming加群或关注公众号 云原生可观测性 回复 "Know Streaming加群"

|

||||

|

||||

## 4 知识星球

|

||||

|

||||

<img width="447" alt="image" src="https://user-images.githubusercontent.com/71620349/147314042-843a371a-48c0-4d9a-a65e-ca40236f3300.png">

|

||||

|

||||

<br>

|

||||

<center>

|

||||

✅我们正在组建国内最大最权威的

|

||||

</center>

|

||||

<br>

|

||||

<center>

|

||||

<font color=red size=5><b>【Kafka中文社区】</b></font>

|

||||

</center>

|

||||

|

||||

在这里你可以结交各大互联网Kafka大佬以及3000+Kafka爱好者,一起实现知识共享,实时掌控最新行业资讯,期待您的加入中~https://z.didi.cn/5gSF9

|

||||

|

||||

<font color=red size=5>有问必答~! </font>

|

||||

|

||||

<font color=red size=5>互动有礼~! </font>

|

||||

|

||||

PS:提问请尽量把问题一次性描述清楚,并告知环境信息情况哦~!如使用版本、操作步骤、报错/警告信息等,方便大V们快速解答~

|

||||

|

||||

## 5 项目成员

|

||||

|

||||

### 5.1 内部核心人员

|

||||

|

||||

`iceyuhui`、`liuyaguang`、`limengmonty`、`zhangliangmike`、`zhaoqingrong`、`xiepeng`、`nullhuangyiming`、`zengqiao`、`eilenexuzhe`、`huangjiaweihjw`、`zhaoyinrui`、`marzkonglingxu`、`joysunchao`、`石臻臻`

|

||||

|

||||

|

||||

### 5.2 外部贡献者

|

||||

|

||||

`fangjunyu`、`zhoutaiyang`

|

||||

|

||||

|

||||

## 6 协议

|

||||

|

||||

`Know Streaming`基于`Apache-2.0`协议进行分发和使用,更多信息参见[协议文件](./LICENSE)

|

||||

|

||||

## 7 Star History

|

||||

|

||||

[](https://star-history.com/#didi/KnowStreaming&Date)

|

||||

|

||||

|

||||

<p align="center">

|

||||

<img src="https://user-images.githubusercontent.com/71620349/185368586-aed82d30-1534-453d-86ff-ecfa9d0f35bd.png" width = "256" div align=center />

|

||||

|

||||

</p>

|

||||

|

||||

<p align="center">

|

||||

<a href="https://knowstreaming.com">产品官网</a> |

|

||||

<a href="https://github.com/didi/KnowStreaming/releases">下载地址</a> |

|

||||

<a href="https://doc.knowstreaming.com/product">文档资源</a> |

|

||||

<a href="https://demo.knowstreaming.com">体验环境</a>

|

||||

</p>

|

||||

|

||||

<p align="center">

|

||||

<!--最近一次提交时间-->

|

||||

<a href="https://img.shields.io/github/last-commit/didi/KnowStreaming">

|

||||

<img src="https://img.shields.io/github/last-commit/didi/KnowStreaming" alt="LastCommit">

|

||||

</a>

|

||||

|

||||

<!--最新版本-->

|

||||

<a href="https://github.com/didi/KnowStreaming/blob/master/LICENSE">

|

||||

<img src="https://img.shields.io/github/v/release/didi/KnowStreaming" alt="License">

|

||||

</a>

|

||||

|

||||

<!--License信息-->

|

||||

<a href="https://github.com/didi/KnowStreaming/blob/master/LICENSE">

|

||||

<img src="https://img.shields.io/github/license/didi/KnowStreaming" alt="License">

|

||||

</a>

|

||||

|

||||

<!--Open-Issue-->

|

||||

<a href="https://github.com/didi/KnowStreaming/issues">

|

||||

<img src="https://img.shields.io/github/issues-raw/didi/KnowStreaming" alt="Issues">

|

||||

</a>

|

||||

|

||||

<!--知识星球-->

|

||||

<a href="https://z.didi.cn/5gSF9">

|

||||

<img src="https://img.shields.io/badge/join-%E7%9F%A5%E8%AF%86%E6%98%9F%E7%90%83-red" alt="Slack">

|

||||

</a>

|

||||

|

||||

</p>

|

||||

|

||||

|

||||

---

|

||||

|

||||

|

||||

## `Know Streaming` 简介

|

||||

|

||||

`Know Streaming`是一套云原生的Kafka管控平台,脱胎于众多互联网内部多年的Kafka运营实践经验,专注于Kafka运维管控、监控告警、资源治理、多活容灾等核心场景。在用户体验、监控、运维管控上进行了平台化、可视化、智能化的建设,提供一系列特色的功能,极大地方便了用户和运维人员的日常使用,让普通运维人员都能成为Kafka专家。

|

||||

|

||||

我们现在正在收集 Know Streaming 用户信息,以帮助我们进一步改进 Know Streaming。

|

||||

请在 [issue#663](https://github.com/didi/KnowStreaming/issues/663) 上提供您的使用信息来支持我们:[谁在使用 Know Streaming](https://github.com/didi/KnowStreaming/issues/663)

|

||||

|

||||

|

||||

|

||||

整体具有以下特点:

|

||||

|

||||

- 👀 **零侵入、全覆盖**

|

||||

- 无需侵入改造 `Apache Kafka` ,一键便能纳管 `0.10.x` ~ `3.x.x` 众多版本的Kafka,包括 `ZK` 或 `Raft` 运行模式的版本,同时在兼容架构上具备良好的扩展性,帮助您提升集群管理水平;

|

||||

|

||||

- 🌪️ **零成本、界面化**

|

||||

- 提炼高频 CLI 能力,设计合理的产品路径,提供清新美观的 GUI 界面,支持 Cluster、Broker、Zookeeper、Topic、ConsumerGroup、Message、ACL、Connect 等组件 GUI 管理,普通用户5分钟即可上手;

|

||||

|

||||

- 👏 **云原生、插件化**

|

||||

- 基于云原生构建,具备水平扩展能力,只需要增加节点即可获取更强的采集及对外服务能力,提供众多可热插拔的企业级特性,覆盖可观测性生态整合、资源治理、多活容灾等核心场景;

|

||||

|

||||

- 🚀 **专业能力**

|

||||

- 集群管理:支持一键纳管,健康分析、核心组件观测 等功能;

|

||||

- 观测提升:多维度指标观测大盘、观测指标最佳实践 等功能;

|

||||

- 异常巡检:集群多维度健康巡检、集群多维度健康分 等功能;

|

||||

- 能力增强:集群负载均衡、Topic扩缩副本、Topic副本迁移 等功能;

|

||||

|

||||

|

||||

|

||||

**产品图**

|

||||

|

||||

<p align="center">

|

||||

|

||||

<img src="http://img-ys011.didistatic.com/static/dc2img/do1_sPmS4SNLX9m1zlpmHaLJ" width = "768" height = "473" div align=center />

|

||||

|

||||

</p>

|

||||

|

||||

|

||||

|

||||

|

||||

## 文档资源

|

||||

|

||||

**`开发相关手册`**

|

||||

|

||||

- [打包编译手册](docs/install_guide/源码编译打包手册.md)

|

||||

- [单机部署手册](docs/install_guide/单机部署手册.md)

|

||||

- [版本升级手册](docs/install_guide/版本升级手册.md)

|

||||

- [本地源码启动手册](docs/dev_guide/本地源码启动手册.md)

|

||||

|

||||

**`产品相关手册`**

|

||||

|

||||

- [产品使用指南](docs/user_guide/用户使用手册.md)

|

||||

- [2.x与3.x新旧对比手册](docs/user_guide/新旧对比手册.md)

|

||||

- [FAQ](docs/user_guide/faq.md)

|

||||

|

||||

|

||||

**点击 [这里](https://doc.knowstreaming.com/product),也可以从官网获取到更多文档**

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

## 成为社区贡献者

|

||||

|

||||

1. [贡献源码](https://doc.knowstreaming.com/product/10-contribution) 了解如何成为 Know Streaming 的贡献者

|

||||

2. [具体贡献流程](https://doc.knowstreaming.com/product/10-contribution#102-贡献流程)

|

||||

3. [开源激励计划](https://doc.knowstreaming.com/product/10-contribution#105-开源激励计划)

|

||||

4. [贡献者名单](https://doc.knowstreaming.com/product/10-contribution#106-贡献者名单)

|

||||

|

||||

|

||||

获取KnowStreaming开源社区证书。

|

||||

|

||||

## 加入技术交流群

|

||||

|

||||

**`1、知识星球`**

|

||||

|

||||

<p align="left">

|

||||

<img src="https://user-images.githubusercontent.com/71620349/185357284-fdff1dad-c5e9-4ddf-9a82-0be1c970980d.JPG" height = "180" div align=left />

|

||||

</p>

|

||||

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

<br/>

|

||||

|

||||

👍 我们正在组建国内最大,最权威的 **[Kafka中文社区](https://z.didi.cn/5gSF9)**

|

||||

|

||||

在这里你可以结交各大互联网的 Kafka大佬 以及 4000+ Kafka爱好者,一起实现知识共享,实时掌控最新行业资讯,期待 👏 您的加入中~ https://z.didi.cn/5gSF9

|

||||

|

||||

有问必答~! 互动有礼~!

|

||||

|

||||

PS: 提问请尽量把问题一次性描述清楚,并告知环境信息情况~!如使用版本、操作步骤、报错/警告信息等,方便大V们快速解答~

|

||||

|

||||

|

||||

|

||||

**`2、微信群`**

|

||||

|

||||

微信加群:添加`mike_zhangliang`、`PenceXie`的微信号备注KnowStreaming加群。

|

||||

<br/>

|

||||

|

||||

加群之前有劳点一下 star,一个小小的 star 是对KnowStreaming作者们努力建设社区的动力。

|

||||

|

||||

感谢感谢!!!

|

||||

|

||||

<img width="116" alt="wx" src="https://user-images.githubusercontent.com/71620349/192257217-c4ebc16c-3ad9-485d-a914-5911d3a4f46b.png">

|

||||

|

||||

## Star History

|

||||

|

||||

[](https://star-history.com/#didi/KnowStreaming&Date)

|

||||

|

||||

@@ -1,11 +1,290 @@

|

||||

|

||||

## v3.1.0

|

||||

|

||||

**Bug修复**

|

||||

- 修复重置 Group Offset 的提示信息中,缺少Dead状态也可进行重置的描述;

|

||||

- 修复新建 Topic 后,立即查看 Topic Messages 信息时,会提示 Topic 不存在的问题;

|

||||

- 修复副本变更时,优先副本选举未被正常处罚执行的问题;

|

||||

- 修复 git 目录不存在时,打包不能正常进行的问题;

|

||||

- 修复 KRaft 模式的 Kafka 集群,JMX PORT 显示 -1 的问题;

|

||||

|

||||

|

||||

**体验优化**

|

||||

- 优化Cluster、Broker、Topic、Group的健康分为健康状态;

|

||||

- 去除健康巡检配置中的权重信息;

|

||||

- 错误提示页面展示优化;

|

||||

- 前端打包编译依赖默认使用 taobao 镜像;

|

||||

- 重新设计优化导航栏的 icon ;

|

||||

|

||||

|

||||

**新增**

|

||||

- 个人头像下拉信息中,新增产品版本信息;

|

||||

- 多集群列表页面,新增集群健康状态分布信息;

|

||||

|

||||

|

||||

**Kafka ZK 部分 (v3.1.0版本正式发布)**

|

||||

- 新增 ZK 集群的指标大盘信息;

|

||||

- 新增 ZK 集群的服务状态概览信息;

|

||||

- 新增 ZK 集群的服务节点列表信息;

|

||||

- 新增 Kafka 在 ZK 的存储数据查看功能;

|

||||

- 新增 ZK 的健康巡检及健康状态计算;

|

||||

|

||||

|

||||

|

||||

---

|

||||

|

||||

|

||||

|

||||

**一站式`Apache Kafka`集群指标监控与运维管控平台**

|

||||

## v3.0.1

|

||||

|

||||

---

|

||||

**Bug修复**

|

||||

- 修复重置 Group Offset 时,提示信息中缺少 Dead 状态也可进行重置的信息;

|

||||

- 修复 Ldap 某个属性不存在时,会直接抛出空指针导致登陆失败的问题;

|

||||

- 修复集群 Topic 列表页,健康分详情信息中,检查时间展示错误的问题;

|

||||

- 修复更新健康检查结果时,出现死锁的问题;

|

||||

- 修复 Replica 索引模版错误的问题;

|

||||

- 修复 FAQ 文档中的错误链接;

|

||||

- 修复 Broker 的 TopN 指标不存在时,页面数据不展示的问题;

|

||||

- 修复 Group 详情页,图表时间范围选择不生效的问题;

|

||||

|

||||

|

||||

**体验优化**

|

||||

- 集群 Group 列表按照 Group 维度进行展示;

|

||||

- 优化避免因 ES 中该指标不存在,导致日志中出现大量空指针的问题;

|

||||

- 优化全局 Message & Notification 展示效果;

|

||||

- 优化 Topic 扩分区名称 & 描述展示;

|

||||

|

||||

|

||||

**新增**

|

||||

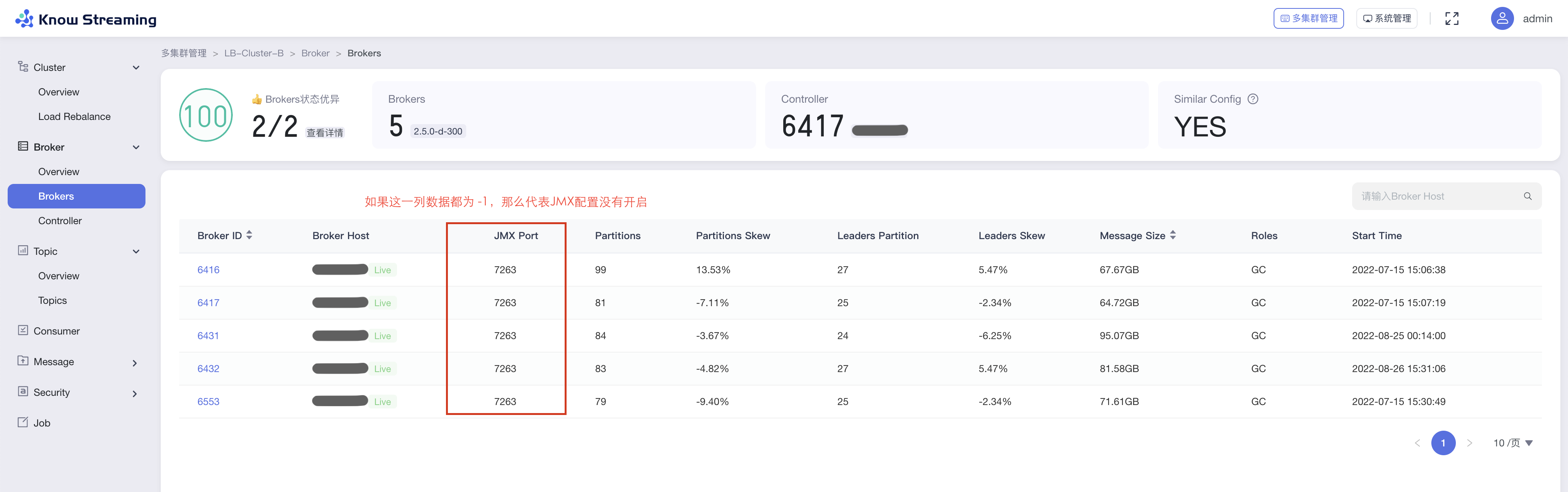

- Broker 列表页面,新增 JMX 是否成功连接的信息;

|

||||

|

||||

|

||||

**ZK 部分(未完全发布)**

|

||||

- 后端补充 Kafka ZK 指标采集,Kafka ZK 信息获取相关功能;

|

||||

- 增加本地缓存,避免同一采集周期内 ZK 指标重复采集;

|

||||

- 增加 ZK 节点采集失败跳过策略,避免不断对存在问题的节点不断尝试;

|

||||

- 修复 zkAvgLatency 指标转 Long 时抛出异常问题;

|

||||

- 修复 ks_km_zookeeper 表中,role 字段类型错误问题;

|

||||

|

||||

---

|

||||

|

||||

## v3.0.0

|

||||

|

||||

**Bug修复**

|

||||

- 修复 Group 指标防重复采集不生效问题

|

||||

- 修复自动创建 ES 索引模版失败问题

|

||||

- 修复 Group+Topic 列表中存在已删除Topic的问题

|

||||

- 修复使用 MySQL-8 ,因兼容问题, start_time 信息为 NULL 时,会导致创建任务失败的问题

|

||||

- 修复 Group 信息表更新时,出现死锁的问题

|

||||

- 修复图表补点逻辑与图表时间范围不适配的问题

|

||||

|

||||

|

||||

**体验优化**

|

||||

- 按照资源类别,拆分健康巡检任务

|

||||

- 优化 Group 详情页的指标为实时获取

|

||||

- 图表拖拽排序支持用户级存储

|

||||

- 多集群列表 ZK 信息展示兼容无 ZK 情况

|

||||

- Topic 详情消息预览支持复制功能

|

||||

- 部分内容大数字支持千位分割符展示

|

||||

|

||||

|

||||

**新增**

|

||||

- 集群信息中,新增 Zookeeper 客户端配置字段

|

||||

- 集群信息中,新增 Kafka 集群运行模式字段

|

||||

- 新增 docker-compose 的部署方式

|

||||

|

||||

---

|

||||

|

||||

## v3.0.0-beta.3

|

||||

|

||||

**文档**

|

||||

- FAQ 补充权限识别失败问题的说明

|

||||

- 同步更新文档,保持与官网一致

|

||||

|

||||

|

||||

**Bug修复**

|

||||

- Offset 信息获取时,过滤掉无 Leader 的分区

|

||||

- 升级 oshi-core 版本至 5.6.1 版本,修复 Windows 系统获取系统指标失败问题

|

||||

- 修复 JMX 连接被关闭后,未进行重建的问题

|

||||

- 修复因 DB 中 Broker 信息不存在导致 TotalLogSize 指标获取时抛空指针问题

|

||||

- 修复 dml-logi.sql 中,SQL 注释错误的问题

|

||||

- 修复 startup.sh 中,识别操作系统类型错误的问题

|

||||

- 修复配置管理页面删除配置失败的问题

|

||||

- 修复系统管理应用文件引用路径

|

||||

- 修复 Topic Messages 详情提示信息点击跳转 404 的问题

|

||||

- 修复扩副本时,当前副本数不显示问题

|

||||

|

||||

|

||||

**体验优化**

|

||||

- Topic-Messages 页面,增加返回数据的排序以及按照Earliest/Latest的获取方式

|

||||

- 优化 GroupOffsetResetEnum 类名为 OffsetTypeEnum,使得类名含义更准确

|

||||

- 移动 KafkaZKDAO 类,及 Kafka Znode 实体类的位置,使得 Kafka Zookeeper DAO 更加内聚及便于识别

|

||||

- 后端补充 Overview 页面指标排序的功能

|

||||

- 前端 Webpack 配置优化

|

||||

- Cluster Overview 图表取消放大展示功能

|

||||

- 列表页增加手动刷新功能

|

||||

- 接入/编辑集群,优化 JMX-PORT,Version 信息的回显,优化JMX信息的展示

|

||||

- 提高登录页面图片展示清晰度

|

||||

- 部分样式和文案优化

|

||||

|

||||

---

|

||||

|

||||

## v3.0.0-beta.2

|

||||

|

||||

**文档**

|

||||

- 新增登录系统对接文档

|

||||

- 优化前端工程打包构建部分文档说明

|

||||

- FAQ补充KnowStreaming连接特定JMX IP的说明

|

||||

|

||||

|

||||

**Bug修复**

|

||||

- 修复logi_security_oplog表字段过短,导致删除Topic等操作无法记录的问题

|

||||

- 修复ES查询时,抛java.lang.NumberFormatException: For input string: "{"value":0,"relation":"eq"}" 问题

|

||||

- 修复LogStartOffset和LogEndOffset指标单位错误问题

|

||||

- 修复进行副本变更时,旧副本数为NULL的问题

|

||||

- 修复集群Group列表,在第二页搜索时,搜索时返回的分页信息错误问题

|

||||

- 修复重置Offset时,返回的错误信息提示不一致的问题

|

||||

- 修复集群查看,系统查看,LoadRebalance等页面权限点缺失问题

|

||||

- 修复查询不存在的Topic时,错误信息提示不明显的问题

|

||||

- 修复Windows用户打包前端工程报错的问题

|

||||

- package-lock.json锁定前端依赖版本号,修复因依赖自动升级导致打包失败等问题

|

||||

- 系统管理子应用,补充后端返回的Code码拦截,解决后端接口返回报错不展示的问题

|

||||

- 修复用户登出后,依旧可以访问系统的问题

|

||||

- 修复巡检任务配置时,数值显示错误的问题

|

||||

- 修复Broker/Topic Overview 图表和图表详情问题

|

||||

- 修复Job扩缩副本任务明细数据错误的问题

|

||||

- 修复重置Offset时,分区ID,Offset数值无限制问题

|

||||

- 修复扩缩/迁移副本时,无法选中Kafka系统Topic的问题

|

||||

- 修复Topic的Config页面,编辑表单时不能正确回显当前值的问题

|

||||

- 修复Broker Card返回数据后依旧展示加载态的问题

|

||||

|

||||

|

||||

|

||||

**体验优化**

|

||||

- 优化默认用户密码为 admin/admin

|

||||

- 缩短新增集群后,集群信息加载的耗时

|

||||

- 集群Broker列表,增加Controller角色信息

|

||||

- 副本变更任务结束后,增加进行优先副本选举的操作

|

||||

- Task模块任务分为Metrics、Common、Metadata三类任务,每类任务配备独立线程池,减少对Job模块的线程池,以及不同类任务之间的相互影响

|

||||

- 删除代码中存在的多余无用文件

|

||||

- 自动新增ES索引模版及近7天索引,减少用户搭建时需要做的事项

|

||||

- 优化前端工程打包流程

|

||||

- 优化登录页文案,页面左侧栏内容,单集群详情样式,Topic列表趋势图等

|

||||

- 首次进入Broker/Topic图表详情时,进行预缓存数据从而优化体验

|

||||

- 优化Topic详情Partition Tab的展示

|

||||

- 多集群列表页增加编辑功能

|

||||

- 优化副本变更时,迁移时间支持分钟级别粒度

|

||||

- logi-security版本升级至2.10.13

|

||||

- logi-elasticsearch-client版本升级至1.0.24

|

||||

|

||||

|

||||

**能力提升**

|

||||

- 支持Ldap登录认证

|

||||

|

||||

---

|

||||

|

||||

## v3.0.0-beta.1

|

||||

|

||||

**文档**

|

||||

- 新增Task模块说明文档

|

||||

- FAQ补充 `Specified key was too long; max key length is 767 bytes ` 错误说明

|

||||

- FAQ补充 `出现ESIndexNotFoundException报错` 错误说明

|

||||

|

||||

|

||||

**Bug修复**

|

||||

- 修复 Consumer 点击 Stop 未停止检索的问题

|

||||

- 修复创建/编辑角色权限报错问题

|

||||

- 修复多集群管理/单集群详情均衡卡片状态错误问题

|

||||

- 修复版本列表未排序问题

|

||||

- 修复Raft集群Controller信息不断记录问题

|

||||

- 修复部分版本消费组描述信息获取失败问题

|

||||

- 修复分区Offset获取失败的日志中,缺少Topic名称信息问题

|

||||

- 修复GitHub图地址错误,及图裂问题

|

||||

- 修复Broker默认使用的地址和注释不一致问题

|

||||

- 修复 Consumer 列表分页不生效问题

|

||||

- 修复操作记录表operation_methods字段缺少默认值问题

|

||||

- 修复集群均衡表中move_broker_list字段无效的问题

|

||||

- 修复KafkaUser、KafkaACL信息获取时,日志一直重复提示不支持问题

|

||||

- 修复指标缺失时,曲线出现掉底的问题

|

||||

|

||||

|

||||

**体验优化**

|

||||

- 优化前端构建时间和打包体积,增加依赖打包的分包策略

|

||||

- 优化产品样式和文案展示

|

||||

- 优化ES客户端数为可配置

|

||||

- 优化日志中大量出现的MySQL Key冲突日志

|

||||

|

||||

|

||||

**能力提升**

|

||||

- 增加周期任务,用于主动创建缺少的ES模版及索引的能力,减少额外的脚本操作

|

||||

- 增加JMX连接的Broker地址可选择的能力

|

||||

|

||||

---

|

||||

|

||||

## v3.0.0-beta.0

|

||||

|

||||

**1、多集群管理**

|

||||

|

||||

- 增加健康监测体系、关键组件&指标 GUI 展示

|

||||

- 增加 2.8.x 以上 Kafka 集群接入,覆盖 0.10.x-3.x

|

||||

- 删除逻辑集群、共享集群、Region 概念

|

||||

|

||||

**2、Cluster 管理**

|

||||

|

||||

- 增加集群概览信息、集群配置变更记录

|

||||

- 增加 Cluster 健康分,健康检查规则支持自定义配置

|

||||

- 增加 Cluster 关键指标统计和 GUI 展示,支持自定义配置

|

||||

- 增加 Cluster 层 I/O、Disk 的 Load Reblance 功能,支持定时均衡任务(企业版)

|

||||

- 删除限流、鉴权功能

|

||||

- 删除 APPID 概念

|

||||

|

||||

**3、Broker 管理**

|

||||

|

||||

- 增加 Broker 健康分

|

||||

- 增加 Broker 关键指标统计和 GUI 展示,支持自定义配置

|

||||

- 增加 Broker 参数配置功能,需重启生效

|

||||

- 增加 Controller 变更记录

|

||||

- 增加 Broker Datalogs 记录

|

||||

- 删除 Leader Rebalance 功能

|

||||

- 删除 Broker 优先副本选举

|

||||

|

||||

**4、Topic 管理**

|

||||

|

||||

- 增加 Topic 健康分

|

||||

- 增加 Topic 关键指标统计和 GUI 展示,支持自定义配置

|

||||

- 增加 Topic 参数配置功能,可实时生效

|

||||

- 增加 Topic 批量迁移、Topic 批量扩缩副本功能

|

||||

- 增加查看系统 Topic 功能

|

||||

- 优化 Partition 分布的 GUI 展示

|

||||

- 优化 Topic Message 数据采样

|

||||

- 删除 Topic 过期概念

|

||||

- 删除 Topic 申请配额功能

|

||||

|

||||

**5、Consumer 管理**

|

||||

|

||||

- 优化了 ConsumerGroup 展示形式,增加 Consumer Lag 的 GUI 展示

|

||||

|

||||

**6、ACL 管理**

|

||||

|

||||

- 增加原生 ACL GUI 配置功能,可配置生产、消费、自定义多种组合权限

|

||||

- 增加 KafkaUser 功能,可自定义新增 KafkaUser

|

||||

|

||||

**7、消息测试(企业版)**

|

||||

|

||||

- 增加生产者消息模拟器,支持 Data、Flow、Header、Options 自定义配置(企业版)

|

||||

- 增加消费者消息模拟器,支持 Data、Flow、Header、Options 自定义配置(企业版)

|

||||

|

||||

**8、Job**

|

||||

|

||||

- 优化 Job 模块,支持任务进度管理

|

||||

|

||||

**9、系统管理**

|

||||

|

||||

- 优化用户、角色管理体系,支持自定义角色配置页面及操作权限

|

||||

- 优化审计日志信息

|

||||

- 删除多租户体系

|

||||

- 删除工单流程

|

||||

|

||||

---

|

||||

|

||||

## v2.6.0

|

||||

|

||||

@@ -40,6 +319,16 @@

|

||||

- 修复Dockerfile执行时提示缺少application.yml文件的问题

|

||||

- 修复逻辑集群更新时,会报空指针的问题

|

||||

|

||||

|

||||

## v2.5.0

|

||||

|

||||

版本上线时间:2021-07-10

|

||||

|

||||

### 体验优化

|

||||

- 更改产品名为LogiKM

|

||||

- 更新产品图标

|

||||

|

||||

|

||||

## v2.4.1+

|

||||

|

||||

版本上线时间:2021-05-21

|

||||

@@ -49,7 +338,7 @@

|

||||

- 增加接口调用可绕过登录的功能(v2.4.1)

|

||||

|

||||

### 体验优化

|

||||

- tomcat 版本提升至8.5.66(v2.4.2)

|

||||

- Tomcat 版本提升至8.5.66(v2.4.2)

|

||||

- op接口优化,拆分util接口为topic、leader两类接口(v2.4.1)

|

||||

- 简化Gateway配置的Key长度(v2.4.1)

|

||||

|

||||

|

||||

718

bin/init_es_template.sh

Normal file

@@ -0,0 +1,718 @@

|

||||

esaddr=127.0.0.1

|

||||

port=8060

|

||||

curl -s --connect-timeout 10 -o /dev/null http://${esaddr}:${port}/_cat/nodes >/dev/null 2>&1

|

||||

if [ "$?" != "0" ];then

|

||||

echo "Elasticserach 访问失败, 请安装完后检查并重新执行该脚本 "

|

||||

exit

|

||||

fi

|

||||

|

||||

curl -s --connect-timeout 10 -o /dev/null -X POST -H 'cache-control: no-cache' -H 'content-type: application/json' http://${esaddr}:${port}/_template/ks_kafka_broker_metric -d '{

|

||||

"order" : 10,

|

||||

"index_patterns" : [

|

||||

"ks_kafka_broker_metric*"

|

||||

],

|

||||

"settings" : {

|

||||

"index" : {

|

||||

"number_of_shards" : "10"

|

||||

}

|

||||

},

|

||||

"mappings" : {

|

||||

"properties" : {

|

||||

"brokerId" : {

|

||||

"type" : "long"

|

||||

},

|

||||